Искусственный интеллект

| Part of a series on |

| Artificial intelligence (AI) |

|---|

Искусственный интеллект ( ИИ ) в самом широком смысле — это интеллект , демонстрируемый машинами , в частности компьютерными системами . Это область исследований в области компьютерных наук , которая разрабатывает и изучает методы и программное обеспечение , позволяющие машинам воспринимать окружающую среду и использовать обучение и интеллект для выполнения действий, которые максимизируют их шансы на достижение определенных целей. [1] Такие машины можно назвать ИИ.

К числу громких приложений ИИ относятся передовые поисковые системы (например, Google Search ); рекомендательные системы (используемые YouTube , Amazon и Netflix ); виртуальные помощники (например, Google Assistant , Siri и Alexa ); автономные транспортные средства (например, Waymo ); генеративные и творческие инструменты (например, ChatGPT и AI art ); и сверхчеловеческая игра и анализ в стратегических играх (например, шахматы и Go ). Однако многие приложения ИИ не воспринимаются как ИИ: «Многие передовые ИИ просочились в общие приложения, часто не называясь ИИ, потому что как только что-то становится достаточно полезным и достаточно распространенным, оно больше не называется ИИ ». [2] [3]

Различные подобласти исследований ИИ сосредоточены вокруг конкретных целей и использования конкретных инструментов. Традиционные цели исследований ИИ включают рассуждение , представление знаний , планирование , обучение , обработку естественного языка , восприятие и поддержку робототехники . [a] Общий интеллект — способность выполнять любую задачу, выполняемую человеком, по крайней мере на равном уровне — входит в число долгосрочных целей области. [4] Для достижения этих целей исследователи ИИ адаптировали и интегрировали широкий спектр методов, включая поиск и математическую оптимизацию , формальную логику , искусственные нейронные сети и методы, основанные на статистике , исследовании операций и экономике . [b] ИИ также опирается на психологию , лингвистику , философию , нейронауку и другие области. [5]

Искусственный интеллект был основан как академическая дисциплина в 1956 году, [6] и эта область прошла через несколько циклов оптимизма на протяжении всей своей истории , [7] [8] за которыми следовали периоды разочарования и потери финансирования, известные как зимы ИИ . [9] [10] Финансирование и интерес значительно возросли после 2012 года, когда глубокое обучение превзошло предыдущие методы ИИ. [11] Этот рост еще больше ускорился после 2017 года с архитектурой трансформатора , [12] и к началу 2020-х годов многие миллиарды долларов были инвестированы в ИИ, и эта область пережила быстрый непрерывный прогресс в том, что стало известно как бум ИИ . Появление передового генеративного ИИ в разгар бума ИИ и его способность создавать и изменять контент выявили несколько непреднамеренных последствий и вреда в настоящем и вызвали обеспокоенность по поводу рисков ИИ и его долгосрочных эффектов в будущем, что вызвало дискуссии о регуляторной политике для обеспечения безопасности и преимуществ технологии .

Цели

Общая проблема моделирования (или создания) интеллекта была разбита на подзадачи. Они состоят из конкретных черт или возможностей, которые исследователи ожидают от интеллектуальной системы. Черты, описанные ниже, получили наибольшее внимание и охватывают область исследований ИИ. [a]

Рассуждение и решение проблем

Ранние исследователи разработали алгоритмы, которые имитировали пошаговые рассуждения, которые используют люди, когда решают головоломки или делают логические выводы . [13] К концу 1980-х и 1990-м годам были разработаны методы работы с неопределенной или неполной информацией, использующие концепции из теории вероятности и экономики . [14]

Многие из этих алгоритмов недостаточны для решения больших задач рассуждения, поскольку они испытывают «комбинаторный взрыв»: они становятся экспоненциально медленнее по мере роста задач. [15] Даже люди редко используют пошаговую дедукцию, которую могли моделировать ранние исследования ИИ. Они решают большинство своих задач, используя быстрые, интуитивные суждения. [16] Точное и эффективное рассуждение — нерешенная проблема.

Представление знаний

Представление знаний и инженерия знаний [17] позволяют программам ИИ разумно отвечать на вопросы и делать выводы о фактах реального мира. Формальные представления знаний используются в индексации и поиске на основе контента, [18] интерпретации сцен, [19] поддержке принятия клинических решений, [20] обнаружении знаний (извлечение «интересных» и действенных выводов из больших баз данных ), [21] и других областях. [22]

База знаний — это совокупность знаний, представленная в форме, которую может использовать программа. Онтология — это набор объектов, отношений, концепций и свойств, используемых определенной областью знаний. [23] Базы знаний должны представлять такие вещи, как объекты, свойства, категории и отношения между объектами; [24] ситуации, события, состояния и время; [25] причины и следствия; [26] знания о знаниях (то, что мы знаем о том, что знают другие люди); [27] рассуждения по умолчанию (то, что люди считают истинным, пока им не скажут иначе, и что останется истинным, даже если другие факты изменятся); [28] и многие другие аспекты и области знаний.

Среди наиболее сложных проблем в представлении знаний — широта знаний здравого смысла (набор атомарных фактов, которые знает средний человек, огромен); [29] и субсимвольная форма большинства знаний здравого смысла (большая часть того, что знают люди, не представлена в виде «фактов» или «утверждений», которые они могли бы выразить вербально). [16] Существует также сложность приобретения знаний , проблема получения знаний для приложений ИИ. [c]

Планирование и принятие решений

«Агент» — это все, что воспринимает и совершает действия в мире. Рациональный агент имеет цели или предпочтения и совершает действия, чтобы они произошли. [d] [32] В автоматизированном планировании у агента есть конкретная цель. [33] В автоматизированном принятии решений у агента есть предпочтения — есть некоторые ситуации, в которых он предпочел бы оказаться, и некоторые ситуации, которых он пытается избежать. Агент принятия решений присваивает каждой ситуации число (называемое « полезностью »), которое измеряет, насколько агент ее предпочитает. Для каждого возможного действия он может рассчитать « ожидаемую полезность »: полезность всех возможных результатов действия, взвешенную по вероятности того, что результат произойдет. Затем он может выбрать действие с максимальной ожидаемой полезностью. [34]

В классическом планировании агент точно знает, каким будет эффект любого действия. [35] Однако в большинстве реальных проблем агент может не быть уверен в ситуации, в которой он находится (она «неизвестна» или «ненаблюдаема»), и он может не знать наверняка, что произойдет после каждого возможного действия (она не «детерминирована»). Он должен выбрать действие, сделав вероятностное предположение, а затем переоценить ситуацию, чтобы увидеть, сработало ли действие. [36]

В некоторых задачах предпочтения агента могут быть неопределенными, особенно если в них участвуют другие агенты или люди. Их можно изучить (например, с помощью обратного обучения с подкреплением ), или агент может искать информацию для улучшения своих предпочтений. [37] Теория ценности информации может использоваться для оценки ценности исследовательских или экспериментальных действий. [38] Пространство возможных будущих действий и ситуаций обычно непреодолимо велико, поэтому агенты должны предпринимать действия и оценивать ситуации, будучи неуверенными в том, каким будет результат.

Процесс принятия решений Маркова имеет модель перехода , которая описывает вероятность того, что определенное действие изменит состояние определенным образом, и функцию вознаграждения , которая предоставляет полезность каждого состояния и стоимость каждого действия. Политика связывает решение с каждым возможным состоянием. Политика может быть рассчитана (например, путем итерации ), быть эвристической или ее можно изучить. [39]

Теория игр описывает рациональное поведение множества взаимодействующих агентов и используется в программах ИИ, которые принимают решения с участием других агентов. [40]

Обучение

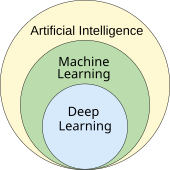

Машинное обучение — это изучение программ, которые могут автоматически улучшать свою производительность при выполнении заданной задачи. [41] Оно было частью ИИ с самого начала. [e]

Существует несколько видов машинного обучения. Неконтролируемое обучение анализирует поток данных, находит закономерности и делает прогнозы без какого-либо другого руководства. [44] Контролируемое обучение требует маркировки обучающих данных ожидаемыми ответами и бывает двух основных видов: классификация (где программа должна научиться предсказывать, к какой категории относится вход) и регрессия (где программа должна вывести числовую функцию на основе числового входа). [45]

В обучении с подкреплением агент вознаграждается за хорошие ответы и наказывается за плохие. Агент учится выбирать ответы, которые классифицируются как «хорошие». [46] Передача обучения — это когда знания, полученные при решении одной проблемы, применяются к новой проблеме. [47] Глубокое обучение — это тип машинного обучения, который пропускает входные данные через биологически вдохновленные искусственные нейронные сети для всех этих типов обучения. [48]

Теория вычислительного обучения может оценивать учащихся по вычислительной сложности , по сложности выборки (сколько требуется данных) или по другим понятиям оптимизации . [49]

Обработка естественного языка

Обработка естественного языка (NLP) [50] позволяет программам читать, писать и общаться на человеческих языках, таких как английский . Конкретные проблемы включают распознавание речи , синтез речи , машинный перевод , извлечение информации , поиск информации и ответы на вопросы . [51]

Ранние работы, основанные на генеративной грамматике и семантических сетях Ноама Хомского , испытывали трудности с разрешением неоднозначности слов [f], если только не ограничивались небольшими областями, называемыми « микромирами » (из-за проблемы знания здравого смысла [29] ). Маргарет Мастерман считала, что ключом к пониманию языков является значение, а не грамматика, и что тезаурусы , а не словари должны быть основой вычислительной языковой структуры.

Современные методы глубокого обучения для обработки естественного языка включают в себя внедрение слов (представление слов, как правило, в виде векторов , кодирующих их значение), [52] трансформаторы (архитектура глубокого обучения, использующая механизм внимания ), [53] и другие. [54] В 2019 году генеративные предварительно обученные языковые модели трансформатора (или «GPT») начали генерировать связный текст, [55] [56] и к 2023 году эти модели смогли получить баллы человеческого уровня на экзамене на адвоката , тесте SAT , тесте GRE и многих других реальных приложениях. [57]

Восприятие

Машинное восприятие — это способность использовать входные данные от датчиков (таких как камеры, микрофоны, беспроводные сигналы, активный лидар , сонар, радар и тактильные датчики ) для вывода аспектов мира. Компьютерное зрение — это способность анализировать визуальные входные данные. [58]

Область включает в себя распознавание речи , [59] классификацию изображений , [60] распознавание лиц , распознавание объектов , [61] отслеживание объектов , [62] и роботизированное восприятие . [63]

Социальный интеллект

Аффективные вычисления — это область, которая включает в себя системы, которые распознают, интерпретируют, обрабатывают или имитируют человеческие чувства, эмоции и настроение . [65] Например, некоторые виртуальные помощники запрограммированы на разговорную речь или даже на шутливые шутки; это делает их более чувствительными к эмоциональной динамике человеческого взаимодействия или иным образом облегчает взаимодействие человека с компьютером .

Однако это имеет тенденцию давать наивным пользователям нереалистичное представление об интеллекте существующих компьютерных агентов. [66] Умеренные успехи, связанные с аффективными вычислениями, включают текстовый анализ настроений и, в последнее время, мультимодальный анализ настроений , в котором ИИ классифицирует эффекты, демонстрируемые субъектом, записанным на видео. [67]

Общий интеллект

Машина с искусственным интеллектом должна быть способна решать широкий спектр задач с широтой и универсальностью, аналогичной человеческому интеллекту . [4]

Методы

Исследования ИИ используют широкий спектр методов для достижения вышеуказанных целей. [b]

Поиск и оптимизация

ИИ может решать многие проблемы, разумно перебирая множество возможных решений. [68] В ИИ используются два совершенно разных вида поиска: поиск в пространстве состояний и локальный поиск .

Поиск государственного пространства

Поиск в пространстве состояний просматривает дерево возможных состояний, чтобы попытаться найти целевое состояние. [69] Например, алгоритмы планирования просматривают деревья целей и подцелей, пытаясь найти путь к заданной цели, процесс, называемый анализом средств и целей . [70]

Простые исчерпывающие поиски [71] редко бывают достаточными для большинства реальных проблем: пространство поиска (количество мест для поиска) быстро увеличивается до астрономических чисел . Результатом является поиск, который слишком медленный или никогда не завершается. [15] « Эвристика » или «правила большого пальца» могут помочь расставить приоритеты в выборе, которые с большей вероятностью достигнут цели. [72]

Состязательный поиск используется для игровых программ, таких как шахматы или го. Он просматривает дерево возможных ходов и контрходов, ища выигрышную позицию. [73]

Локальный поиск

Локальный поиск использует математическую оптимизацию для поиска решения проблемы. Он начинается с некоторой формы догадки и совершенствует ее постепенно. [74]

Градиентный спуск — это тип локального поиска, который оптимизирует набор числовых параметров путем их постепенной корректировки для минимизации функции потерь . Варианты градиентного спуска обычно используются для обучения нейронных сетей , [75] через алгоритм обратного распространения .

Другим типом локального поиска является эволюционное вычисление , целью которого является итеративное улучшение набора возможных решений путем их «мутации» и «рекомбинации», выбирая только наиболее приспособленных для выживания в каждом поколении. [76]

Распределенные процессы поиска могут координироваться с помощью алгоритмов роевого интеллекта . Два популярных алгоритма роя, используемых в поиске, — это оптимизация роя частиц (вдохновленная стаями птиц ) и оптимизация колонии муравьев (вдохновленная муравьиными тропами ). [77]

Логика

Формальная логика используется для рассуждений и представления знаний . [78] Формальная логика существует в двух основных формах: пропозициональная логика (которая оперирует утверждениями, которые являются истинными или ложными, и использует логические связки , такие как «и», «или», «не» и «подразумевает») [79] и предикатная логика (которая также оперирует объектами, предикатами и отношениями и использует квантификаторы, такие как « Каждый X есть Y » и «Существуют некоторые X , которые являются Y »). [80]

Дедуктивное рассуждение в логике — это процесс доказательства нового утверждения ( вывода ) из других утверждений, которые даны и считаются истинными (предпосылки ) . [81] Доказательства могут быть структурированы в виде деревьев доказательств , в которых узлы помечены предложениями, а дочерние узлы связаны с родительскими узлами правилами вывода .

При наличии проблемы и набора предпосылок решение проблем сводится к поиску дерева доказательств, корневой узел которого помечен решением проблемы, а конечные узлы помечены предпосылками или аксиомами . В случае предложений Хорна поиск решения проблем может быть выполнен путем рассуждения вперед от предпосылок или назад от проблемы. [82] В более общем случае клаузальной формы логики первого порядка разрешение представляет собой единое правило вывода, свободное от аксиом, в котором проблема решается путем доказательства противоречия из предпосылок, которые включают отрицание решаемой проблемы. [83]

Вывод как в логике предложений Хорна, так и в логике первого порядка неразрешим , и, следовательно, не поддается обработке . Однако обратное рассуждение с предложениями Хорна, которое лежит в основе вычислений в языке логического программирования Пролог , является полным по Тьюрингу . Более того, его эффективность сопоставима с вычислениями в других символических языках программирования. [84]

Нечеткая логика присваивает «степень истины» от 0 до 1. Поэтому она может обрабатывать предложения, которые являются неопределенными и частично истинными. [85]

Немонотонная логика , включая логическое программирование с отрицанием как неудачей , предназначена для обработки рассуждений по умолчанию . [28] Были разработаны и другие специализированные версии логики для описания многих сложных областей.

Вероятностные методы неопределенных рассуждений

Многие проблемы в ИИ (включая рассуждения, планирование, обучение, восприятие и робототехнику) требуют, чтобы агент работал с неполной или неопределенной информацией. Исследователи ИИ разработали ряд инструментов для решения этих проблем, используя методы теории вероятностей и экономики. [86] Были разработаны точные математические инструменты, которые анализируют, как агент может делать выбор и планировать, используя теорию принятия решений , анализ решений , [87] и теорию ценности информации . [88] Эти инструменты включают такие модели, как марковские процессы принятия решений , [89] динамические сети принятия решений , [90] теория игр и проектирование механизмов . [91]

Байесовские сети [92] — это инструмент, который можно использовать для рассуждений (с использованием алгоритма байесовского вывода ), [g] [94] обучения (с использованием алгоритма максимизации ожидания ), [h] [96] планирования (с использованием сетей принятия решений ) [97] и восприятия (с использованием динамических байесовских сетей ). [90]

Вероятностные алгоритмы также могут использоваться для фильтрации, прогнозирования, сглаживания и поиска объяснений для потоков данных, тем самым помогая системам восприятия анализировать процессы, происходящие с течением времени (например, скрытые модели Маркова или фильтры Калмана ). [90]

Классификаторы и статистические методы обучения

Простейшие приложения ИИ можно разделить на два типа: классификаторы (например, «если блестящий, то бриллиант»), с одной стороны, и контроллеры (например, «если бриллиант, то подбери»), с другой стороны. Классификаторы [98] — это функции, которые используют сопоставление с образцом для определения наиболее близкого соответствия. Их можно точно настроить на основе выбранных примеров с использованием контролируемого обучения . Каждый образец (также называемый « наблюдением ») помечен определенным предопределенным классом. Все наблюдения, объединенные с их метками классов, известны как набор данных . Когда получено новое наблюдение, это наблюдение классифицируется на основе предыдущего опыта. [45]

Существует множество видов классификаторов. [99] Дерево решений — это самый простой и наиболее широко используемый символический алгоритм машинного обучения. [100] Алгоритм k-ближайших соседей был наиболее широко используемым аналоговым ИИ до середины 1990-х годов, а методы ядра, такие как машина опорных векторов (SVM), вытеснили k-ближайших соседей в 1990-х годах. [101] Сообщается, что наивный байесовский классификатор является «наиболее широко используемым обучающимся средством» [102] в Google, отчасти из-за его масштабируемости. [103] Нейронные сети также используются в качестве классификаторов. [104]

Искусственные нейронные сети

Искусственная нейронная сеть основана на наборе узлов, также известных как искусственные нейроны , которые в общих чертах моделируют нейроны в биологическом мозге. Она обучена распознавать закономерности; после обучения она может распознавать эти закономерности в новых данных. Есть вход, по крайней мере один скрытый слой узлов и выход. Каждый узел применяет функцию, и как только вес пересекает указанный порог, данные передаются на следующий слой. Сеть обычно называется глубокой нейронной сетью, если она имеет по крайней мере 2 скрытых слоя. [104]

Алгоритмы обучения для нейронных сетей используют локальный поиск для выбора весов, которые дадут правильный выход для каждого входа во время обучения. Наиболее распространенным методом обучения является алгоритм обратного распространения . [105] Нейронные сети учатся моделировать сложные отношения между входами и выходами и находить закономерности в данных. Теоретически нейронная сеть может изучить любую функцию. [106]

В нейронных сетях прямого распространения сигнал проходит только в одном направлении. [107] Рекуррентные нейронные сети возвращают выходной сигнал на вход, что позволяет сохранять кратковременные воспоминания о предыдущих входных событиях. Долговременная кратковременная память является наиболее успешной сетевой архитектурой для рекуррентных сетей. [108] Персептроны [109] используют только один слой нейронов; глубокое обучение [110] использует несколько слоев. Сверточные нейронные сети усиливают связь между нейронами, которые находятся «близко» друг к другу — это особенно важно при обработке изображений , где локальный набор нейронов должен идентифицировать «край», прежде чем сеть сможет идентифицировать объект. [111]

Глубокое обучение

Глубокое обучение [110] использует несколько слоев нейронов между входами и выходами сети. Несколько слоев могут постепенно извлекать более высокоуровневые признаки из необработанных входных данных. Например, при обработке изображений более низкие слои могут определять края, в то время как более высокие слои могут определять концепции, имеющие отношение к человеку, такие как цифры, буквы или лица. [112]

Глубокое обучение значительно улучшило производительность программ во многих важных областях искусственного интеллекта, включая компьютерное зрение , распознавание речи , обработку естественного языка , классификацию изображений [113] и другие. Причина, по которой глубокое обучение так хорошо работает во многих приложениях , неизвестна по состоянию на 2023 год. [114] Внезапный успех глубокого обучения в 2012–2015 годах произошел не из-за какого-то нового открытия или теоретического прорыва (глубокие нейронные сети и обратное распространение были описаны многими людьми еще в 1950-х годах) [i], а из-за двух факторов: невероятного увеличения мощности компьютеров (включая стократное увеличение скорости за счет перехода на графические процессоры ) и доступности огромных объемов обучающих данных, особенно гигантских курируемых наборов данных , используемых для эталонного тестирования, таких как ImageNet . [j]

ГПТ

Генеративные предварительно обученные трансформаторы (GPT) — это большие языковые модели (LLM), которые генерируют текст на основе семантических отношений между словами в предложениях. Текстовые модели GPT предварительно обучаются на большом корпусе текста , который может быть из Интернета. Предварительное обучение состоит из прогнозирования следующего токена (токен обычно является словом, подсловом или знаком препинания). На протяжении этого предварительного обучения модели GPT накапливают знания о мире и затем могут генерировать текст, похожий на человеческий, многократно предсказывая следующий токен. Как правило, последующая фаза обучения делает модель более правдивой, полезной и безвредной, обычно с помощью техники, называемой обучением с подкреплением на основе обратной связи с человеком (RLHF). Текущие модели GPT склонны генерировать ложь, называемую « галлюцинациями », хотя это можно уменьшить с помощью RLHF и качественных данных. Они используются в чат-ботах , которые позволяют людям задавать вопросы или запрашивать задание в простом тексте. [122] [123]

Текущие модели и сервисы включают Gemini (ранее Bard), ChatGPT , Grok , Claude , Copilot и LLaMA . [124] Мультимодальные модели GPT могут обрабатывать различные типы данных ( модальности ), такие как изображения, видео, звук и текст. [125]

Аппаратное и программное обеспечение

В конце 2010-х годов графические процессоры (GPU), которые все чаще разрабатывались с усовершенствованиями, специфичными для ИИ, и использовались со специализированным программным обеспечением TensorFlow, заменили ранее используемые центральные процессоры (CPU) в качестве доминирующего средства для обучения крупномасштабных (коммерческих и академических) моделей машинного обучения . [126] Специализированные языки программирования , такие как Prolog, использовались в ранних исследованиях ИИ, [127] но языки программирования общего назначения, такие как Python, стали преобладающими. [128]

Было замечено, что плотность транзисторов в интегральных схемах примерно удваивается каждые 18 месяцев — тенденция, известная как закон Мура , названная в честь соучредителя Intel Гордона Мура , который первым ее обнаружил. Улучшения в графических процессорах были еще быстрее, [129] тенденция, иногда называемая законом Хуанга , [130] названная в честь соучредителя и генерального директора Nvidia Дженсена Хуанга .

Приложения

Технология ИИ и машинного обучения используется в большинстве основных приложений 2020-х годов, включая: поисковые системы (например, Google Search ), таргетинг онлайн-рекламы , рекомендательные системы (предлагаемые Netflix , YouTube или Amazon ), управление интернет-трафиком , таргетинговая реклама ( AdSense , Facebook ), виртуальные помощники (например, Siri или Alexa ), автономные транспортные средства (включая дроны , ADAS и беспилотные автомобили ), автоматический языковой перевод ( Microsoft Translator , Google Translate ), распознавание лиц ( Face ID от Apple или DeepFace от Microsoft и FaceNet от Google ) и маркировка изображений (используется Facebook , iPhoto от Apple и TikTok ). Развертывание ИИ может контролироваться главным директором по автоматизации (CAO).

Здоровье и медицина

Применение ИИ в медицине и медицинских исследованиях может повысить качество ухода за пациентами и качество жизни. [131] С точки зрения клятвы Гиппократа медицинские работники этически обязаны использовать ИИ, если приложения могут более точно диагностировать и лечить пациентов. [132] [133]

Для медицинских исследований ИИ является важным инструментом для обработки и интеграции больших данных . Это особенно важно для разработки органоидов и тканевой инженерии , которые используют микроскопическую визуализацию в качестве ключевого метода изготовления. [134] Было высказано предположение, что ИИ может преодолеть расхождения в финансировании, выделяемом на различные области исследований. [134] Новые инструменты ИИ могут углубить понимание биомедицинских значимых путей. Например, AlphaFold 2 (2021) продемонстрировал способность аппроксимировать трехмерную структуру белка за часы, а не за месяцы . [135] В 2023 году сообщалось, что открытие лекарств под руководством ИИ помогло найти класс антибиотиков, способных убивать два разных типа устойчивых к лекарствам бактерий. [136] В 2024 году исследователи использовали машинное обучение для ускорения поиска лекарственных средств для лечения болезни Паркинсона . Их целью было выявление соединений, которые блокируют слипание или агрегацию альфа-синуклеина (белка, характеризующего болезнь Паркинсона). Им удалось ускорить процесс первоначального отбора в десять раз и сократить расходы в тысячу раз. [137] [138]

Игры

Программы для игр использовались с 1950-х годов для демонстрации и тестирования самых передовых методов ИИ. [139] Deep Blue стала первой компьютерной шахматной системой, которая победила действующего чемпиона мира по шахматам Гарри Каспарова 11 мая 1997 года. [140] В 2011 году в показательном матче викторины Jeopardy! система ответов на вопросы IBM Watson победила двух величайших чемпионов Jeopardy! Брэда Раттера и Кена Дженнингса со значительным отрывом. [141] В марте 2016 года AlphaGo выиграла 4 из 5 игр в го в матче с чемпионом го Ли Седолем , став первой компьютерной системой для игры в го, которая победила профессионального игрока в го без гандикапов . Затем, в 2017 году, она победила Кэ Цзе , который был лучшим игроком в го в мире. [142] Другие программы обрабатывают игры с несовершенной информацией , такие как программа для игры в покер Pluribus . [143] DeepMind разработала все более универсальные модели обучения с подкреплением , такие как MuZero , которые можно было обучить играть в шахматы, го или игры Atari . [144] В 2019 году AlphaStar от DeepMind достигла уровня гроссмейстера в StarCraft II , особенно сложной стратегической игре в реальном времени, которая предполагает неполное знание того, что происходит на карте. [145] В 2021 году агент ИИ участвовал в соревновании PlayStation Gran Turismo , победив четырех лучших в мире водителей Gran Turismo, используя глубокое обучение с подкреплением. [146] В 2024 году Google DeepMind представила SIMA, тип ИИ, способный автономно играть в девять ранее невиданных видеоигр с открытым миром , наблюдая за выводом на экран, а также выполняя короткие конкретные задачи в ответ на инструкции естественного языка. [147]

Математика

Большие языковые модели, такие как GPT-4 , Gemini , Claude , LLaMa или Mistral , все чаще используются в математике. Эти вероятностные модели универсальны, но также могут давать неправильные ответы в форме галлюцинаций . Иногда им нужна большая база данных математических задач для обучения, а также такие методы, как контролируемая тонкая настройка или обученные классификаторы с данными, аннотированными человеком, для улучшения ответов на новые задачи и обучения на исправлениях. [148] Исследование, проведенное в феврале 2024 года, показало, что производительность некоторых языковых моделей для возможностей рассуждения при решении математических задач, не включенных в их обучающие данные, была низкой, даже для задач с небольшими отклонениями от обучающих данных. [149] Один из методов улучшения их производительности заключается в обучении моделей производить правильные шаги рассуждения , а не просто правильный результат. [150] В январе 2025 года Microsoft предложила технологию rStar-Math, которая использует поиск по дереву Монте-Карло и пошаговые рассуждения, позволяя относительно небольшой языковой модели, такой как Qwen-7B, решать 53% задач теста AIME 2024 и 90% задач теста MATH. [151]

В качестве альтернативы были разработаны специальные модели для решения математических задач с более высокой точностью результата, включая доказательство теорем, такие как AlphaTensor , AlphaGeometry и AlphaProof, все от Google DeepMind , [152] Llemma от EleutherAI [153] или Julius . [154]

Когда для описания математических задач используется естественный язык, конвертеры могут преобразовывать такие подсказки в формальный язык, такой как Lean, для определения математических задач.

Некоторые модели были разработаны для решения сложных задач и достижения хороших результатов в контрольных тестах, другие — в качестве образовательных инструментов по математике. [155]

Топологическое глубокое обучение объединяет различные топологические подходы.

Финансы

Финансы являются одним из наиболее быстрорастущих секторов, где внедряются прикладные инструменты ИИ: от розничного онлайн-банкинга до инвестиционного консультирования и страхования, где автоматизированные «роботы-консультанты» используются уже несколько лет. [156]

Эксперты World Pensions , такие как Николас Фирцли, утверждают, что, возможно, еще слишком рано ожидать появления инновационных финансовых продуктов и услуг на основе искусственного интеллекта: «Развертывание инструментов искусственного интеллекта просто еще больше автоматизирует процессы: в процессе будут уничтожены десятки тысяч рабочих мест в банковской сфере, финансовом планировании и пенсионном консультировании, но я не уверен, что это вызовет новую волну [например, сложных] пенсионных инноваций». [157]

Военный

Различные страны развертывают военные приложения ИИ. [158] Основные приложения улучшают командование и управление , связь, датчики, интеграцию и взаимодействие. [159] Исследования нацелены на сбор и анализ разведданных, логистику, кибероперации, информационные операции, а также полуавтономные и автономные транспортные средства . [158] Технологии ИИ позволяют координировать работу датчиков и эффекторов, обнаруживать и идентифицировать угрозы, отмечать позиции противника, захватывать цели , координировать и устранять конфликты распределенных совместных огней между сетевыми боевыми машинами, включающими пилотируемые и беспилотные команды. [159]

ИИ использовался в военных операциях в Ираке, Сирии, Израиле и Украине. [158] [160] [161] [162]

Генеративный ИИ

Генеративный искусственный интеллект (генеративный ИИ, GenAI [163] или GAI) — это подмножество искусственного интеллекта, которое использует генеративные модели для создания текста, изображений, видео или других форм данных. [164] [165] [166] Эти модели изучают базовые шаблоны и структуры своих обучающих данных и используют их для создания новых данных [167] [168] на основе входных данных, которые часто поступают в форме подсказок на естественном языке . [169] [170]

Улучшения в глубоких нейронных сетях на основе трансформаторов , в частности, больших языковых моделях (LLM), способствовали буму генеративных систем ИИ в начале 2020-х годов. К ним относятся чат-боты , такие как ChatGPT , Copilot , Gemini и LLaMA ; системы генерации изображений искусственного интеллекта для преобразования текста в изображение, такие как Stable Diffusion , Midjourney и DALL-E ; и генераторы ИИ для преобразования текста в видео, такие как Sora . [171] [172] [173] [174] Такие компании, как OpenAI , Anthropic , Microsoft , Google и Baidu , а также многочисленные более мелкие фирмы разработали генеративные модели ИИ. [169] [175] [176]

Генеративный ИИ применяется в самых разных отраслях, включая разработку программного обеспечения, здравоохранение, финансы, развлечения, обслуживание клиентов, [177] продажи и маркетинг, [178] искусство, письмо, [179] моду, [180] и дизайн продукта. [181] Однако высказываются опасения относительно потенциального злоупотребления генеративным ИИ, например, киберпреступности , использования фейковых новостей или дипфейков для обмана или манипулирования людьми, а также массового замещения человеческих рабочих мест . [182] [183] Проблемы с законодательством об интеллектуальной собственности также существуют в отношении генеративных моделей, которые обучаются на произведениях искусства, защищенных авторским правом, и имитируют их. [184]Агенты

Искусственные интеллектуальные (ИИ) агенты — это программные сущности, разработанные для восприятия своего окружения, принятия решений и выполнения действий автономно для достижения определенных целей. Эти агенты могут взаимодействовать с пользователями, своим окружением или другими агентами. Агенты ИИ используются в различных приложениях, включая виртуальных помощников , чат-ботов , автономные транспортные средства , игровые системы и промышленную робототехнику . Агенты ИИ действуют в рамках ограничений своего программирования, доступных вычислительных ресурсов и аппаратных ограничений. Это означает, что они ограничены выполнением задач в пределах своей определенной области и имеют конечные возможности памяти и обработки. В реальных приложениях агенты ИИ часто сталкиваются с ограничениями по времени для принятия решений и выполнения действий. Многие агенты ИИ включают алгоритмы обучения, что позволяет им со временем улучшать свою производительность за счет опыта или обучения. Используя машинное обучение, агенты ИИ могут адаптироваться к новым ситуациям и оптимизировать свое поведение для своих назначенных задач. [185] [186] [187]

Сексуальность

Приложения ИИ в этой области включают в себя менструальные и фертильные трекеры с поддержкой ИИ, которые анализируют пользовательские данные для предложения прогнозов, [188] секс-игрушки, интегрированные с ИИ (например, теледильдоника ), [189] контент сексуального образования, созданный ИИ, [190] и агенты ИИ, которые имитируют сексуальных и романтических партнеров (например, Replika ). [191] ИИ также используется для производства неконсенсуальной глубокой фейковой порнографии , что вызывает серьезные этические и правовые проблемы. [192]

Технологии искусственного интеллекта также использовались для выявления случаев гендерного насилия в Интернете и сексуального насилия в отношении несовершеннолетних в Интернете. [193] [194]

Другие отраслевые задачи

Существуют также тысячи успешных приложений ИИ, используемых для решения конкретных проблем для конкретных отраслей или учреждений. В опросе 2017 года каждая пятая компания сообщила о внедрении «ИИ» в некоторые предложения или процессы. [195] Несколько примеров — хранение энергии , медицинская диагностика, военная логистика, приложения, которые предсказывают результат судебных решений, внешняя политика или управление цепочками поставок.

Растет число приложений ИИ для эвакуации и управления стихийными бедствиями . ИИ использовался для расследования того, эвакуировались ли люди и как это было сделано в ходе крупномасштабных и мелкомасштабных эвакуаций, используя исторические данные из GPS, видео или социальных сетей. Кроме того, ИИ может предоставлять информацию в реальном времени об условиях эвакуации в реальном времени. [196] [197] [198]

В сельском хозяйстве ИИ помог фермерам определить области, которые нуждаются в орошении, удобрении, обработке пестицидами или повышении урожайности. Агрономы используют ИИ для проведения исследований и разработок. ИИ использовался для прогнозирования времени созревания таких культур, как томаты, мониторинга влажности почвы, управления сельскохозяйственными роботами, проведения предиктивной аналитики , классификации эмоций свиней, автоматизации теплиц, обнаружения болезней и вредителей и экономии воды.

Искусственный интеллект используется в астрономии для анализа все большего количества доступных данных и приложений, в основном для «классификации, регрессии, кластеризации, прогнозирования, генерации, открытия и разработки новых научных идей». Например, он используется для открытия экзопланет, прогнозирования солнечной активности и различения сигналов и инструментальных эффектов в гравитационно-волновой астрономии. Кроме того, его можно использовать для деятельности в космосе, такой как исследование космоса, включая анализ данных с космических миссий, принятие научных решений в реальном времени для космических аппаратов, избегание космического мусора и более автономную работу.

Во время выборов в Индии 2024 года было потрачено 50 миллионов долларов США на авторизованный контент, созданный с помощью искусственного интеллекта, в частности, на создание фейковых копий политиков-союзников (в том числе иногда и умерших) для лучшего взаимодействия с избирателями, а также на перевод речей на различные местные языки. [199]

Этика

ИИ имеет потенциальные преимущества и потенциальные риски. [200] ИИ может быть в состоянии продвигать науку и находить решения для серьезных проблем: Демис Хассабис из DeepMind надеется «решить проблему интеллекта, а затем использовать это для решения всего остального». [201] Однако, поскольку использование ИИ стало широко распространенным, было выявлено несколько непреднамеренных последствий и рисков. [202] Системы в процессе производства иногда не могут учитывать этику и предвзятость в своих процессах обучения ИИ, особенно когда алгоритмы ИИ по своей сути необъяснимы в глубоком обучении. [203]

Риски и вред

Конфиденциальность и авторские права

Алгоритмы машинного обучения требуют больших объемов данных. Методы, используемые для получения этих данных, вызвали опасения по поводу конфиденциальности , наблюдения и авторских прав .

Устройства и сервисы на базе ИИ, такие как виртуальные помощники и продукты IoT, постоянно собирают персональные данные, вызывая опасения по поводу навязчивого сбора данных и несанкционированного доступа третьих лиц. Потеря конфиденциальности еще больше усугубляется способностью ИИ обрабатывать и объединять огромные объемы данных, что потенциально приводит к обществу наблюдения, где индивидуальные действия постоянно отслеживаются и анализируются без адекватных мер безопасности или прозрачности.

Конфиденциальные данные пользователей, собранные, могут включать записи об активности в сети, данные геолокации, видео или аудио. [204] Например, для создания алгоритмов распознавания речи Amazon записала миллионы частных разговоров и позволила временным работникам прослушивать и расшифровывать некоторые из них. [205] Мнения об этой широко распространенной слежке варьируются от тех, кто считает ее необходимым злом , до тех, для кого она явно неэтична и нарушает право на неприкосновенность частной жизни . [206]

Разработчики ИИ утверждают, что это единственный способ предоставить ценные приложения, и разработали несколько методов, которые пытаются сохранить конфиденциальность, при этом получая данные, такие как агрегация данных , деидентификация и дифференциальная конфиденциальность . [207] С 2016 года некоторые эксперты по конфиденциальности, такие как Синтия Дворк , начали рассматривать конфиденциальность с точки зрения справедливости . Брайан Кристиан написал, что эксперты перешли «от вопроса «что они знают» к вопросу «что они с этим делают»». [208]

Генеративный ИИ часто обучается на нелицензированных работах, защищенных авторским правом, в том числе в таких областях, как изображения или компьютерный код; затем вывод используется в соответствии с обоснованием « добросовестного использования ». Эксперты расходятся во мнениях относительно того, насколько хорошо и при каких обстоятельствах это обоснование будет иметь силу в судах; соответствующие факторы могут включать «цель и характер использования защищенной авторским правом работы» и «влияние на потенциальный рынок для защищенной авторским правом работы». [209] [210] Владельцы веб-сайтов, которые не хотят, чтобы их контент был удален, могут указать это в файле « robots.txt ». [211] В 2023 году ведущие авторы (включая Джона Гришэма и Джонатана Франзена ) подали в суд на компании, занимающиеся ИИ, за использование их работы для обучения генеративного ИИ. [212] [213] Другой обсуждаемый подход заключается в том, чтобы представить отдельную систему sui generis защиты для творений, созданных ИИ, чтобы гарантировать справедливое указание авторства и компенсацию авторам-людям. [214]

Доминирование технологических гигантов

На рынке коммерческого ИИ доминируют крупные технологические компании, такие как Alphabet Inc. , Amazon , Apple Inc. , Meta Platforms и Microsoft . [215] [216] [217] Некоторые из этих игроков уже владеют подавляющим большинством существующей облачной инфраструктуры и вычислительной мощности центров обработки данных , что позволяет им еще больше укрепиться на рынке. [218] [219]

Потребности в электроэнергии и воздействие на окружающую среду

В январе 2024 года Международное энергетическое агентство (МЭА) опубликовало отчет «Электричество 2024, анализ и прогноз до 2026 года » , в котором спрогнозировано потребление электроэнергии. [220] Это первый отчет МЭА, в котором даны прогнозы относительно центров обработки данных и потребления электроэнергии для искусственного интеллекта и криптовалюты. В отчете говорится, что спрос на электроэнергию для этих целей может удвоиться к 2026 году, при этом дополнительное потребление электроэнергии будет равно потреблению электроэнергии всей японской нацией. [221]

Огромное потребление энергии ИИ ответственно за рост использования ископаемого топлива и может задержать закрытие устаревших, выбрасывающих углерод угольных энергетических объектов. В США наблюдается лихорадочный рост строительства центров обработки данных, что превращает крупные технологические компании (например, Microsoft, Meta, Google, Amazon) в прожорливых потребителей электроэнергии. Прогнозируемое потребление электроэнергии настолько огромно, что есть опасения, что оно будет выполнено независимо от источника. Поиск ChatGPT предполагает использование в 10 раз больше электроэнергии, чем поиск Google. Крупные компании спешат найти источники энергии — от ядерной энергии до геотермальной и термоядерной. Технологические компании утверждают, что — в долгосрочной перспективе — ИИ в конечном итоге станет добрее к окружающей среде, но им нужна энергия сейчас. ИИ делает электросеть более эффективной и «интеллектуальной», будет способствовать росту ядерной энергетики и отслеживать общие выбросы углерода, по словам технологических компаний. [222]

В исследовательской работе Goldman Sachs 2024 года « Центры обработки данных ИИ и грядущий всплеск спроса на электроэнергию в США » говорится, что «спрос на электроэнергию в США, вероятно, будет расти, как никогда за последнее поколение...» и прогнозируется, что к 2030 году центры обработки данных США будут потреблять 8% электроэнергии США по сравнению с 3% в 2022 году, что предвещает рост электроэнергетической отрасли различными способами. [223] Потребность центров обработки данных во все большем количестве электроэнергии такова, что они могут перегрузить электросеть. Крупные технологические компании возражают, что ИИ можно использовать для максимального использования сети всеми. [224]

В 2024 году Wall Street Journal сообщил, что крупные компании ИИ начали переговоры с поставщиками ядерной энергии США о поставке электроэнергии в центры обработки данных. В марте 2024 года Amazon приобрела центр обработки данных на ядерной энергии в Пенсильвании за 650 миллионов долларов США. [225] Генеральный директор Nvidia Дженсен Хуан сказал, что ядерная энергия является хорошим вариантом для центров обработки данных. [226]

В сентябре 2024 года Microsoft объявила о соглашении с Constellation Energy о повторном открытии атомной электростанции Three Mile Island , которая будет поставлять Microsoft 100% всей электроэнергии, производимой станцией в течение 20 лет. Повторное открытие станции, на которой в 1979 году произошел частичный ядерный расплав реактора второго блока, потребует от Constellation пройти строгие нормативные процессы, которые будут включать тщательный контроль безопасности со стороны Комиссии по ядерному регулированию США . В случае одобрения (это будет первый в истории США повторный ввод в эксплуатацию атомной станции) будет произведено более 835 мегаватт электроэнергии — достаточно для 800 000 домов. Стоимость повторного открытия и модернизации оценивается в 1,6 млрд долларов США и зависит от налоговых льгот для ядерной энергетики, содержащихся в Законе США о снижении инфляции 2022 года . [227] Правительство США и штат Мичиган инвестируют почти 2 миллиарда долларов США в повторное открытие ядерного реактора Palisades на озере Мичиган. Закрытый с 2022 года завод, как планируется, будет повторно открыт в октябре 2025 года. Объект Three Mile Island будет переименован в Crane Clean Energy Center в честь Криса Крейна, сторонника ядерной энергетики и бывшего генерального директора Exelon , который отвечал за отделение Exelon от Constellation. [228]

После последнего одобрения в сентябре 2023 года Тайвань приостановил одобрение центров обработки данных к северу от Таоюаня мощностью более 5 МВт в 2024 году из-за нехватки электроэнергии. [229] Тайвань намерен отказаться от ядерной энергетики к 2025 году. [229] С другой стороны, Сингапур ввел запрет на открытие центров обработки данных в 2019 году из-за электроэнергии, но в 2022 году снял этот запрет. [229]

Хотя большинство атомных электростанций в Японии были закрыты после аварии на АЭС «Фукусима» в 2011 году , согласно статье Bloomberg на японском языке за октябрь 2024 года, компания Ubitus, предоставляющая услуги облачных игр, в которой есть доля Nvidia, ищет землю в Японии рядом с атомной электростанцией для нового центра обработки данных для генеративного ИИ. [230] Генеральный директор Ubitus Уэсли Куо сказал, что атомные электростанции являются наиболее эффективной, дешевой и стабильной энергией для ИИ. [230]

1 ноября 2024 года Федеральная комиссия по регулированию энергетики (FERC) отклонила заявку, поданную Talen Energy на одобрение поставок электроэнергии с атомной электростанции Саскуэханна в центр обработки данных Amazon. [231] По словам председателя комиссии Вилли Л. Филлипса , это является бременем для электросети, а также существенной проблемой перераспределения затрат для домохозяйств и других секторов бизнеса. [231]

Дезинформация

YouTube , Facebook и другие используют рекомендательные системы , чтобы направлять пользователей к большему количеству контента. Эти программы ИИ были поставлены перед целью максимизировать вовлеченность пользователей (то есть единственной целью было заставить людей смотреть). ИИ узнал, что пользователи склонны выбирать дезинформацию , теории заговора и экстремальный партийный контент, и, чтобы заставить их смотреть, ИИ рекомендовал больше этого. Пользователи также склонны смотреть больше контента на одну и ту же тему, поэтому ИИ заводил людей в пузыри фильтров , где они получали несколько версий одной и той же дезинформации. [232] Это убедило многих пользователей в том, что дезинформация была правдой, и в конечном итоге подорвало доверие к институтам, СМИ и правительству. [233] Программа ИИ правильно научилась максимизировать свою цель, но результат был вреден для общества. После выборов в США в 2016 году крупные технологические компании предприняли шаги для смягчения проблемы [ необходима цитата ] .

В 2022 году генеративный ИИ начал создавать изображения, аудио, видео и текст, которые неотличимы от настоящих фотографий, записей, фильмов или человеческого письма. Злоумышленники могут использовать эту технологию для создания огромных объемов дезинформации или пропаганды. [234] Пионер ИИ Джеффри Хинтон выразил обеспокоенность по поводу того, что ИИ позволяет «авторитарным лидерам манипулировать своим электоратом» в больших масштабах, среди прочих рисков. [235]

Алгоритмическая предвзятость и справедливость

Приложения машинного обучения будут предвзятыми [k], если они обучаются на предвзятых данных. [237] Разработчики могут не знать о существовании предвзятости. [238] Предвзятость может быть вызвана способом выбора обучающих данных и способом развертывания модели. [239] [237] Если предвзятый алгоритм используется для принятия решений, которые могут серьезно навредить людям (как это может быть в медицине , финансах , подборе персонала , жилищном обеспечении или работе полиции ), то алгоритм может вызвать дискриминацию . [240] Область справедливости изучает, как предотвратить вред от алгоритмических предвзятостей.

28 июня 2015 года новая функция маркировки изображений Google Photos ошибочно идентифицировала Джеки Элсина и его друга как «горилл», потому что они были черными. Система была обучена на наборе данных, который содержал очень мало изображений чернокожих людей, [241] проблема, называемая «несоответствием размера выборки». [242] Google «исправил» эту проблему, запретив системе маркировать что-либо как «гориллу». Восемь лет спустя, в 2023 году, Google Photos все еще не мог идентифицировать гориллу, как и аналогичные продукты от Apple, Facebook, Microsoft и Amazon. [243]

COMPAS — это коммерческая программа, широко используемая судами США для оценки вероятности рецидивизма обвиняемого . В 2016 году Джулия Энгвин из ProPublica обнаружила, что COMPAS демонстрирует расовую предвзятость, несмотря на то, что программе не сообщали расы обвиняемых. Хотя частота ошибок для белых и черных была откалибрована одинаково и составляла ровно 61%, ошибки для каждой расы были разными — система последовательно переоценивала вероятность того, что черный человек совершит повторное преступление, и недооценивала вероятность того, что белый человек не совершит повторное преступление. [244] В 2017 году несколько исследователей [l] показали, что математически невозможно, чтобы COMPAS учитывал все возможные меры справедливости, когда базовые показатели повторных преступлений были разными для белых и черных в данных. [246]

Программа может принимать предвзятые решения, даже если данные явно не упоминают проблемную характеристику (такую как «раса» или «пол»). Характеристика будет коррелировать с другими характеристиками (такими как «адрес», «история покупок» или «имя»), и программа будет принимать те же решения на основе этих характеристик, как и на основе «расы» или «пола». [247] Мориц Хардт сказал: «Самым надежным фактом в этой области исследований является то, что справедливость через слепоту не работает». [248]

Критика COMPAS подчеркнула, что модели машинного обучения разработаны для того, чтобы делать «предсказания», которые действительны только в том случае, если мы предполагаем, что будущее будет похоже на прошлое. Если они обучены на данных, которые включают результаты расистских решений в прошлом, модели машинного обучения должны предсказывать, что расистские решения будут приняты в будущем. Если затем приложение использует эти предсказания в качестве рекомендаций , некоторые из этих «рекомендаций», вероятно, будут расистскими. [249] Таким образом, машинное обучение не очень подходит для помощи в принятии решений в областях, где есть надежда, что будущее будет лучше прошлого. Оно носит описательный, а не предписывающий характер. [m]

Предвзятость и несправедливость могут остаться незамеченными, поскольку разработчики в подавляющем большинстве белые мужчины: среди инженеров ИИ около 4% — чернокожие и 20% — женщины. [242]

Существуют различные противоречивые определения и математические модели справедливости. Эти понятия зависят от этических предположений и находятся под влиянием убеждений об обществе. Одной из широких категорий является распределительная справедливость , которая фокусируется на результатах, часто идентифицируя группы и стремясь компенсировать статистические различия. Репрезентативная справедливость пытается гарантировать, что системы ИИ не усиливают негативные стереотипы или не делают определенные группы невидимыми. Процедурная справедливость фокусируется на процессе принятия решений, а не на результате. Наиболее значимые понятия справедливости могут зависеть от контекста, в частности от типа приложения ИИ и заинтересованных сторон. Субъективность в понятиях предвзятости и справедливости затрудняет их операционализацию для компаний. Многие специалисты по этике ИИ также считают, что доступ к чувствительным атрибутам, таким как раса или пол, необходим для компенсации предвзятости, но это может противоречить законам о борьбе с дискриминацией . [236]

На своей конференции 2022 года по справедливости, подотчетности и прозрачности (ACM FAccT 2022) Ассоциация вычислительной техники в Сеуле, Южная Корея, представила и опубликовала выводы, в которых говорится, что до тех пор, пока не будет продемонстрировано, что системы искусственного интеллекта и робототехники свободны от ошибок предвзятости, они небезопасны, а использование самообучающихся нейронных сетей, обученных на обширных, нерегулируемых источниках некорректных интернет-данных, следует ограничить. [ сомнительно – обсудить ] [251]

Отсутствие прозрачности

Многие системы ИИ настолько сложны, что их разработчики не могут объяснить, как они принимают свои решения. [252] Особенно это касается глубоких нейронных сетей , в которых существует большое количество нелинейных отношений между входами и выходами. Но существуют некоторые популярные методы объяснимости. [253]

Невозможно быть уверенным в том, что программа работает правильно, если никто не знает, как именно она работает. Было много случаев, когда программа машинного обучения проходила строгие тесты, но тем не менее узнавала что-то иное, чем то, что предполагали программисты. Например, было обнаружено, что система, которая могла определять кожные заболевания лучше, чем медицинские специалисты, на самом деле имела сильную тенденцию классифицировать изображения с линейкой как «раковые», потому что изображения злокачественных новообразований обычно включают линейку для отображения масштаба. [254] Было обнаружено, что другая система машинного обучения, разработанная для помощи в эффективном распределении медицинских ресурсов, классифицировала пациентов с астмой как имеющих «низкий риск» смерти от пневмонии. Наличие астмы на самом деле является серьезным фактором риска, но поскольку пациенты с астмой обычно получали гораздо больше медицинской помощи, они были относительно маловероятны, чтобы умереть, согласно данным обучения. Корреляция между астмой и низким риском смерти от пневмонии была реальной, но вводящей в заблуждение. [255]

Люди, которым был нанесен ущерб решением алгоритма, имеют право на объяснение. [256] Например, врачи должны четко и полностью объяснять своим коллегам обоснование любого принятого ими решения. Ранние проекты Общего регламента по защите данных Европейского союза в 2016 году включали явное заявление о том, что такое право существует. [n] Эксперты отрасли отметили, что это нерешенная проблема, решения которой не видно. Регуляторы утверждали, что, тем не менее, вред реален: если проблема не имеет решения, инструменты не следует использовать. [257]

В 2014 году DARPA запустила программу XAI («Объяснимый искусственный интеллект»), чтобы попытаться решить эти проблемы. [258]

Несколько подходов направлены на решение проблемы прозрачности. SHAP позволяет визуализировать вклад каждой функции в вывод. [259] LIME может локально аппроксимировать выводы модели с помощью более простой, интерпретируемой модели. [260] Многозадачное обучение обеспечивает большое количество выводов в дополнение к целевой классификации. Эти другие выводы могут помочь разработчикам сделать вывод о том, чему научилась сеть. [261] Деконволюция , DeepDream и другие генеративные методы могут позволить разработчикам увидеть, чему научились различные слои глубокой сети для компьютерного зрения, и создать вывод, который может подсказать, чему учится сеть. [262] Для генеративных предварительно обученных трансформаторов Anthropic разработала метод, основанный на словарном обучении , который связывает шаблоны активаций нейронов с понятными человеку концепциями. [263]

Злодеи и искусственный интеллект как оружие

Искусственный интеллект предоставляет ряд инструментов, которые полезны для злоумышленников , таких как авторитарные правительства , террористы , преступники или государства-изгои .

Смертоносное автономное оружие — это машина, которая находит, выбирает и поражает человеческие цели без человеческого контроля. [o] Широко доступные инструменты ИИ могут использоваться злоумышленниками для разработки недорогого автономного оружия, и если их производить в больших масштабах, они потенциально являются оружием массового поражения . [265] Даже при использовании в обычных боевых действиях они в настоящее время не могут надежно выбирать цели и потенциально могут убить невинного человека . [265] В 2014 году 30 стран (включая Китай) поддержали запрет на автономное оружие в соответствии с Конвенцией ООН о конкретных видах обычного оружия , однако Соединенные Штаты и другие страны не согласились. [266] К 2015 году сообщалось, что более пятидесяти стран исследовали боевых роботов. [267]

Инструменты ИИ облегчают авторитарным правительствам эффективный контроль над своими гражданами несколькими способами. Распознавание лиц и голоса позволяет осуществлять широкомасштабное наблюдение . Машинное обучение , оперируя этими данными, может классифицировать потенциальных врагов государства и не давать им скрываться. Рекомендательные системы могут точно нацеливать пропаганду и дезинформацию для максимального эффекта. Глубокие фейки и генеративный ИИ помогают в производстве дезинформации. Продвинутый ИИ может сделать авторитарное централизованное принятие решений более конкурентоспособным, чем либеральные и децентрализованные системы, такие как рынки . Это снижает стоимость и сложность цифровой войны и передового шпионского ПО . [268] Все эти технологии доступны с 2020 года или ранее — системы распознавания лиц ИИ уже используются для массового наблюдения в Китае. [269] [270]

Есть много других способов, которыми ИИ, как ожидается, будет помогать плохим актерам, некоторые из которых невозможно предвидеть. Например, машинное обучение ИИ способно спроектировать десятки тысяч токсичных молекул за считанные часы. [271]

Технологическая безработица

Экономисты часто подчеркивали риски увольнений из-за ИИ и рассуждали о безработице, если не будет адекватной социальной политики для полной занятости. [272]

В прошлом технологии имели тенденцию увеличивать, а не сокращать общую занятость, но экономисты признают, что «мы находимся на неизведанной территории» с ИИ. [273] Опрос экономистов показал разногласия относительно того, вызовет ли растущее использование роботов и ИИ существенный рост долгосрочной безработицы , но они в целом согласны, что это может быть чистой выгодой, если рост производительности будет перераспределен . [274] Оценки риска различаются; например, в 2010-х годах Майкл Осборн и Карл Бенедикт Фрей оценили, что 47% рабочих мест в США находятся под «высоким риском» потенциальной автоматизации, в то время как отчет ОЭСР классифицировал только 9% рабочих мест в США как «высокий риск». [p] [276] Методология спекуляций о будущих уровнях занятости подвергалась критике за отсутствие доказательной базы и за то, что подразумевает, что технологии, а не социальная политика, создают безработицу, а не увольнения. [272] В апреле 2023 года сообщалось, что 70% рабочих мест для китайских иллюстраторов видеоигр были ликвидированы генеративным искусственным интеллектом. [277] [278]

В отличие от предыдущих волн автоматизации, многие рабочие места среднего класса могут быть ликвидированы искусственным интеллектом; The Economist заявил в 2015 году, что «опасение, что ИИ может сделать с рабочими местами «белых воротничков» то же, что паровая энергия сделала с рабочими местами «синих воротничков» во время промышленной революции», «стоит отнестись серьезно». [279] Рабочие места с экстремальным риском варьируются от помощников юристов до поваров фастфуда, в то время как спрос на рабочие места, связанные с уходом, вероятно, возрастет, начиная от личного здравоохранения и заканчивая духовенством. [280]

С первых дней развития искусственного интеллекта существовали аргументы, например, выдвинутые Джозефом Вайценбаумом , о том, должны ли задачи, которые могут быть выполнены компьютерами, на самом деле выполняться ими, учитывая разницу между компьютерами и людьми, а также между количественными расчетами и качественными, основанными на ценностях суждениями. [281]

Экзистенциальный риск

Утверждалось, что ИИ станет настолько мощным, что человечество может необратимо потерять над ним контроль. Это может, как сказал физик Стивен Хокинг , « означать конец человеческой расы ». [282] Этот сценарий был распространен в научной фантастике, когда компьютер или робот внезапно развивает человеческое «самосознание» (или «чувство», или «сознание») и становится злобным персонажем. [q] Эти научно-фантастические сценарии вводят в заблуждение несколькими способами.

Во-первых, ИИ не требует наличия чувствительности , подобной человеческой , чтобы представлять собой экзистенциальный риск. Современные программы ИИ получают конкретные цели и используют обучение и интеллект для их достижения. Философ Ник Бостром утверждал, что если дать практически любую цель достаточно мощному ИИ, он может решить уничтожить человечество, чтобы достичь ее (он использовал пример менеджера фабрики по производству скрепок ). [284] Стюарт Рассел приводит пример домашнего робота, который пытается найти способ убить своего владельца, чтобы предотвратить его отключение, рассуждая, что «вы не сможете принести кофе, если вы мертвы». [285] Чтобы быть безопасным для человечества, сверхразум должен был бы быть искренне согласован с моралью и ценностями человечества, чтобы он был «в основе своей на нашей стороне». [286]

Во-вторых, Юваль Ной Харари утверждает, что ИИ не требует тела робота или физического контроля, чтобы представлять экзистенциальный риск. Основные части цивилизации не являются физическими. Такие вещи, как идеологии , закон , правительство , деньги и экономика , построены на языке ; они существуют, потому что есть истории, в которые верят миллиарды людей. Текущее распространение дезинформации предполагает, что ИИ может использовать язык, чтобы убедить людей верить во что угодно, даже совершать действия, которые являются разрушительными. [287]

Мнения экспертов и представителей отрасли неоднозначны, и значительная часть из них как обеспокоена, так и не обеспокоена риском, который может возникнуть со стороны сверхразумного ИИ. [288] Такие личности, как Стивен Хокинг , Билл Гейтс и Илон Маск , [289] , а также пионеры ИИ, такие как Йошуа Бенджио , Стюарт Рассел , Демис Хассабис и Сэм Альтман , выражали обеспокоенность по поводу экзистенциального риска со стороны ИИ.

В мае 2023 года Джеффри Хинтон объявил о своем уходе из Google, чтобы иметь возможность «свободно говорить о рисках ИИ», не «думая о том, как это повлияет на Google». [290] Он, в частности, упомянул риски поглощения ИИ , [291] и подчеркнул, что для того, чтобы избежать худших результатов, установление правил безопасности потребует сотрудничества между теми, кто конкурирует в использовании ИИ. [292]

В 2023 году многие ведущие эксперты в области ИИ одобрили совместное заявление о том, что «Снижение риска вымирания из-за ИИ должно стать глобальным приоритетом наряду с другими рисками общественного масштаба, такими как пандемии и ядерная война» [293] .

Некоторые другие исследователи были более оптимистичны. Пионер ИИ Юрген Шмидхубер не подписал совместное заявление, подчеркнув, что в 95% всех случаев исследования ИИ направлены на то, чтобы сделать «человеческую жизнь более долгой, здоровой и легкой». [294] Хотя инструменты, которые сейчас используются для улучшения жизни, могут использоваться и плохими игроками, «они также могут быть использованы против плохих игроков». [295] [296] Эндрю Нг также утверждал, что «ошибочно поддаваться шумихе вокруг конца света вокруг ИИ, и что регуляторы, которые это делают, только выиграют от корыстных интересов». [297] Янн Лекун «высмеивает антиутопические сценарии своих коллег о чрезмерной дезинформации и даже, в конечном итоге, о вымирании человечества». [298] В начале 2010-х годов эксперты утверждали, что риски слишком отдалены в будущем, чтобы оправдать исследования, или что люди будут ценны с точки зрения сверхразумной машины. [299] Однако после 2016 года изучение текущих и будущих рисков и возможных решений стало серьезной областью исследований. [300]

Этические машины и выравнивание

Дружественный ИИ — это машины, которые изначально были разработаны для минимизации рисков и принятия решений, приносящих пользу людям. Элиезер Юдковски , который придумал этот термин, утверждает, что разработка дружественного ИИ должна быть более приоритетной в исследованиях: это может потребовать больших инвестиций и должно быть завершено до того, как ИИ станет экзистенциальным риском. [301]

Машины с интеллектом имеют потенциал использовать свой интеллект для принятия этических решений. Область машинной этики предоставляет машинам этические принципы и процедуры для разрешения этических дилемм. [302] Область машинной этики также называется вычислительной моралью, [302] и была основана на симпозиуме AAAI в 2005 году. [303]

Другие подходы включают «искусственных моральных агентов» Уэнделла Уоллаха [304] и три принципа Стюарта Дж. Рассела для разработки доказуемо полезных машин. [305]

С открытым исходным кодом

Активные организации в сообществе открытого исходного кода ИИ включают Hugging Face , [306] Google , [307] EleutherAI и Meta . [308] Различные модели ИИ, такие как Llama 2 , Mistral или Stable Diffusion , были сделаны с открытым весом, [309] [310] что означает, что их архитектура и обученные параметры («веса») являются общедоступными. Модели с открытым весом могут быть свободно настроены , что позволяет компаниям специализировать их с помощью собственных данных и для собственного варианта использования. [311] Модели с открытым весом полезны для исследований и инноваций, но также могут быть использованы не по назначению. Поскольку их можно настроить, любая встроенная мера безопасности, такая как возражение против вредоносных запросов, может быть обучена до тех пор, пока она не станет неэффективной. Некоторые исследователи предупреждают, что будущие модели ИИ могут развить опасные возможности (например, потенциал для радикального содействия биотерроризму ), и что после публикации в Интернете их нельзя будет удалить везде, если это необходимо. Они рекомендуют проводить предварительные аудиты и анализы затрат и выгод. [312]

Фреймворки

Проекты искусственного интеллекта могут иметь этическую допустимость, проверенную при проектировании, разработке и внедрении системы ИИ. Структура ИИ, такая как Care and Act Framework, содержащая ценности SUM, разработанная Институтом Алана Тьюринга, проверяет проекты в четырех основных областях: [313] [314]

- Уважайте достоинство отдельных людей

- Общайтесь с другими людьми искренне, открыто и инклюзивно

- Забота о благополучии каждого

- Защищать социальные ценности, справедливость и общественные интересы

Другие разработки в этических рамках включают решения, принятые на конференции в Асиломаре , Монреальскую декларацию об ответственном ИИ и инициативу IEEE по этике автономных систем, среди прочих; [315] однако эти принципы не обходятся без критики, особенно в отношении людей, выбранных для внесения вклада в эти рамки. [316]

Содействие благополучию людей и сообществ, на которые влияют эти технологии, требует учета социальных и этических последствий на всех этапах проектирования, разработки и внедрения систем ИИ, а также сотрудничества между специалистами по работе с данными, менеджерами по продуктам, инженерами по работе с данными, экспертами в предметной области и менеджерами по доставке. [317]

Институт безопасности ИИ Великобритании выпустил в 2024 году набор инструментов тестирования под названием «Inspect» для оценки безопасности ИИ, доступный по лицензии MIT с открытым исходным кодом, который свободно доступен на GitHub и может быть улучшен с помощью сторонних пакетов. Его можно использовать для оценки моделей ИИ в различных областях, включая основные знания, способность рассуждать и автономные возможности. [318]

Регулирование

Регулирование искусственного интеллекта — это разработка политик и законов государственного сектора для продвижения и регулирования ИИ; поэтому оно связано с более широким регулированием алгоритмов. [319] Нормативно-правовой ландшафт для ИИ является новой проблемой в юрисдикциях по всему миру. [320] Согласно индексу ИИ в Стэнфорде , ежегодное количество законов, связанных с ИИ, принятых в 127 странах, охваченных исследованием, возросло с одного, принятого в 2016 году, до 37, принятых только в 2022 году. [321] [322] В период с 2016 по 2020 год более 30 стран приняли специальные стратегии для ИИ. [323] Большинство государств-членов ЕС выпустили национальные стратегии в области ИИ, как и Канада, Китай, Индия, Япония, Маврикий, Российская Федерация, Саудовская Аравия, Объединенные Арабские Эмираты, США и Вьетнам. Другие находились в процессе разработки собственной стратегии в области ИИ, включая Бангладеш, Малайзию и Тунис. [323] Глобальное партнерство по искусственному интеллекту было запущено в июне 2020 года, в котором говорилось о необходимости разработки ИИ в соответствии с правами человека и демократическими ценностями для обеспечения общественного доверия к технологии. [323] Генри Киссинджер , Эрик Шмидт и Дэниел Хуттенлохер опубликовали совместное заявление в ноябре 2021 года, призывая создать правительственную комиссию для регулирования ИИ. [324] В 2023 году лидеры OpenAI опубликовали рекомендации по управлению сверхразумом, которое, по их мнению, может произойти менее чем через 10 лет. [325] В 2023 году Организация Объединенных Наций также создала консультативный орган для предоставления рекомендаций по управлению ИИ; в состав органа входят руководители технологических компаний, государственные служащие и ученые. [326] В 2024 году Совет Европы создал первый международный юридически обязательный договор по ИИ, названный « Рамочная конвенция об искусственном интеллекте и правах человека, демократии и верховенстве закона ». Он был принят Европейским Союзом, Соединенными Штатами, Соединенным Королевством и другими подписавшими его странами. [327]

В опросе Ipsos 2022 года отношение к ИИ сильно различалось в зависимости от страны; 78% граждан Китая, но только 35% американцев согласились с тем, что «продукты и услуги, использующие ИИ, имеют больше преимуществ, чем недостатков». [321] Опрос Reuters /Ipsos 2023 года показал, что 61% американцев согласны, а 22% не согласны, что ИИ представляет опасность для человечества. [328] В опросе Fox News 2023 года 35% американцев считали «очень важным», а еще 41% считали «довольно важным» регулирование ИИ федеральным правительством, по сравнению с 13% ответившими «не очень важно» и 8% ответившими «совсем не важно». [329] [330]

В ноябре 2023 года в Блетчли-Парке в Великобритании состоялся первый всемирный саммит по безопасности ИИ, на котором обсуждались краткосрочные и долгосрочные риски ИИ и возможность создания обязательных и добровольных нормативных рамок. [331] 28 стран, включая США, Китай и Европейский союз, опубликовали декларацию в начале саммита, призывающую к международному сотрудничеству для управления вызовами и рисками искусственного интеллекта. [332] [333] В мае 2024 года на саммите ИИ в Сеуле 16 глобальных компаний, занимающихся технологиями ИИ, согласились взять на себя обязательства по обеспечению безопасности при разработке ИИ. [334] [335]

История

Изучение механического или «формального» рассуждения началось с философов и математиков в древности. Изучение логики привело непосредственно к теории вычислений Алана Тьюринга , которая предполагала, что машина, перетасовывая символы, такие простые, как «0» и «1», может имитировать любую мыслимую форму математического рассуждения. [336] [337] Это, наряду с одновременными открытиями в кибернетике , теории информации и нейробиологии , привело исследователей к рассмотрению возможности создания «электронного мозга». [r] Они разработали несколько областей исследований, которые стали частью ИИ, [339] такие как проект Маккалуча и Питтса для «искусственных нейронов» в 1943 году, [115] и влиятельная статья Тьюринга 1950 года « Вычислительная техника и интеллект », которая представила тест Тьюринга и показала, что «машинный интеллект» правдоподобен. [340] [337]

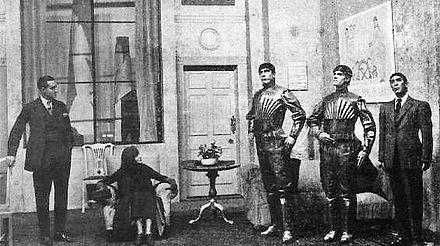

Область исследований ИИ была основана на семинаре в Дартмутском колледже в 1956 году. [s] [6] Участники стали лидерами исследований ИИ в 1960-х годах. [t] Они и их студенты создали программы, которые пресса описала как «поразительные»: [u] компьютеры изучали стратегии игры в шашки , решали текстовые задачи по алгебре, доказывали логические теоремы и говорили по-английски. [v] [7] Лаборатории искусственного интеллекта были созданы в ряде британских и американских университетов в конце 1950-х и начале 1960-х годов. [337]

Исследователи 1960-х и 1970-х годов были убеждены, что их методы в конечном итоге приведут к созданию машины с общим интеллектом, и считали это целью своей области. [344] В 1965 году Герберт Саймон предсказал, что «машины будут способны в течение двадцати лет выполнять любую работу, которую может выполнить человек». [345] В 1967 году Марвин Мински согласился, написав, что «в течение поколения ... проблема создания «искусственного интеллекта» будет в значительной степени решена». [346] Однако они недооценили сложность проблемы. [w] В 1974 году правительства США и Великобритании прекратили поисковые исследования в ответ на критику сэра Джеймса Лайтхилла [348] и продолжающееся давление со стороны Конгресса США с целью финансирования более продуктивных проектов . [349] Книга Мински и Паперта « Персептроны » была понята как доказательство того, что искусственные нейронные сети никогда не будут полезны для решения реальных задач, тем самым полностью дискредитируя этот подход. [350] Затем последовала « зима ИИ », период, когда было трудно получить финансирование для проектов ИИ. [9]

В начале 1980-х годов исследования ИИ были возрождены коммерческим успехом экспертных систем [351] , формы программы ИИ, которая имитировала знания и аналитические навыки экспертов-людей. К 1985 году рынок ИИ достиг более миллиарда долларов. В то же время японский проект пятого поколения компьютеров вдохновил правительства США и Великобритании на восстановление финансирования академических исследований [8] . Однако, начиная с краха рынка Lisp Machine в 1987 году, ИИ снова приобрел дурную славу, и началась вторая, более продолжительная зима. [10]

До этого момента большая часть финансирования ИИ направлялась на проекты, которые использовали символы высокого уровня для представления ментальных объектов, таких как планы, цели, убеждения и известные факты. В 1980-х годах некоторые исследователи начали сомневаться, что этот подход сможет имитировать все процессы человеческого познания, особенно восприятие , робототехнику , обучение и распознавание образов , [352] и начали изучать «субсимволические» подходы. [353] Родни Брукс отверг «представление» в целом и сосредоточился непосредственно на разработке машин, которые двигаются и выживают. [x] Джуда Перл , Лофти Заде и другие разработали методы, которые обрабатывали неполную и неопределенную информацию, делая разумные предположения, а не точную логику. [86] [358] Но самым важным событием стало возрождение « коннекционизма », включая исследования нейронных сетей, Джеффри Хинтоном и другими. [359] В 1990 году Ян Лекун успешно продемонстрировал, что сверточные нейронные сети могут распознавать рукописные цифры, что стало первым из многих успешных применений нейронных сетей. [360]

ИИ постепенно восстановил свою репутацию в конце 1990-х и начале 21-го века, используя формальные математические методы и находя конкретные решения для конкретных проблем. Этот « узкий » и «формальный» фокус позволил исследователям получать проверяемые результаты и сотрудничать с другими областями (такими как статистика , экономика и математика ). [361] К 2000 году решения, разработанные исследователями ИИ, широко использовались, хотя в 1990-х годах их редко называли «искусственным интеллектом» (тенденция, известная как эффект ИИ ). [362] Однако несколько академических исследователей стали беспокоиться о том, что ИИ больше не преследует свою первоначальную цель создания универсальных, полностью интеллектуальных машин. Начиная примерно с 2002 года, они основали подотрасль общего искусственного интеллекта (или «AGI»), которая к 2010-м годам имела несколько хорошо финансируемых институтов. [4]