Теорема Байеса

| Часть серии статей о |

| Байесовская статистика |

|---|

| Апостериор = Вероятность × Априор ÷ Доказательства |

| Фон |

| Модельное строительство |

| Апостериорное приближение |

| Оценщики |

| Приближение доказательств |

| Оценка модели |

Теорема Байеса (альтернативно закон Байеса или правило Байеса , в честь Томаса Байеса ) дает математическое правило для инвертирования условных вероятностей , позволяя найти вероятность причины, учитывая ее следствие. [1] Например, если известно, что риск развития проблем со здоровьем увеличивается с возрастом, теорема Байеса позволяет более точно оценить риск для человека известного возраста, обусловливая его относительно его возраста, а не предполагая, что человек типичен для популяции в целом. Основываясь на законе Байеса, необходимо учитывать как распространенность заболевания в данной популяции, так и частоту ошибок теста на инфекционные заболевания, чтобы оценить значение положительного результата теста и избежать ошибки базовой вероятности .

Одним из многочисленных применений теоремы Байеса является байесовский вывод , подход к статистическому выводу , где он используется для инвертирования вероятности наблюдений при заданной конфигурации модели (т. е. функции правдоподобия ) для получения вероятности конфигурации модели при заданных наблюдениях (т. е. апостериорной вероятности ).

История

Теорема Байеса названа в честь Томаса Байеса ( / b eɪ z / ), министра, статистика и философа. Байес использовал условную вероятность для предоставления алгоритма (его Предложение 9), который использует доказательства для вычисления пределов неизвестного параметра. Его работа была опубликована в 1763 году как Эссе о решении проблемы в доктрине шансов . Байес изучал, как вычислить распределение для параметра вероятности биномиального распределения (в современной терминологии). После смерти Байеса его семья передала его работы другу, министру, философу и математику Ричарду Прайсу .

Прайс значительно редактировал неопубликованную рукопись в течение двух лет, прежде чем отправить ее другу, который прочитал ее вслух в Королевском обществе 23 декабря 1763 года. [2] Прайс отредактировал [3] основную работу Байеса «Эссе о решении проблемы в доктрине случайностей» (1763), которая появилась в Philosophical Transactions , [4] и содержит теорему Байеса. Прайс написал введение к статье, в котором излагаются некоторые философские основы байесовской статистики , и выбрал одно из двух решений, предложенных Байесом. В 1765 году Прайс был избран членом Королевского общества в знак признания его работы над наследием Байеса. [5] [6] 27 апреля в Королевском обществе было зачитано и позже опубликовано письмо, отправленное его другу Бенджамину Франклину , в котором Прайс применяет эту работу к населению и вычислению «пожизненных рент». [7]

Независимо от Байеса, Пьер-Симон Лаплас использовал условную вероятность для формулирования отношения обновленной апостериорной вероятности к априорной вероятности, при наличии доказательств. Он воспроизвел и расширил результаты Байеса в 1774 году, по-видимому, не зная о работе Байеса, в 1774 году и обобщил его результаты в Théorie analytique des probabilités (1812). [примечание 1] [8] Байесовская интерпретация вероятности была разработана в основном Лапласом. [9]

Примерно 200 лет спустя сэр Гарольд Джеффрис положил алгоритм Байеса и формулировку Лапласа на аксиоматическую основу, написав в книге 1973 года, что теорема Байеса «является для теории вероятностей тем же, чем теорема Пифагора является для геометрии» [10] .

Стивен Стиглер использовал байесовский аргумент, чтобы заключить, что теорема Байеса была открыта Николасом Сондерсоном , слепым английским математиком, за некоторое время до Байеса, [11] [12], но это оспаривается. [13] Мартин Хупер [14] и Шэрон Макгрейн [15] утверждают, что вклад Ричарда Прайса был существенным:

По современным стандартам, мы должны ссылаться на правило Байеса-Прайса. Прайс обнаружил работу Байеса, признал ее важность, исправил ее, внес вклад в статью и нашел ей применение. Современная традиция использовать только имя Байеса несправедлива, но настолько укоренилась, что все остальное не имеет смысла. [15]

Формулировка теоремы

Теорема Байеса математически формулируется в виде следующего уравнения: [16]

где и — события и .

- это условная вероятность : вероятность события, происходящего при условии, что это правда. Она также называется апостериорной вероятностью данного .

- также является условной вероятностью: вероятность события, происходящего при условии, что это правда. Ее также можно интерпретировать как вероятность того, что задано фиксированное, поскольку .

- и являются вероятностями наблюдения и соответственно без каких-либо заданных условий; они известны как априорная вероятность и предельная вероятность .

Доказательство

Для мероприятий

Теорему Байеса можно вывести из определения условной вероятности :

где — вероятность того, что оба утверждения A и B верны. Аналогично,

Решая и подставляя в приведенное выше выражение, получаем теорему Байеса:

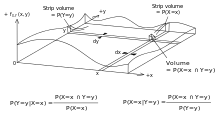

Для непрерывных случайных величин

Для двух непрерывных случайных величин X и Y теорема Байеса может быть аналогично выведена из определения условной плотности :

Поэтому,

Общий случай

Пусть будет условным распределением заданного и пусть будет распределением . Совместное распределение тогда будет . Условное распределение заданного тогда определяется как

Существование и единственность необходимого условного ожидания является следствием теоремы Радона–Никодима . Она была сформулирована Колмогоровым в 1933 году. Колмогоров подчеркивает важность условной вероятности, написав: «Я хочу обратить внимание на ... теорию условных вероятностей и условных ожиданий». [17] Теорема Байеса определяет апостериорное распределение из априорного распределения. Уникальность требует предположений о непрерывности. [18] Теорему Байеса можно обобщить, включив в нее неправильные априорные распределения, такие как равномерное распределение на вещественной прямой. [19] Современные методы Монте-Карло для цепей Маркова повысили важность теоремы Байеса, в том числе в случаях с неправильными априорными данными. [20]

Примеры

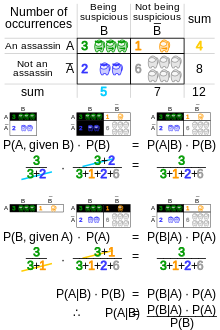

Занимательная математика

Правило Байеса и вычисление условных вероятностей предоставляют метод решения ряда популярных головоломок, таких как задача о трех заключенных , задача о Монти Холле , задача о двух детях и задача о двух конвертах .

Тестирование на наркотики

Предположим, что конкретный тест на то, употреблял ли кто-то каннабис, имеет 90% чувствительности , что означает истинно положительный показатель (TPR) = 0,90. Таким образом, он приводит к 90% истинно положительных результатов (правильное определение употребления наркотиков) для пользователей каннабиса.

Тест также специфичен на 80% , что означает истинно отрицательный показатель (TNR) = 0,80. Таким образом, тест правильно определяет 80% неиспользования для непользователей, но также генерирует 20% ложноположительных результатов, или ложноположительный показатель (FPR) = 0,20, для непользователей.

Если предположить, что распространенность составляет 0,05 , то есть 5% людей употребляют каннабис, какова вероятность того , что случайный человек, у которого положительный результат теста, действительно употребляет каннабис?

Положительная прогностическая ценность (ППЦ) теста — это доля лиц, которые действительно дали положительный результат, среди всех лиц с положительным результатом теста. Ее можно рассчитать на основе выборки следующим образом:

- PPV = Истинно положительный / Тест положительный

Если известны чувствительность, специфичность и распространенность, PPV можно рассчитать с помощью теоремы Байеса. Пусть означает «вероятность того, что кто-то является потребителем каннабиса, при условии, что его тест положительный», что и означает PPV. Мы можем записать:

Знаменатель — это прямое применение закона полной вероятности . В этом случае он говорит, что вероятность того, что кто-то даст положительный результат, равна вероятности того, что пользователь даст положительный результат, умноженной на вероятность того, что он пользователь, плюс вероятность того, что не-пользователь даст положительный результат, умноженной на вероятность того, что он не-пользователь. Это верно, поскольку классификации «пользователь» и «не-пользователь» образуют раздел множества , а именно множества людей, которые проходят тест на наркотики. Это в сочетании с определением условной вероятности приводит к приведенному выше утверждению.

Другими словами, если у кого-то положительный результат теста, вероятность того, что он употребляет каннабис, составляет всего 19%, поскольку в этой группе только 5% людей употребляют его, а большинство положительных результатов являются ложноположительными, полученными от оставшихся 95%.

Если протестировать 1000 человек:

- 950 не являются пользователями и 190 из них дают ложноположительные результаты (0,20 × 950)

- 50 из них являются пользователями и 45 из них дают истинно положительный ответ (0,90 × 50)

Таким образом, у 1000 человек 235 положительных тестов, из которых только 45 являются подлинными, что составляет около 19%.

Чувствительность или специфичность

Важность специфичности можно продемонстрировать, показав, что даже если чувствительность повысить до 100%, а специфичность сохранить на уровне 80%, вероятность того, что человек с положительным результатом теста является потребителем каннабиса, возрастет только с 19% до 21%, но если чувствительность сохранить на уровне 90%, а специфичность повысить до 95%, вероятность возрастет до 49%.

Тест Действительный | Положительный | Отрицательно | Общий | |

|---|---|---|---|---|

| Пользователь | 45 | 5 | 50 | |

| Не пользователь | 190 | 760 | 950 | |

| Общий | 235 | 765 | 1000 | |

| 90% чувствительности, 80% специфичности, PPV=45/235 ≈ 19% | ||||

Тест Действительный | Положительный | Отрицательно | Общий | |

|---|---|---|---|---|

| Пользователь | 50 | 0 | 50 | |

| Не пользователь | 190 | 760 | 950 | |

| Общий | 240 | 760 | 1000 | |

| 100% чувствительность, 80% специфичность, PPV=50/240 ≈ 21% | ||||

Тест Действительный | Положительный | Отрицательно | Общий | |

|---|---|---|---|---|

| Пользователь | 45 | 5 | 50 | |

| Не пользователь | 47 | 903 | 950 | |

| Общий | 92 | 908 | 1000 | |

| 90% чувствительности, 95% специфичности, PPV=45/92 ≈ 49% | ||||

Уровень заболеваемости раком

Если у всех пациентов с раком поджелудочной железы есть определенный симптом, это не значит, что у любого человека с этим симптомом есть 100% шанс заболеть раком поджелудочной железы. Если предположить, что частота рака поджелудочной железы составляет 1/100000, а у 10/99999 здоровых людей во всем мире есть те же симптомы, вероятность наличия рака поджелудочной железы с учетом симптомов составляет 9,1%, а остальные 90,9% могут быть «ложноположительными» (то есть ложно заявленными о наличии рака; «положительный» — сбивающий с толку термин, когда, как в данном случае, тест дает плохие новости).

В следующей таблице представлены соответствующие цифры на 100 000 человек, основанные на уровне заболеваемости.

Симптом Рак | Да | Нет | Общий | |

|---|---|---|---|---|

| Да | 1 | 0 | 1 | |

| Нет | 10 | 99989 | 99999 | |

| Общий | 11 | 99989 | 100000 | |

Что затем можно использовать для расчета вероятности наличия рака при наличии симптомов:

Коэффициент дефектных изделий

Состояние Машина | Неисправный | Безупречный | Общий | |

|---|---|---|---|---|

| А | 10 | 190 | 200 | |

| Б | 9 | 291 | 300 | |

| С | 5 | 495 | 500 | |

| Общий | 24 | 976 | 1000 | |

Фабрика производит изделия с использованием трех машин — A, B и C, — которые составляют 20%, 30% и 50% ее продукции соответственно. Из изделий, произведенных машиной A, 5% являются дефектными, в то время как 3% изделий B и 1% изделий C являются дефектными. Если случайно выбранная деталь является дефектной, какова вероятность того, что она была произведена машиной C?

Опять же, ответ можно получить, не используя формулу, применив условия к гипотетическому числу случаев. Например, если фабрика производит 1000 изделий, 200 будет произведено на заводе A, 300 на заводе B и 500 на заводе C. Машина A произведет 5% × 200 = 10 дефектных изделий, B 3% × 300 = 9 и C 1% × 500 = 5, что в сумме составит 24. Таким образом, 24/1000 (2,4%) от общего объема производства будут дефектными, а вероятность того, что случайно выбранный дефектный предмет был произведен машиной C, составляет 5/24 (~20,83%).

Эту задачу можно решить также с помощью теоремы Байеса: Пусть X i обозначает событие, что случайно выбранный элемент был изготовлен i -й машиной (для i = A,B,C). Пусть Y обозначает событие, что случайно выбранный элемент является дефектным. Тогда нам дана следующая информация:

Если деталь была изготовлена на первой машине, то вероятность того, что она бракованная, составляет 0,05; то есть P ( Y | X A ) = 0,05. В целом, имеем

Чтобы ответить на исходный вопрос, сначала найдем P (Y). Это можно сделать следующим образом:

Таким образом, 2,4% от общего объема выпускаемой продукции является бракованной.

Нам дано, что произошло событие Y , и мы хотим вычислить условную вероятность события X C. По теореме Байеса,

Учитывая, что деталь неисправна, вероятность того, что она была изготовлена машиной C, составляет 5/24. Машина C производит половину общего объема продукции, но гораздо меньшую долю дефектных деталей. Следовательно, знание того, что выбранная деталь была дефектной, позволяет нам заменить априорную вероятность P ( X C ) = 1/2 меньшей апостериорной вероятностью P ( X C | Y ) = 5/24.

Интерпретации

Интерпретация правила Байеса зависит от интерпретации вероятности, приписываемой терминам. Ниже описаны две преобладающие интерпретации.

Байесовская интерпретация

В байесовской (или эпистемологической) интерпретации вероятность измеряет «степень веры». Теорема Байеса связывает степень веры в предложение до и после учета доказательств. Например, предположим, что с 50% уверенностью полагают, что монета в два раза чаще выпадает орлом, чем решкой. Если монету подбросить несколько раз и наблюдать результаты, эта степень веры, вероятно, вырастет или упадет, но может остаться прежней, в зависимости от результатов. Для предложения A и доказательства B ,

- P ( A ), априорная величина , представляет собой начальную степень веры в A.

- P ( A | B ), апостериорная величина , представляет собой степень уверенности после включения новости о том, что B является правдой.

- частное П ( Б | А )/П ( Б ) представляет собой поддержку, которую B оказывает A.

Более подробную информацию о применении теоремы Байеса при байесовской интерпретации вероятности см. в статье Байесовский вывод .

Частотная интерпретация

В частотной интерпретации вероятность измеряет «долю результатов». Например, предположим, что эксперимент проводится много раз. P ( A ) — это доля результатов со свойством A (априорная), а P ( B ) — это доля результатов со свойством B . P ( B | A ) — это доля результатов со свойством B среди результатов со свойством A , а P ( A | B ) — это доля результатов с A среди результатов с B (апостериорная).

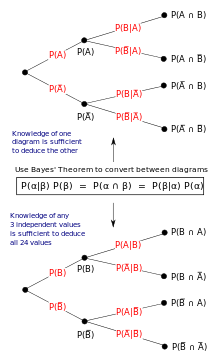

Роль теоремы Байеса можно продемонстрировать с помощью древовидных диаграмм. Две диаграммы разделяют одни и те же результаты по A и B в противоположных порядках, чтобы получить обратные вероятности. Теорема Байеса связывает различные разбиения.

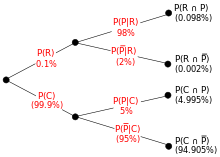

Пример

Энтомолог замечает, что из-за узора на спине может быть редким подвидом жука . У 98 % членов редкого подвида есть узор, поэтому P (Узор | Редкий) = 98 %. Только 5% членов обычного подвида имеют узор. Редкий подвид составляет 0,1% от общей популяции. Насколько вероятно, что жук с узором будет редким: чему равно P (Редкий | Узор)?

Из расширенной формы теоремы Байеса (поскольку любой жук либо редок, либо обычен),

Формы

События

Простая форма

Для событий A и B , при условии, что P ( B ) ≠ 0,

Во многих приложениях, например, в байесовском выводе , событие B фиксируется в обсуждении, и мы хотим рассмотреть влияние его наблюдения на нашу веру в различные возможные события A. В таких ситуациях знаменатель последнего выражения, вероятность данного свидетельства B , фиксируется; то, что мы хотим изменить, это A. Теорема Байеса показывает, что апостериорные вероятности пропорциональны числителю, поэтому последнее уравнение становится следующим:

Другими словами, апостериорная вероятность пропорциональна априорной вероятности, умноженной на вероятность. [21]

Если события A 1 , A 2 , ..., являются взаимоисключающими и исчерпывающими, т. е. одно из них обязательно произойдет, но никакие два не могут произойти вместе, мы можем определить константу пропорциональности, используя тот факт, что их вероятности должны давать в сумме единицу. Например, для данного события A само событие A и его дополнение ¬ A являются исключающими и исчерпывающими. Обозначая константу пропорциональности через c , мы имеем:

Сложив эти две формулы, получаем, что:

или

Альтернативная форма

Фон Предложение | Б | ¬Б (не Б) | Общий | |

|---|---|---|---|---|

| А | Р(В|А)⋅Р(А) = Р(А|В)⋅Р(В) | P(¬B|A)⋅P(A) = P(A|¬B)⋅P(¬B) | П(А) | |

| ¬А (не А) | P(B|¬A)⋅P(¬A) = P(¬A|B)⋅P(B) | P(¬B|¬A)⋅P(¬A) = P(¬A|¬B)⋅P(¬B) | P(¬A) = 1−P(A) | |

| Общий | П(Б) | P(¬B) = 1−P(B) | 1 | |

Другая форма теоремы Байеса для двух конкурирующих утверждений или гипотез выглядит следующим образом:

Для эпистемологической интерпретации:

Для предложения A и доказательства или фона B , [22]

- априорная вероятность , начальная степень веры в А.

- — это соответствующая начальная степень веры в не-А , в то, что А ложно, где

- — это условная вероятность или правдоподобие, степень веры в B при условии, что A истинно.

- — это условная вероятность или правдоподобие, степень веры в B при условии, что A ложно.

- апостериорная вероятность , вероятность события A после учета события B.

Расширенная форма

Часто для некоторого разбиения { A j } пространства выборки пространство событий задается в терминах P ( A j ) и P ( B | A j ). Тогда полезно вычислить P ( B ) с помощью закона полной вероятности :

Или (используя правило умножения для условной вероятности), [23]

В частном случае, когда A — двоичная переменная :

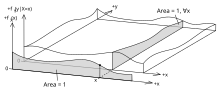

Случайные величины

Рассмотрим выборочное пространство Ω, сгенерированное двумя случайными величинами X и Y с известными распределениями вероятностей. В принципе, теорема Байеса применима к событиям A = { X = x } и B = { Y = y }.

Члены становятся равными 0 в точках, где любая из переменных имеет конечную плотность вероятности . Чтобы оставаться полезной, теорему Байеса можно сформулировать в терминах соответствующих плотностей (см. Вывод).

Простая форма

Если X непрерывен, а Y дискретен,

где каждая из них является функцией плотности.

Если X дискретен, а Y непрерывен,

Если и X, и Y непрерывны,

Расширенная форма

Непрерывное пространство событий часто концептуализируется в терминах числителя. Тогда полезно исключить знаменатель, используя закон полной вероятности . Для f Y ( y ) это становится интегралом:

Правило Байеса в форме вероятности

Теорема Байеса в форме коэффициентов выглядит следующим образом:

где

называется коэффициентом Байеса или отношением правдоподобия . Шансы между двумя событиями — это просто отношение вероятностей двух событий. Таким образом:

Таким образом, правило гласит, что апостериорные шансы равны априорным шансам, умноженным на фактор Байеса ; другими словами, апостериорные шансы пропорциональны априорным шансам, умноженным на вероятность.

В частном случае, когда и , пишут , и используют аналогичное сокращение для фактора Байеса и для условных шансов. Шансы по определению являются шансами за и против . Правило Байеса тогда можно записать в сокращенной форме

или, говоря словами, апостериорные шансы на равны априорным шансам на умножить на отношение правдоподобия для данной информации . Короче говоря, апостериорные шансы равны априорным шансам на умножить на отношение правдоподобия .

Например, если медицинский тест имеет чувствительность 90% и специфичность 91%, то положительный байесовский фактор равен . Теперь, если распространенность этого заболевания составляет 9,09%, и если мы возьмем это в качестве априорной вероятности, то априорные шансы составят около 1:10. Таким образом, после получения положительного результата теста апостериорные шансы наличия заболевания станут 1:1, что означает, что апостериорная вероятность наличия заболевания составит 50%. Если провести второй тест в последовательном тестировании, и он также окажется положительным, то апостериорные шансы наличия заболевания станут 10:1, что означает апостериорную вероятность около 90,91%. Отрицательный байесовский фактор можно рассчитать как 91%/(100%-90%)=9,1, поэтому, если второй тест окажется отрицательным, то апостериорные шансы наличия заболевания составят 1:9,1, что означает апостериорную вероятность около 9,9%.

Пример выше можно также понять с помощью более надежных цифр: предположим, что пациент, проходящий тест, входит в группу из 1000 человек, 91 из которых имеют заболевание (распространенность 9,1%). Если все 1000 пройдут тест, 82 из тех, у кого есть заболевание, получат истинно положительный результат (чувствительность 90,1%), 9 из тех, у кого есть заболевание, получат ложноотрицательный результат ( ложноотрицательный процент 9,9%), 827 из тех, у кого нет заболевания, получат истинно отрицательный результат (специфичность 91,0%), и 82 из тех, у кого нет заболевания, получат ложноположительный результат (ложноположительный процент 9,0%). До прохождения любого теста вероятность наличия заболевания у пациента составляет 91:909. После получения положительного результата вероятность наличия заболевания у пациента составляет

что согласуется с тем фактом, что в группе из 1000 человек имеется 82 истинно положительных результата и 82 ложноположительных результата.

Соответствие другим математическим структурам

Логика высказываний

Там, где определена условная вероятность , можно увидеть, что она фиксирует импликацию . Тогда вероятностное исчисление отражает или даже обобщает различные правила логического вывода. Помимо, например, назначения бинарных значений истинности, здесь присваиваются значения вероятности утверждениям. Утверждение фиксируется утверждением , т. е. что условная вероятность принимает экстремальное значение вероятности . Аналогично, утверждение отрицания импликации фиксируется назначением . [1] Так, например, если , то (если оно определено) , что влечет за собой , введение импликации в логику.

Аналогично, поскольку произведение двух вероятностей, равных друг другу, требует, чтобы оба фактора также были , то можно обнаружить, что теорема Байеса

влечет за собой , что теперь также включает в себя modus ponens .

Для положительных значений , если оно равно , то две условные вероятности также равны, и наоборот. Обратите внимание, что это отражает общедопустимое .

С другой стороны, рассуждение о том, что любая из вероятностей классически равна, влечет за собой следующую контрапозитивную форму вышеизложенного: .

Теорема Байеса с отрицанием дает

- .

Исключая крайний случай (т.е. ), имеем и, в частности,

- .

Исключая также экстремальный случай , можно обнаружить, что они достигают максимума одновременно:

который (по крайней мере, при исключении взрывных антецедентов) отражает классический принцип противопоставления

- .

Субъективная логика

Теорема Байеса представляет собой частный случай вывода инвертированных условных мнений в субъективной логике, выраженный как:

где обозначает оператор инвертирования условных мнений. Аргумент обозначает пару биномиальных условных мнений, заданных источником , а аргумент обозначает априорную вероятность (иначе говоря, базовую ставку ) . Пара производных инвертированных условных мнений обозначается . Условное мнение обобщает вероятностное условное , т. е. в дополнение к назначению вероятности источник может назначить любое субъективное мнение условному утверждению . Биномиальное субъективное мнение — это убеждение в истинности утверждения со степенями эпистемической неопределенности, как выражено источником . Каждое субъективное мнение имеет соответствующую прогнозируемую вероятность . Применение теоремы Байеса к прогнозируемым вероятностям мнений является гомоморфизмом , что означает, что теорему Байеса можно выразить в терминах прогнозируемых вероятностей мнений:

Следовательно, субъективная теорема Байеса представляет собой обобщение теоремы Байеса. [24]

Обобщения

Теорема Байеса для 3 событий

Версия теоремы Байеса для трех событий [25] получается путем добавления третьего события , на котором все вероятности обусловлены:

Вывод

Использование цепного правила

И, с другой стороны,

Требуемый результат получается путем идентификации обоих выражений и решения для .

Использование в генетике

В генетике правило Байеса может быть использовано для оценки вероятности того, что кто-то имеет определенный генотип. Многие люди стремятся оценить свои шансы быть затронутыми генетическим заболеванием или вероятность быть носителем интересующего их рецессивного гена. Байесовский анализ может быть выполнен на основе семейной истории или генетического тестирования, чтобы предсказать, разовьется ли у кого-то заболевание или передаст ли оно его своим детям. Генетическое тестирование и прогнозирование распространены среди пар, которые планируют иметь детей, но обеспокоены тем, что они оба могут быть носителями заболевания, особенно в сообществах с низкой генетической дисперсией. [26]

Использование родословной для расчета вероятностей

| Гипотеза | Гипотеза 1: Пациент является носителем | Гипотеза 2: Пациент не является носителем |

|---|---|---|

| Априорная вероятность | 1/2 | 1/2 |

| Условная вероятность того, что все четыре потомка не будут поражены | (1/2) ⋅ (1/2) ⋅ (1/2) ⋅ (1/2) = 1/16 | Около 1 |

| Совместная вероятность | (1/2) ⋅ (1/16) = 1/32 | (1/2) ⋅ 1 = 1/2 |

| Апостериорная вероятность | (1/32) / (1/32 + 1/2) = 1/17 | (1/2) / (1/32 + 1/2) = 16/17 |

Пример таблицы байесовского анализа для риска заболевания у женщины на основе знания того, что заболевание присутствует у ее братьев и сестер, но не у ее родителей или любого из ее четырех детей. Основываясь исключительно на статусе братьев и сестер и родителей субъекта, она с одинаковой вероятностью может быть носителем, как и неносителем (эта вероятность обозначена априорной гипотезой). Вероятность того, что все четыре сына субъекта будут здоровы, составляет 1/16 ( 1 ⁄ 2 ⋅ 1 ⁄ 2 ⋅ 1 ⁄ 2 ⋅ 1 ⁄ 2 ), если она является носителем, и около 1, если она не является носителем (это условная вероятность). Совместная вероятность согласовывает эти два прогноза, умножая их друг на друга. Последняя строка (апостериорная вероятность) рассчитывается путем деления совместной вероятности для каждой гипотезы на сумму обеих совместных вероятностей. [27]

Использование результатов генетических тестов

Генетическое тестирование родителей может обнаружить около 90% известных аллелей болезней у родителей, которые могут привести к носительству или поражению у их детей. Муковисцидоз — это наследственное заболевание, вызванное аутосомно-рецессивной мутацией в гене CFTR, [28] расположенном на плече q хромосомы 7. [29]

Вот байесовский анализ пациентки с семейным анамнезом муковисцидоза (МВ), которая дала отрицательный результат на МВ, демонстрирующий, как этот метод использовался для определения риска рождения ребенка с МВ: поскольку пациентка не поражена, она либо гомозиготна по аллелю дикого типа, либо гетерозиготна. Для установления априорных вероятностей используется квадрат Паннета, основанный на знании того, что ни один из родителей не был поражен болезнью, но оба могли быть носителями:

Мать Отец | Вт Гомозиготный по аллелю дикого | М Гетерозиготный |

|---|---|---|

| Вт Гомозиготный по аллелю дикого | WW | МВт |

| М Гетерозиготный (носитель муковисцидоза) | МВт | ММ (пораженные муковисцидозом) |

Учитывая, что пациент не поражен, есть только три возможности. В пределах этих трех есть два сценария, в которых пациент является носителем мутантного аллеля. Таким образом, априорные вероятности составляют 2 ⁄ 3 и 1 ⁄ 3 .

Далее пациент проходит генетическое тестирование и получает отрицательный результат на муковисцидоз. Этот тест имеет 90%-ную точность обнаружения, поэтому условные вероятности отрицательного теста составляют 1/10 и 1. Наконец, как и прежде, вычисляются совместная и апостериорная вероятности.

| Гипотеза | Гипотеза 1: Пациент является носителем | Гипотеза 2: Пациент не является носителем |

|---|---|---|

| Априорная вероятность | 2/3 | 1/3 |

| Условная вероятность отрицательного теста | 1/10 | 1 |

| Совместная вероятность | 1/15 | 1/3 |

| Апостериорная вероятность | 1/6 | 5/6 |

После проведения того же анализа в отношении партнера-мужчины пациентки (с отрицательным результатом теста) вероятность того, что их ребенок будет болен, равна произведению соответствующих апостериорных вероятностей того, что родители являются носителями, на вероятность того, что двое носителей произведут больного ребенка ( 1 ⁄ 4 ).

Генетическое тестирование проводится параллельно с выявлением других факторов риска

Байесовский анализ можно выполнить с использованием фенотипической информации, связанной с генетическим состоянием. В сочетании с генетическим тестированием этот анализ становится намного сложнее. Например, кистозный фиброз можно обнаружить у плода с помощью ультразвука, который ищет эхогенный кишечник, который выглядит ярче, чем обычно при сканировании. Это не надежный тест, так как эхогенный кишечник может присутствовать у совершенно здорового плода. Генетическое тестирование родителей очень влиятельно в этом случае, где фенотипический аспект может быть чрезмерно влиятельным при расчете вероятности. В случае плода с эхогенным кишечником, с матерью, которая была протестирована и, как известно, является носителем муковисцидоза, апостериорная вероятность того, что у плода есть это заболевание, очень высока (0,64). Но как только отец получает отрицательный результат теста на муковисцидоз, апостериорная вероятность значительно падает (до 0,16). [27]

Расчет фактора риска является мощным инструментом в генетическом консультировании и репродуктивном планировании, но его нельзя рассматривать как единственный важный фактор. Как и выше, неполное тестирование может дать ложно высокую вероятность статуса носителя, а тестирование может быть финансово недоступным или неосуществимым, если родитель не присутствует.

Смотрите также

- Байесовская эпистемология

- Индуктивная вероятность

- Квантовый байесианизм

- Почему большинство опубликованных результатов исследований ложны , эссе 2005 года по метанауке Джона Иоаннидиса

- Обычная условная вероятность

- Байесовское убеждение

Примечания

- ^ Лаплас совершенствовал теорему Байеса в течение десятилетий:

- Лаплас объявил о своем независимом открытии теоремы Байеса в книгах: Лаплас (1774) «Mémoire sur la вероятностные причины par les événements», «Mémoires de l'Académie royale des Sciences de MI (Savants étrangers)», 4 : 621–656. Перепечатано в: Лаплас, «Oeuvres complètes» (Париж, Франция: Gauthier-Villars et fils, 1841), vol. 8, стр. 27–65. Доступно в Интернете по адресу: Gallica. Теорема Байеса приведена на стр. 29.

- Лаплас представил уточнение теоремы Байеса в: Лапласе (читай: 1783 г. / опубликовано: 1785 г.) «Mémoire sur les Appliance des Formulas qui sont fonctions de très grands nombres», «Mémoires de l'Académie Royale des Sciences de Paris», 423 –467. Перепечатано в: Лаплас, «Oeuvres complètes» (Париж, Франция: Gauthier-Villars et fils, 1844), vol. 10, стр. 295–338. Доступно в Интернете по адресу: Gallica. Теорема Байеса изложена на странице 301.

- См. также: Лаплас, «Essai philosophique sur les probilités» (Париж, Франция: Mme. Ve. Courcier [Madame veuve (т. е. вдова) Courcier], 1814), стр. 10. Английский перевод: Пьер Симон, маркиз де Лаплас с FW. Траскотт и Ф.Л. Эмори, пер., «Философский эссе о вероятностях» (Нью-Йорк, Нью-Йорк). Йорк: Джон Вили и сыновья, 1902), с. 15.

Ссылки

- ^ ab Audun Jøsang, 2016, Субъективная логика; Формализм для рассуждений в условиях неопределенности. Springer, Cham, ISBN 978-3-319-42337-1

- ^ Фрейм, Пол (2015). Апостол свободы. Уэльс: Издательство Уэльского университета. стр. 44. ISBN 978-1783162161. Получено 23 февраля 2021 г. .

- ^ Аллен, Ричард (1999). Дэвид Хартли о природе человека. SUNY Press. С. 243–244 . ISBN 978-0791494516. Получено 16 июня 2013 г.

- ^ Байес, Томас и Прайс, Ричард (1763). «Эссе о решении проблемы в учении о случае. Покойного преподобного г-на Байеса, сообщенное г-ном Прайсом в письме Джону Кантону, AMFRS» Философские труды Лондонского королевского общества . 53 : 370– 418. doi : 10.1098/rstl.1763.0053 .

- ↑ Холланд, стр. 46–47.

- ^ Прайс, Ричард (1991). Прайс: Политические сочинения. Cambridge University Press. стр. xxiii. ISBN 978-0521409698. Получено 16 июня 2013 г.

- ↑ Митчелл 1911, стр. 314.

- ^ Дастон, Лоррейн (1988). Классическая вероятность в эпоху Просвещения. Princeton Univ Press. стр. 268. ISBN 0691084971.

- ^ Стиглер, Стивен М. (1986). «Обратная вероятность». История статистики: измерение неопределенности до 1900 года . Издательство Гарвардского университета. С. 99–138 . ISBN 978-0674403413.

- ^ Джеффрис, Гарольд (1973). Научный вывод (3-е изд.). Cambridge University Press . стр. 31. ISBN 978-0521180788.

- ^ Стиглер, Стивен М. (1983). «Кто открыл теорему Байеса?». Американский статистик . 37 (4): 290– 296. doi :10.1080/00031305.1983.10483122.

- ^ де Во, Ричард; Веллеман, Пол; Бок, Дэвид (2016). Статистика, данные и модели (4-е изд.). Пирсон. стр. 380–381 . ISBN. 978-0321986498.

- ^ Эдвардс, AWF (1986). «Является ли ссылка в Хартли (1749) на байесовский вывод?». The American Statistician . 40 (2): 109– 110. doi :10.1080/00031305.1986.10475370.

- ^ Хупер, Мартин (2013). «Ричард Прайс, теорема Байеса и Бог». Значимость . 10 (1): 36–39 . doi : 10.1111/j.1740-9713.2013.00638.x . S2CID 153704746.

- ^ ab McGrayne, SB (2011). Теория, которая не умрет: как правило Байеса взломало код «Энигмы», выследило русские подлодки и вышло победителем из двух столетий споров . Yale University Press . ISBN 978-0300188226.

- ^ Стюарт, А.; Орд, К. (1994), Усовершенствованная теория статистики Кендалла: Том I – Теория распределения , Эдвард Арнольд , §8.7

- ^ Колмогоров, А. Н. (1933) [1956]. Основы теории вероятностей . Chelsea Publishing Company.

- ^ Tjur, Tue (1980). Вероятность, основанная на мерах Радона. Нью-Йорк: Wiley. ISBN 978-0-471-27824-5.

- ^ Таральдсен, Гуннар; Туфто, Ярле; Линдквист, Бо Х. (24 июля 2021 г.). «Неправильные априорные и неправильные апостериорные». Скандинавский статистический журнал . 49 (3): 969–991 . doi : 10.1111/sjos.12550 . hdl : 11250/2984409 . ISSN 0303-6898. S2CID 237736986.

- ^ Роберт, Кристиан П.; Каселла, Джордж (2004). Статистические методы Монте-Карло. Springer. ISBN 978-1475741452. OCLC 1159112760.

- ^ Ли, Питер М. (2012). "Глава 1". Байесовская статистика . Wiley . ISBN 978-1-1183-3257-3.

- ^ "Теорема Байеса: Введение". Университет Тринити . Архивировано из оригинала 21 августа 2004 года . Получено 5 августа 2014 года .

- ^ "Теорема Байеса - Формула, Утверждение, Доказательство | Правило Байеса". Cuemath . Получено 20.10.2023 .

- ^ Аудун Йосанг, 2016, Обобщение теоремы Байеса в субъективной логике. Международная конференция IEEE по мультисенсорному слиянию и интеграции для интеллектуальных систем (MFI 2016), Баден-Баден, сентябрь 2016 г.

- ^ Коллер, Д .; Фридман, Н. (2009). Вероятностные графические модели. Массачусетс: MIT Press. п. 1208. ИСБН 978-0-262-01319-2. Архивировано из оригинала 2014-04-27.

- ^ Крафт, Стефани А.; Дуэнас, Деван; Вилфонд, Бенджамин С.; Годдард, Катрина АБ (24 сентября 2018 г.). «Развивающийся ландшафт расширенного скрининга носителей: проблемы и возможности». Генетика в медицине . 21 (4): 790– 797. doi :10.1038/s41436-018-0273-4. PMC 6752283. PMID 30245516 .

- ^ ab Ogino, Shuji; Wilson, Robert B; Gold, Bert; Hawley, Pamela; Grody, Wayne W (октябрь 2004 г.). «Байесовский анализ рисков муковисцидоза при пренатальном скрининге и скрининге носителей». Genetics in Medicine . 6 (5): 439– 449. doi : 10.1097/01.GIM.0000139511.83336.8F . PMID 15371910.

- ^ «Типы мутаций CFTR». Фонд муковисцидоза, www.cff.org/What-is-CF/Genetics/Types-of-CFTR-Mutations/.

- ^ "CFTR Gene – Genetics Home Reference". Национальная медицинская библиотека США, Национальные институты здравоохранения, ghr.nlm.nih.gov/gene/CFTR#location.

Библиография

- В этой статье использован текст из публикации, которая сейчас находится в общественном достоянии : Митчелл, Джон Малкольм (1911). «Прайс, Ричард». В книге Чисхолма, Хью (ред.). Encyclopaedia Britannica . Том 22 (11-е изд.). Cambridge University Press. С. 314–315 .

Дальнейшее чтение

- Болстад, Уильям М.; Карран, Джеймс М. (2017). «Логика, вероятность и неопределенность». Введение в байесовскую статистику (3-е изд.). Нью-Йорк: Wiley. С. 59–82 . ISBN 978-1-118-09156-2.

- Ли, Питер М. (2012). Байесовская статистика: Введение (4-е изд.). Wiley. ISBN 978-1-118-33257-3.

- Шмитт, Сэмюэл А. (1969). «Накопление доказательств». Измерение неопределенности: элементарное введение в байесовскую статистику . Чтение: Addison-Wesley. стр. 61–99 . OCLC 5013.

- Стиглер, Стивен М. (август 1986 г.). «Мемуары Лапласа 1774 года об обратной вероятности». Статистическая наука . 1 (3): 359– 363. doi : 10.1214/ss/1177013620 .

Внешние ссылки

- «Байесовская ловушка». Veritasium . 5 апреля 2017 г. – через YouTube .

![{\displaystyle {\begin{aligned}P({\text{Пользователь}}\vert {\text{Положительный}})&={\frac {P({\text{Положительный}}\vert {\text{Пользователь}})P({\text{Пользователь}})}{P({\text{Положительный}})}}\\&={\frac {P({\text{Положительный}}\vert {\text{Пользователь}})P({\text{Пользователь}})}{P({\text{Положительный}}\vert {\text{Пользователь}})P({\text{Пользователь}})+P({\text{Положительный}}\vert {\text{Не пользователь}})P({\text{Не пользователь}})}}\\[8pt]&={\frac {0.90\times 0,05}{0,90\times 0,05+0,20\times 0,95}}={\frac {0,045}{0,045+0,19}}\approx 19\%\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c26c47487bf7b0fc56304c7123c3890a2b3e0f15)

![{\displaystyle {\begin{aligned}P({\text{Рак}}|{\text{Симптомы}})&={\frac {P({\text{Симптомы}}|{\text{Рак}})P({\text{Рак}})}{P({\text{Симптомы}})}}\\&={\frac {P({\text{Симптомы}}|{\text{Рак}})P({\text{Рак}})}{P({\text{Симптомы}}|{\text{Рак}})P({\text{Рак}})+P({\text{Симптомы}}|{\text{Нерак}})P({\text{Нерак}})}}\\[8pt]&={\frac {1\times 0,00001}{1\times 0,00001+(10/99999)\times 0,99999}}={\frac {1}{11}}\approx 9,1\%\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d78d8f2bcc4f4b701033a5b1f1c2bf6c050970f6)

![{\displaystyle {\begin{aligned}P({\text{Редкий}}\vert {\text{Узор}})&={\frac {P({\text{Узор}}\vert {\text{Редкий}})\,P({\text{Редкий}})}{P({\text{Узор}})}}\\[8pt]&={\tfrac {P({\text{Узор}}\vert {\text{Редкий}})\,P({\text{Редкий}})}{P({\text{Узор}}\vert {\text{Редкий}})\,P({\text{Редкий}})+P({\text{Узор}}\vert {\text{Обычный}})\,P({\text{Обычный}})}}\\[8pt]&={\frac {0.98\times 0,001}{0,98\times 0,001+0,05\times 0,999}}\\[8pt]&\approx 1,9\%\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/db5dde505d680ed31c343105203efc38506e9132)