Распределение Стьюдента

Функция плотности вероятности  | |||

Кумулятивная функция распределения  | |||

| Параметры | степени свободы ( действительные , почти всегда положительные целые числа ) | ||

|---|---|---|---|

| Поддерживать | |||

| СДФ | |||

| Иметь в виду | для иного неопределенного | ||

| Медиана | |||

| Режим | |||

| Дисперсия | для ∞ для других неопределенных | ||

| Асимметрия | для иного неопределенного | ||

| Избыточный эксцесс | для ∞ для других неопределенных | ||

| Энтропия |

| ||

| МГФ | неопределенный | ||

| CF | для | ||

| Ожидаемый дефицит | Где — обратная стандартизированная функция распределения плотности распределения Стьюдента t , а — стандартизированная функция распределения плотности распределения Стьюдента t . [2] | ||

В теории вероятностей и статистике распределение Стьюдента (или просто распределение Стьюдента ) — это непрерывное распределение вероятностей , обобщающее стандартное нормальное распределение . Как и последнее, оно симметрично относительно нуля и имеет форму колокола.

Однако имеет более тяжелые хвосты , а величина вероятностной массы в хвостах контролируется параметром Для t- распределение Стьюдента становится стандартным распределением Коши , имеющим очень «толстые» хвосты ; тогда как для оно становится стандартным нормальным распределением, имеющим очень «тонкие» хвосты.

Распределение Стьюдента играет роль в ряде широко используемых статистических анализов, включая t- критерий Стьюдента для оценки статистической значимости разницы между двумя выборочными средними значениями, построения доверительных интервалов для разницы между двумя средними значениями совокупности и линейного регрессионного анализа .

В форме t - распределения по шкале местоположения оно обобщает нормальное распределение , а также возникает в байесовском анализе данных из нормальной семьи как сложное распределение при маргинализации по параметру дисперсии.

История и этимология

В статистике распределение t было впервые получено как апостериорное распределение в 1876 году Гельмертом [3] [4] [5] и Люротом . [6] [7] [8] Таким образом, распределение t Стьюдента является примером закона эпонимии Стиглера . Распределение t также появилось в более общей форме как распределение Пирсона типа IV в статье Карла Пирсона 1895 года. [9]

В англоязычной литературе название дистрибуции взято из статьи Уильяма Сили Госсета 1908 года в Biometrika под псевдонимом «Студент». [10] Одна из версий происхождения псевдонима заключается в том, что работодатель Госсета предпочитал, чтобы сотрудники использовали псевдонимы при публикации научных работ вместо их настоящих имен, поэтому он использовал имя «Студент», чтобы скрыть свою личность. Другая версия заключается в том, что Guinness не хотел, чтобы их конкуренты знали, что они используют t- тест для определения качества сырья. [11] [12]

Госсет работал на пивоварне Guinness Brewery в Дублине, Ирландия , и интересовался проблемами малых выборок – например, химическими свойствами ячменя, где размеры выборки могли быть всего 3. В статье Госсета распределение называется «частотным распределением стандартных отклонений выборок, взятых из нормальной популяции». Оно стало широко известно благодаря работе Рональда Фишера , который назвал распределение «распределением Стьюдента» и обозначил тестовое значение буквой t . [13] [14]

Определение

Функция плотности вероятности

Распределение Стьюдента имеет функцию плотности вероятности (PDF), заданную как

где - число степеней свободы , а - гамма-функция . Это также можно записать как

где бета- функция . В частности, для целочисленных степеней свободы имеем:

Для и даже,

Для и нечетных,

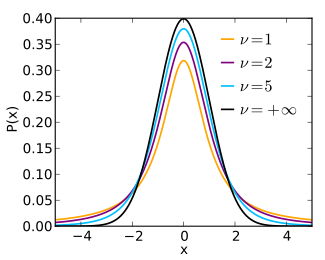

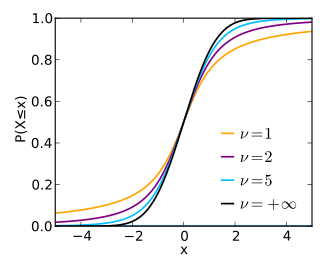

Функция плотности вероятности симметрична , и ее общая форма напоминает форму колокола нормально распределенной переменной со средним значением 0 и дисперсией 1, за исключением того, что она немного ниже и шире. По мере увеличения числа степеней свободы распределение t приближается к нормальному распределению со средним значением 0 и дисперсией 1. По этой причине также известно как параметр нормальности. [15]

На следующих изображениях показана плотность распределения t для возрастающих значений Нормальное распределение показано синей линией для сравнения. Обратите внимание, что распределение t (красная линия) становится ближе к нормальному распределению по мере увеличения.

Предыдущие графики показаны зеленым.

Кумулятивная функция распределения

Кумулятивную функцию распределения (CDF) можно записать в терминах I , регуляризованной неполной бета-функции . Для t > 0 ,

где

Другие значения будут получены с помощью симметрии. Альтернативная формула, действительная для

где — частный случай гипергеометрической функции .

Информацию об обратной кумулятивной функции распределения см. в разделе Функция квантиля § Распределение Стьюдента .

Особые случаи

Определенные значения дают простую форму для t-распределения Стьюдента.

| СДФ | примечания | ||

|---|---|---|---|

| 1 | См. распределение Коши | ||

| 2 | |||

| 3 | |||

| 4 | |||

| 5 | |||

| См. Нормальное распределение , Функция ошибки |

Моменты

Для сырых моментов распределения t есть

Моментов порядка или выше не существует. [16]

Термин для k четный можно упростить, используя свойства гамма-функции :

Для t - распределения со степенями свободы ожидаемое значение равно , если , а его дисперсия равна , если Асимметрия равна 0, если , а избыточный эксцесс равен , если

Местоположение-масштабт распределение

Преобразование масштаба местоположения

Распределение Стьюдента обобщается до трехпараметрического распределения t по местоположению и масштабу путем введения параметра местоположения и параметра масштаба .

и трансформация семьи в масштабе местоположения

мы получаем

Полученное распределение также называется нестандартизированным распределением Стьюдента .

Плотность и первые два момента

Распределение масштаба местоположения t имеет плотность, определяемую следующим образом: [17]

Эквивалентно, плотность можно записать в терминах :

Другие свойства этой версии дистрибутива: [17]

Особые случаи

- Если следует распределение t по шкале местоположения , то для имеет нормальное распределение со средним значением и дисперсией

- Распределение t по шкале местоположения со степенью свободы эквивалентно распределению Коши

- Распределение t по шкале местоположения с и сводится к распределению t Стьюдента

Какт возникает распределение (характеристика)

Как распределение тестовой статистики

Распределение Стьюдента со степенями свободы можно определить как распределение случайной величины T с [18] [19]

где

- Z — стандартное нормальное распределение с ожидаемым значением 0 и дисперсией 1;

- V имеет распределение хи-квадрат ( χ 2 -распределение ) со степенями свободы ;

- Z и V независимы ;

Другое распределение определяется как распределение случайной величины, определяемой для заданной константы μ следующим образом:

Эта случайная величина имеет нецентральное t -распределение с параметром нецентральности μ . Это распределение важно при изучении мощности t - критерия Стьюдента .

Вывод

Предположим, что X 1 , ..., X n являются независимыми реализациями нормально распределенной случайной величины X , которая имеет ожидаемое значение μ и дисперсию σ 2 . Пусть

быть выборочным средним, и

быть несмещенной оценкой дисперсии из выборки. Можно показать, что случайная величина

имеет распределение хи-квадрат со степенями свободы (по теореме Кохрана ). [20] Легко показать, что величина

нормально распределена со средним значением 0 и дисперсией 1, поскольку выборочное среднее значение нормально распределено со средним значением μ и дисперсией σ 2 / n . Более того, можно показать, что эти две случайные величины (нормально распределенная Z и распределенная по закону хи-квадрат V ) независимы. Следовательно [ необходимо разъяснение ] основная величина

которая отличается от Z тем, что точное стандартное отклонение σ заменяется случайной величиной S n , имеет распределение Стьюдента t, как определено выше. Обратите внимание, что неизвестная дисперсия популяции σ 2 не появляется в T , поскольку она была и в числителе, и в знаменателе, поэтому она сокращается. Госсет интуитивно получил функцию плотности вероятности, указанную выше, с равным n − 1, и Фишер доказал ее в 1925 году. [13]

Распределение тестовой статистики T зависит от , но не от μ или σ ; отсутствие зависимости от μ и σ делает t -распределение важным как в теории, так и на практике.

Выборочное распределение t-статистики

Распределение t возникает как выборочное распределение t - статистики. Ниже обсуждается одновыборочная t- статистика, для соответствующей двухвыборочной t- статистики см. t-критерий Стьюдента .

Несмещенная оценка дисперсии

Пусть — независимые и одинаково распределенные выборки из нормального распределения со средним значением и дисперсией. Выборочное среднее значение и несмещенная выборочная дисперсия определяются по формуле:

Результирующая (одна выборка) t- статистика определяется как

и распределено по закону Стьюдента со степенями свободы.

Таким образом, для целей вывода t- статистика является полезной « основной величиной » в случае, когда среднее значение и дисперсия являются неизвестными параметрами популяции, в том смысле, что t- статистика имеет тогда распределение вероятностей, которое не зависит ни от

Оценка дисперсии ML

Вместо несмещенной оценки мы также можем использовать оценку максимального правдоподобия.

что дает статистику

Это распределено в соответствии с распределением масштаба местоположения :

Составное распределение нормального с обратным гамма-распределением

Распределение t по шкале местоположения получается в результате объединения гауссовского распределения (нормального распределения) со средним значением и неизвестной дисперсией , с обратным гамма-распределением, помещенным над дисперсией с параметрами и Другими словами, предполагается, что случайная величина X имеет гауссово распределение с неизвестной дисперсией, распределенной как обратная гамма, а затем дисперсия маргинализируется ( интегрируется).

Эквивалентно, это распределение получается в результате соединения гауссовского распределения с масштабированным обратным распределением хи-квадрат с параметрами и Масштабированное обратное распределение хи-квадрат является точно таким же распределением, как и обратное гамма-распределение, но с другой параметризацией, т.е.

Причина полезности этой характеристики заключается в том, что в байесовской статистике обратное гамма-распределение является сопряженным априорным распределением дисперсии гауссовского распределения. В результате распределение t по шкале местоположения естественным образом возникает во многих байесовских задачах вывода. [21]

Максимальное распределение энтропии

Распределение Стьюдента — это распределение вероятности максимальной энтропии для случайной величины X, для которой фиксировано. [22] [ необходимо разъяснение ] [ необходим лучший источник ]

Дополнительные свойства

выборка Монте-Карло

Существуют различные подходы к построению случайных выборок из распределения Стьюдента t . Вопрос зависит от того, требуются ли выборки на автономной основе или должны быть построены путем применения квантильной функции к однородным выборкам; например, в многомерных приложениях на основе копула-зависимости . [ требуется ссылка ] В случае автономной выборки расширение метода Бокса-Мюллера и его полярной формы легко развертывается. [23] Его достоинство в том, что он одинаково хорошо применим ко всем действительным положительным степеням свободы , ν , в то время как многие другие методы-кандидаты терпят неудачу, если ν близко к нулю. [23]

Интеграл функции плотности вероятности Стьюдента ип-ценить

Функция A ( t | ν ) является интегралом функции плотности вероятности Стьюдента, f ( t ) между -t и t , для t ≥ 0 . Таким образом, она дает вероятность того, что значение t меньше, чем рассчитанное по наблюдаемым данным, возникнет случайно. Следовательно, функцию A ( t | ν ) можно использовать при проверке того, является ли разница между средними значениями двух наборов данных статистически значимой, путем вычисления соответствующего значения t и вероятности его появления, если бы два набора данных были взяты из одной и той же популяции. Это используется в различных ситуациях, особенно в t -тестах . Для статистики t с ν степенями свободы A ( t | ν ) является вероятностью того, что t будет меньше наблюдаемого значения, если бы два средних значения были одинаковыми (при условии, что меньшее среднее значение вычитается из большего, так что t ≥ 0 ). Его можно легко рассчитать из кумулятивной функции распределения F ν ( t ) t -распределения :

где I x ( a , b ) — регуляризованная неполная бета-функция .

Для статистической проверки гипотез эта функция используется для построения p -значения .

Связанные дистрибутивы

- Нецентральное распределение t обобщает распределение t , включая параметр нецентральности. В отличие от нестандартизированных распределений t , нецентральные распределения не являются симметричными (медиана не совпадает с модой).

- Дискретное распределение Стьюдента t определяется его функцией массы вероятности при r , пропорциональной: [24] Здесь a , b , и k являются параметрами. Это распределение возникает из построения системы дискретных распределений, подобной распределению Пирсона для непрерывных распределений. [25]

- Можно сгенерировать выборки Стьюдента A ( t | ν ), взяв отношение переменных из нормального распределения и квадратный корень из распределения χ² . Если вместо нормального распределения использовать, например, распределение Ирвина–Холла , то в целом получим симметричное распределение с 4 параметрами, которое включает нормальное, равномерное , треугольное , распределение Стьюдента t и распределение Коши . Это также более гибко, чем некоторые другие симметричные обобщения нормального распределения.

- Распределение t является примером пропорциональных распределений .

- Квадрат случайной величины, распределенной t(n), распределен F(1,n) .

Использует

В частотном статистическом выводе

Распределение Стьюдента t возникает в различных задачах статистической оценки, где целью является оценка неизвестного параметра, например, среднего значения, в условиях, когда данные наблюдаются с аддитивными ошибками . Если (как почти во всех практических статистических работах) среднеквадратическое отклонение этих ошибок неизвестно и должно быть оценено на основе данных, то распределение t часто используется для учета дополнительной неопределенности, которая возникает в результате этой оценки. В большинстве таких задач, если бы среднеквадратическое отклонение ошибок было известно, вместо распределения t использовалось бы нормальное распределение .

Доверительные интервалы и проверки гипотез — это две статистические процедуры, в которых требуются квантили выборочного распределения конкретной статистики (например, стандартной оценки ). В любой ситуации, когда эта статистика является линейной функцией данных , деленной на обычную оценку стандартного отклонения, полученное количество можно масштабировать и центрировать так, чтобы оно соответствовало распределению Стьюдента . Статистический анализ, включающий средние значения, взвешенные средние значения и коэффициенты регрессии, приводит к статистике, имеющей такую форму.

Довольно часто в задачах учебника среднеквадратическое отклонение генеральной совокупности рассматривается так, как будто оно известно, и, таким образом, избегается необходимость использования распределения Стьюдента . Эти задачи обычно бывают двух видов: (1) те, в которых размер выборки настолько велик, что можно рассматривать оценку дисперсии на основе данных так , как будто она определена, и (2) те, которые иллюстрируют математические рассуждения, в которых проблема оценки среднеквадратического отклонения временно игнорируется, поскольку это не то, что автор или преподаватель затем объясняет.

Проверка гипотез

Можно показать, что ряд статистик имеет t- распределения для выборок среднего размера при нулевых гипотезах , которые представляют интерес, так что t- распределение формирует основу для тестов значимости. Например, распределение коэффициента ранговой корреляции Спирмена ρ в нулевом случае (нулевая корреляция) хорошо аппроксимируется t- распределением для выборок размером более 20. [ необходима цитата ]

Доверительные интервалы

Предположим, что число A выбрано таким образом, что

когда T имеет распределение t с n − 1 степенями свободы. По симметрии это то же самое, что сказать, что A удовлетворяет

поэтому A — это «95-й процентиль» этого распределения вероятностей, или Тогда

и это эквивалентно

Следовательно, интервал, конечные точки которого

является 90% доверительным интервалом для μ. Таким образом, если мы находим среднее значение набора наблюдений, которое, как мы можем обоснованно ожидать, будет иметь нормальное распределение, мы можем использовать t- распределение, чтобы проверить, включают ли доверительные пределы этого среднего значения некоторое теоретически предсказанное значение – например, значение, предсказанное на основе нулевой гипотезы .

Именно этот результат используется в t- критериях Стьюдента : поскольку разница между средними значениями выборок из двух нормальных распределений сама по себе распределена нормально, t- распределение можно использовать для проверки того, можно ли обоснованно предположить, что эта разница равна нулю.

Если данные распределены нормально, то односторонний (1 − α ) верхний доверительный предел (UCL) среднего значения можно рассчитать с помощью следующего уравнения:

Результирующий UCL будет наибольшим средним значением, которое будет иметь место для заданного доверительного интервала и размера популяции. Другими словами, будучи средним значением набора наблюдений, вероятность того, что среднее значение распределения ниже UCL 1 − α , равна уровню достоверности 1 − α .

Интервалы прогнозирования

Распределение t можно использовать для построения интервала прогнозирования для ненаблюдаемой выборки из нормального распределения с неизвестным средним значением и дисперсией.

В байесовской статистике

Распределение Стьюдента , особенно в его трехпараметрической (масштаб-местоположение) версии, часто возникает в байесовской статистике в результате его связи с нормальным распределением. Всякий раз, когда дисперсия нормально распределенной случайной величины неизвестна и над ней помещается сопряженное априорное распределение, которое следует обратному гамма-распределению , результирующее маргинальное распределение переменной будет следовать распределению Стьюдента . Эквивалентные конструкции с теми же результатами включают сопряженное масштабированное-обратное-хи-квадрат распределение по дисперсии или сопряженное гамма-распределение по точности . Если неправильное априорное распределение пропорционально 1/ σ ² помещается над дисперсией, также возникает распределение t . Это имеет место независимо от того, известно ли среднее значение нормально распределенной переменной, неизвестно ли оно распределено в соответствии с сопряженным нормально распределенным априором или неизвестно распределено в соответствии с несобственным постоянным априором.

Связанные ситуации, которые также приводят к распределению t :

- Маргинальное апостериорное распределение неизвестного среднего значения нормально распределенной переменной с неизвестным априорным средним значением и дисперсией в соответствии с вышеприведенной моделью.

- Априорное прогнозируемое распределение и апостериорное прогнозируемое распределение новой нормально распределенной точки данных, когда наблюдаются ряд независимых одинаково распределенных нормально распределенных точек данных с априорным средним значением и дисперсией, как в приведенной выше модели.

Надежное параметрическое моделирование

Распределение t часто используется как альтернатива нормальному распределению в качестве модели для данных, которые часто имеют более тяжелые хвосты, чем допускает нормальное распределение; см., например, Lange et al. [26] Классический подход заключался в выявлении выбросов (например, с помощью теста Граббса ) и исключении или понижении их веса каким-либо образом. Однако не всегда легко выявить выбросы (особенно в больших размерностях ), и распределение t является естественным выбором модели для таких данных и обеспечивает параметрический подход к надежной статистике .

Байесовский отчет можно найти в Gelman et al. [27] Параметр степеней свободы контролирует эксцесс распределения и коррелирует с параметром масштаба. Правдоподобие может иметь несколько локальных максимумов, и, как таковое, часто необходимо зафиксировать степени свободы на довольно низком значении и оценить другие параметры, принимая это как данность. Некоторые авторы [ требуется цитата ] сообщают, что значения от 3 до 9 часто являются хорошим выбором. Venables и Ripley [ требуется цитата ] предполагают, что значение 5 часто является хорошим выбором.

Студенческийт процесс

Для практических нужд регрессии и прогнозирования были введены процессы Стьюдента t , которые являются обобщениями распределений Стьюдента t для функций. Процесс Стьюдента t строится из распределений Стьюдента t , как гауссовский процесс строится из гауссовых распределений . Для гауссовского процесса все наборы значений имеют многомерное гауссовское распределение. Аналогично, является процессом Стьюдента t на интервале , если соответствующие значения процесса ( ) имеют совместное многомерное распределение Стьюдента t . [28] Эти процессы используются для регрессии, прогнозирования, байесовской оптимизации и связанных с ними задач. Для многомерной регрессии и многовыходного прогнозирования вводятся и используются многомерные процессы Стьюдента t . [29]

Таблица выбранных значений

В следующей таблице перечислены значения для распределений t с ν степенями свободы для диапазона односторонних или двусторонних критических областей. Первый столбец — ν , проценты сверху — уровни достоверности , а числа в теле таблицы — факторы, описанные в разделе о доверительных интервалах.

Последняя строка с бесконечным ν дает критические точки для нормального распределения, поскольку t- распределение с бесконечным числом степеней свободы является нормальным распределением. (См. Связанные распределения выше).

| Односторонний | 75% | 80% | 85% | 90% | 95% | 97,5% | 99% | 99,5% | 99,75% | 99,9% | 99,95% |

|---|---|---|---|---|---|---|---|---|---|---|---|

| Двусторонний | 50% | 60% | 70% | 80% | 90% | 95% | 98% | 99% | 99,5% | 99,8% | 99,9% |

| 1 | 1.000 | 1.376 | 1.963 | 3.078 | 6.314 | 12.706 | 31.821 | 63.657 | 127.321 | 318.309 | 636.619 |

| 2 | 0,816 | 1.061 | 1.386 | 1.886 | 2.920 | 4.303 | 6.965 | 9.925 | 14.089 | 22.327 | 31.599 |

| 3 | 0,765 | 0,978 | 1.250 | 1.638 | 2.353 | 3.182 | 4.541 | 5.841 | 7.453 | 10.215 | 12.924 |

| 4 | 0,741 | 0,941 | 1.190 | 1.533 | 2.132 | 2.776 | 3.747 | 4.604 | 5.598 | 7.173 | 8.610 |

| 5 | 0,727 | 0,920 | 1.156 | 1.476 | 2.015 | 2.571 | 3.365 | 4.032 | 4.773 | 5.893 | 6.869 |

| 6 | 0,718 | 0,906 | 1.134 | 1.440 | 1.943 | 2.447 | 3.143 | 3.707 | 4.317 | 5.208 | 5.959 |

| 7 | 0,711 | 0,896 | 1.119 | 1.415 | 1.895 | 2.365 | 2.998 | 3.499 | 4.029 | 4.785 | 5.408 |

| 8 | 0,706 | 0,889 | 1.108 | 1.397 | 1.860 | 2.306 | 2.896 | 3.355 | 3.833 | 4.501 | 5.041 |

| 9 | 0,703 | 0,883 | 1.100 | 1.383 | 1.833 | 2.262 | 2.821 | 3.250 | 3.690 | 4.297 | 4.781 |

| 10 | 0.700 | 0,879 | 1.093 | 1.372 | 1.812 | 2.228 | 2.764 | 3.169 | 3.581 | 4.144 | 4.587 |

| 11 | 0,697 | 0,876 | 1.088 | 1.363 | 1.796 | 2.201 | 2.718 | 3.106 | 3.497 | 4.025 | 4.437 |

| 12 | 0,695 | 0,873 | 1.083 | 1.356 | 1.782 | 2.179 | 2.681 | 3.055 | 3.428 | 3.930 | 4.318 |

| 13 | 0,694 | 0,870 | 1.079 | 1.350 | 1.771 | 2.160 | 2.650 | 3.012 | 3.372 | 3.852 | 4.221 |

| 14 | 0,692 | 0,868 | 1.076 | 1.345 | 1.761 | 2.145 | 2.624 | 2.977 | 3.326 | 3.787 | 4.140 |

| 15 | 0,691 | 0,866 | 1.074 | 1.341 | 1.753 | 2.131 | 2.602 | 2.947 | 3.286 | 3.733 | 4.073 |

| 16 | 0.690 | 0,865 | 1.071 | 1.337 | 1.746 | 2.120 | 2.583 | 2.921 | 3.252 | 3.686 | 4.015 |

| 17 | 0,689 | 0,863 | 1.069 | 1.333 | 1.740 | 2.110 | 2.567 | 2.898 | 3.222 | 3.646 | 3.965 |

| 18 | 0,688 | 0,862 | 1.067 | 1.330 | 1.734 | 2.101 | 2.552 | 2.878 | 3.197 | 3.610 | 3.922 |

| 19 | 0,688 | 0,861 | 1.066 | 1.328 | 1.729 | 2.093 | 2.539 | 2.861 | 3.174 | 3.579 | 3.883 |

| 20 | 0,687 | 0,860 | 1.064 | 1.325 | 1.725 | 2.086 | 2.528 | 2.845 | 3.153 | 3.552 | 3.850 |

| 21 | 0,686 | 0,859 | 1.063 | 1.323 | 1.721 | 2.080 | 2.518 | 2.831 | 3.135 | 3.527 | 3.819 |

| 22 | 0,686 | 0,858 | 1.061 | 1.321 | 1.717 | 2.074 | 2.508 | 2.819 | 3.119 | 3.505 | 3.792 |

| 23 | 0,685 | 0,858 | 1.060 | 1.319 | 1.714 | 2.069 | 2.500 | 2.807 | 3.104 | 3.485 | 3.767 |

| 24 | 0,685 | 0,857 | 1.059 | 1.318 | 1.711 | 2.064 | 2.492 | 2.797 | 3.091 | 3.467 | 3.745 |

| 25 | 0,684 | 0,856 | 1.058 | 1.316 | 1.708 | 2.060 | 2.485 | 2.787 | 3.078 | 3.450 | 3.725 |

| 26 | 0,684 | 0,856 | 1.058 | 1.315 | 1.706 | 2.056 | 2.479 | 2.779 | 3.067 | 3.435 | 3.707 |

| 27 | 0,684 | 0,855 | 1.057 | 1.314 | 1.703 | 2.052 | 2.473 | 2.771 | 3.057 | 3.421 | 3.690 |

| 28 | 0,683 | 0,855 | 1.056 | 1.313 | 1.701 | 2.048 | 2.467 | 2.763 | 3.047 | 3.408 | 3.674 |

| 29 | 0,683 | 0,854 | 1.055 | 1.311 | 1.699 | 2.045 | 2.462 | 2.756 | 3.038 | 3.396 | 3.659 |

| 30 | 0,683 | 0,854 | 1.055 | 1.310 | 1.697 | 2.042 | 2.457 | 2.750 | 3.030 | 3.385 | 3.646 |

| 40 | 0,681 | 0,851 | 1.050 | 1.303 | 1.684 | 2.021 | 2.423 | 2.704 | 2.971 | 3.307 | 3.551 |

| 50 | 0,679 | 0,849 | 1.047 | 1.299 | 1.676 | 2.009 | 2.403 | 2.678 | 2.937 | 3.261 | 3.496 |

| 60 | 0,679 | 0,848 | 1.045 | 1.296 | 1.671 | 2.000 | 2.390 | 2.660 | 2.915 | 3.232 | 3.460 |

| 80 | 0,678 | 0,846 | 1.043 | 1.292 | 1.664 | 1.990 | 2.374 | 2.639 | 2.887 | 3.195 | 3.416 |

| 100 | 0,677 | 0,845 | 1.042 | 1.290 | 1.660 | 1.984 | 2.364 | 2.626 | 2.871 | 3.174 | 3.390 |

| 120 | 0,677 | 0,845 | 1.041 | 1.289 | 1.658 | 1.980 | 2.358 | 2.617 | 2.860 | 3.160 | 3.373 |

| ∞ | 0,674 | 0,842 | 1.036 | 1.282 | 1.645 | 1.960 | 2.326 | 2.576 | 2.807 | 3.090 | 3.291 |

| Односторонний | 75% | 80% | 85% | 90% | 95% | 97,5% | 99% | 99,5% | 99,75% | 99,9% | 99,95% |

| Двусторонний | 50% | 60% | 70% | 80% | 90% | 95% | 98% | 99% | 99,5% | 99,8% | 99,9% |

- Расчет доверительного интервала

Допустим, у нас есть выборка размером 11, выборочное среднее значение 10 и выборочная дисперсия 2. Для 90%-ной достоверности с 10 степенями свободы одностороннее значение t из таблицы равно 1,372. Тогда с доверительным интервалом, рассчитанным из

мы определяем, что с 90% уверенностью мы имеем истинное среднее значение, лежащее ниже

Другими словами, в 90% случаев, когда верхний порог рассчитывается этим методом на основе конкретных образцов, этот верхний порог превышает истинное среднее значение.

И с 90% уверенностью мы имеем истинное среднее значение, лежащее выше

Другими словами, в 90% случаев, когда нижний порог рассчитывается этим методом на основе конкретных образцов, этот нижний порог лежит ниже истинного среднего значения.

Таким образом, при 80%-ной достоверности (рассчитанной как 100% − 2 × (1 − 90%) = 80%) мы имеем истинное среднее значение, лежащее в интервале

Утверждение, что в 80% случаев, когда верхний и нижний пороги вычисляются этим методом из заданной выборки, истинное среднее значение оказывается как ниже верхнего порога, так и выше нижнего порога, не то же самое, что утверждение, что существует 80%-ная вероятность того, что истинное среднее значение лежит между конкретной парой верхних и нижних порогов, которые были вычислены этим методом; см. доверительный интервал и ошибка прокурора .

В настоящее время статистическое программное обеспечение, такое как язык программирования R , и функции, доступные во многих программах для работы с электронными таблицами, вычисляют значения t- распределения и его обратной функции без таблиц.

Смотрите также

- F -распределение

- Сложенные t и полу t распределения

- Распределение Хотеллинга T²

- Многомерное распределение Стьюдента

- Стандартная нормальная таблица ( таблица Z -распределения)

- т статистика

- Тау-распределение для внутренне стьюдентизированных остатков

- Лямбда-распределение Уилкса

- Распределение Уишарта

- Модифицированное полунормальное распределение [30] с функцией плотности вероятности задается как , где обозначает функцию Фокса–Райта Psi .

Примечания

- ^ Херст, Саймон. "Характерная функция распределения Стьюдента". Отчет по исследованию финансовой математики. Отчет по исследованию статистики № SRR044-95. Архивировано из оригинала 18 февраля 2010 г.

- ^ Нортон, Мэтью; Хохлов, Валентин; Урясев, Стэн (2019). «Расчет CVaR и bPOE для общих распределений вероятностей с применением к оптимизации портфеля и оценке плотности» (PDF) . Annals of Operations Research . 299 (1–2). Springer: 1281–1315. arXiv : 1811.11301 . doi :10.1007/s10479-019-03373-1. S2CID 254231768 . Получено 27.02.2023 .

- ^ Гельмерт ФР (1875). «Über die Berechnung des wahrscheinlichen Fehlers aus einer endlichen Anzahl wahrer Beobachtungsfehler». Zeitschrift für Angewandte Mathematik und Physik (на немецком языке). 20 : 300–303.

- ^ Гельмерт ФР (1876). «Über die Wahrscheinlichkeit der Potenzsummen der Beobachtungsfehler und uber einige damit in Zusammenhang stehende Fragen». Zeitschrift für Angewandte Mathematik und Physik (на немецком языке). 21 : 192–218.

- ^ Гельмерт ФР (1876). «Die Genauigkeit der Formel von Peters zur Berechnung des wahrscheinlichen Beobachtungsfehlers Directer Beobachtungen gleicher Genauigkeit» [Точность формулы Петерса для расчета вероятной ошибки наблюдения прямых наблюдений одинаковой точности]. Astronomische Nachrichten (на немецком языке). 88 (8–9): 113–132. Бибкод : 1876AN.....88..113H. дои : 10.1002/asna.18760880802.

- ^ Люрот Дж (1876). «Vergleichung von zwei Werten des wahrscheinlichen Fehlers». Astronomische Nachrichten (на немецком языке). 87 (14): 209–220. Бибкод : 1876AN.....87..209L. дои : 10.1002/asna.18760871402.

- ^ Pfanzagl J, Sheynin O (1996). «Исследования по истории вероятности и статистики. XLIV. Предшественник распределения t ». Biometrika . 83 (4): 891–898. doi :10.1093/biomet/83.4.891. MR 1766040.

- ^ Шейнин О (1995). «Работы Гельмерта по теории ошибок». Архив журнала «История точных наук» . 49 (1): 73–104. doi :10.1007/BF00374700. S2CID 121241599.

- ^ Пирсон, К. (1895). «Вклад в математическую теорию эволюции. II. Перекос вариации в однородном материале». Philosophical Transactions of the Royal Society A: Mathematical, Physical and Engineering Sciences . 186 (374): 343–414. Bibcode : 1895RSPTA.186..343P. doi : 10.1098/rsta.1895.0010 . ISSN 1364-503X.

- ^ "Студент" [ псевдоним. Уильям Сили Госсет ] (1908). "Вероятная ошибка среднего" (PDF) . Biometrika . 6 (1): 1–25. doi :10.1093/biomet/6.1.1. hdl :10338.dmlcz/143545. JSTOR 2331554.

{{cite journal}}: CS1 maint: numeric names: authors list (link) - ^ Wendl MC (2016). «Псевдонимная слава». Science . 351 (6280): 1406. Bibcode :2016Sci...351.1406W. doi :10.1126/science.351.6280.1406. PMID 27013722.

- ^ Мортимер РГ (2005). Математика для физической химии (3-е изд.). Берлингтон, Массачусетс: Elsevier. стр. 326. ISBN 9780080492889. OCLC 156200058.

- ^ ab Fisher RA (1925). "Применение распределения "Стьюдента"" (PDF) . Metron . 5 : 90–104. Архивировано из оригинала (PDF) 5 марта 2016 г.

- ^ Уолпол RE, Майерс R, Майерс S, Йе K (2006). Вероятность и статистика для инженеров и ученых (7-е изд.). Нью-Дели, Индиана: Pearson. стр. 237. ISBN 9788177584042. OCLC 818811849.

- ^ Крушке, Дж. К. (2015). Выполнение байесовского анализа данных (2-е изд.). Academic Press. ISBN 9780124058880. OCLC 959632184.

- ^ Casella G, Berger RL (1990). Статистический вывод . Центр ресурсов Даксбери. стр. 56. ISBN 9780534119584.

- ^ ab Jackman, S. (2009). Байесовский анализ для социальных наук . Wiley Series in Probability and Statistics. Wiley. стр. 507. doi :10.1002/9780470686621. ISBN 9780470011546.

- ^ Джонсон Н. Л., Коц С., Балакришнан Н. (1995). "Глава 28". Непрерывные одномерные распределения . Том 2 (2-е изд.). Wiley. ISBN 9780471584940.

- ^ Hogg RV , Craig AT (1978). Введение в математическую статистику (4-е изд.). Нью-Йорк: Macmillan. ASIN B010WFO0SA. Разделы 4.4 и 4.8

{{cite book}}: CS1 maint: postscript (link) - ^ Cochran WG (1934). «Распределение квадратичных форм в нормальной системе с приложениями к анализу ковариации». Math. Proc. Camb. Philos. Soc. 30 (2): 178–191. Bibcode :1934PCPS...30..178C. doi :10.1017/S0305004100016595. S2CID 122547084.

- ^ Gelman AB, Carlin JS, Rubin DB, Stern HS (1997). Байесовский анализ данных (2-е изд.). Boca Raton, FL: Chapman & Hal lp 68. ISBN 9780412039911.

- ^ Park SY, Bera AK (2009). "Модель авторегрессии с максимальной энтропией и условной гетероскедастичностью". J. Econom. 150 (2): 219–230. doi :10.1016/j.jeconom.2008.12.014.

- ^ ab Bailey RW (1994). "Полярная генерация случайных величин с распределением t ". Mathematics of Computation . 62 (206): 779–781. Bibcode : 1994MaCom..62..779B. doi : 10.2307/2153537. JSTOR 2153537. S2CID 120459654.

- ^ Ord JK (1972). Семейства частотных распределений . Лондон, Великобритания: Griffin. Таблица 5.1. ISBN 9780852641378.

- ^ Ord JK (1972). Семейства частотных распределений . Лондон, Великобритания: Griffin. Глава 5. ISBN 9780852641378.

- ^ Ланге К. Л., Литтл Р. Дж., Тейлор Дж. М. (1989). «Надежное статистическое моделирование с использованием t-распределения» (PDF) . J. Am. Stat. Assoc. 84 (408): 881–896. doi :10.1080/01621459.1989.10478852. JSTOR 2290063.

- ^ Gelman AB, Carlin JB, Stern HS и др. (2014). «Вычислительно эффективное моделирование цепей Маркова». Байесовский анализ данных . Бока-Ратон, Флорида: CRC Press. стр. 293. ISBN 9781439898208.

- ^ Шах, Амар; Уилсон, Эндрю Гордон; Гахрамани, Зубин (2014). «Процессы Стьюдента t как альтернативы гауссовым процессам» (PDF) . JMLR . 33 (Труды 17-й Международной конференции по искусственному интеллекту и статистике (AISTATS) 2014, Рейкьявик, Исландия): 877–885. arXiv : 1402.4306 .

- ^ Чэнь, Цзэсюнь; Ван, Бо; Горбань, Александр Н. (2019). «Многомерная регрессия гауссовских и t-процессов Стьюдента для многовыходного прогнозирования». Нейронные вычисления и приложения . 32 (8): 3005–3028. arXiv : 1703.04455 . doi : 10.1007/s00521-019-04687-8 .

- ^ Сан, Цзинчао; Конг, Майин; Пал, Субхадип (22 июня 2021 г.). «Модифицированное полунормальное распределение: свойства и эффективная схема выборки». Communications in Statistics - Theory and Methods . 52 (5): 1591–1613. doi :10.1080/03610926.2021.1934700. ISSN 0361-0926. S2CID 237919587.

Ссылки

- Сенн, С.; Ричардсон, В. (1994). «Первый t- тест». Статистика в медицине . 13 (8): 785–803. doi :10.1002/sim.4780130802. PMID 8047737.

- Хогг Р.В. , Крейг А.Т. (1978). Введение в математическую статистику (4-е изд.). Нью-Йорк: Macmillan. ASIN B010WFO0SA.

- Венейблс, В. Н.; Рипли, Б. Д. (2002). Современная прикладная статистика с S (четвертое издание). Springer.

- Гельман, Эндрю; Джон Б. Карлин; Хэл С. Стерн; Дональд Б. Рубин (2003). Байесовский анализ данных (второе издание). CRC/Chapman & Hall. ISBN 1-58488-388-X.

Внешние ссылки

- «Распределение студентов», Энциклопедия математики , EMS Press , 2001 [1994]

- Самые ранние известные случаи использования некоторых слов из математики (S) (Замечания по истории термина «распределение Стьюдента»)

- Руо, М. (2013), Вероятность, статистика и оценка (PDF) (краткое издание)Первые студенты на странице 112.

- Распределение Стьюдента, архив 2021-04-10 на Wayback Machine

![{\displaystyle {\begin{matrix}\ {\frac {\ 1\ }{2}}+x\ \Gamma \left({\frac {\ \nu +1\ }{2}}\right)\times \\[0.5em]{\frac {\ {{}_{2}F_{1}}\!\left(\ {\frac {\ 1\ }{2}},\ {\frac {\ \nu +1\ }{2}};\ {\frac {3}{\ 2\ }};\ -{\frac {~x^{2}\ }{\nu }}\ \right)\ }{\ {\sqrt {\pi \nu }}\ \Gamma \left({\frac {\ \nu \ }{2}}\right)\ }}\ ,\end{matrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/32b4a3af11d075b054f564e60b7aea14bf2a95f3)

![{\displaystyle \ {\begin{matrix}{\frac {\ \nu +1\ }{2}}\left[\ \psi \left({\frac {\ \nu +1\ }{2}}\right)-\psi \left({\frac {\ \nu \ }{2}}\right)\ \right]\\[0.5em]+\ln \left[{\sqrt {\nu \ }}\ {\mathrm {B} }\left(\ {\frac {\ \nu \ }{2}},\ {\frac {\ 1\ }{2}}\ \right)\right]\ {\scriptstyle {\text{(nats)}}}\ \end{matrix}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f248820e946d0f06d1d132fb0d1473d3bed1736c)

![{\displaystyle \ {\frac {\ 1\ }{2}}+{\frac {\ 1\ }{\pi }}\ \left[{\frac {\left(\ {\frac {t}{\ {\sqrt {3\ }}\ }}\ \right)}{\left(\ 1+{\frac {~t^{2}\ }{3}}\ \right)}}+\arctan \left(\ {\frac {t}{\ {\sqrt {3\ }}\ }}\ \right)\ \right]\ }](https://wikimedia.org/api/rest_v1/media/math/render/svg/8354c1a9905eca443735c8edd6f2ff7e30338284)

![{\displaystyle \ {\frac {\ 1\ }{2}}+{\frac {\ 3\ }{8}}\left[\ {\frac {t}{\ {\sqrt {1+{\frac {~t^{2}\ }{4}}~}}\ }}\right]\left[\ 1-{\frac {~t^{2}\ }{\ 12\ \left(\ 1+{\frac {~t^{2}\ }{4}}\ \right)\ }}\ \right]\ }](https://wikimedia.org/api/rest_v1/media/math/render/svg/593d1fbbf85d9c6eca1216081674478751fb9474)

![{\displaystyle \ {\frac {\ 1\ }{2}}+{\frac {\ 1\ }{\pi }}{\left[{\frac {t}{\ {\sqrt {5\ }}\left(1+{\frac {\ t^{2}\ }{5}}\right)\ }}\left(1+{\frac {2}{\ 3\left(1+{\frac {\ t^{2}\ }{5}}\right)\ }}\right)+\arctan \left({\frac {t}{\ {\sqrt {\ 5\ }}\ }}\right)\right]}\ }](https://wikimedia.org/api/rest_v1/media/math/render/svg/e4b4a5988d5b6d89997077e3ef32bda4bdf6ba5e)

![{\displaystyle \ {\frac {\ 1\ }{2}}\ {\left[1+\operatorname {erf} \left({\frac {t}{\ {\sqrt {2\ }}\ }}\right)\right]}\ }](https://wikimedia.org/api/rest_v1/media/math/render/svg/a55ea64b38c1617eea3674d914c315fdb9fab27c)

![{\displaystyle \operatorname {\mathbb {E} } \left\{\ T^{k}\ \right\}={\begin{cases}\quad 0&k{\text{ нечетное }},\quad 0<k<\nu \ ,\\{}\\{\frac {1}{\ {\sqrt {\pi \ }}\ \Gamma \left({\frac {\ \nu \ }{2}}\right)}}\ \left[\ \Gamma \!\left({\frac {\ k+1\ }{2}}\right)\ \Gamma \!\left({\frac {\ \nu -k\ }{2}}\right)\ \nu ^{\frac {\ k\ }{2}}\ \right]&k{\text{ четное }},\quad 0<k<\nu ~.\\\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bede1b3de92cfea26b16817b52f40f76d35d1ceb)

![{\displaystyle {\begin{align}{\bar {x}}&={\frac {\ x_{1}+\cdots +x_{n}\ }{n}}\ ,\\[5pt]s^{2}&={\frac {1}{\ n-1\ }}\ \sum _{i=1}^{n}(x_{i}-{\bar {x}})^{2}~.\end{align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/d888648788b273c89dbb57cb5a936e7824fa31d2)

![{\displaystyle I=[a,b]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6d6214bb3ce7f00e496c0706edd1464ac60b73b5)