Минимаксная оценка

В статистической теории принятия решений , где мы сталкиваемся с проблемой оценки детерминированного параметра (вектора) из наблюдений, оценщик ( правило оценки) называется минимаксным, если его максимальный риск минимален среди всех оценщиков . В некотором смысле это означает, что — оценщик, который работает лучше всего в наихудшем возможном случае, допустимом в задаче.

Настройка проблемы

Рассмотрим задачу оценки детерминированного (не байесовского ) параметра из зашумленных или поврежденных данных , связанных через условное распределение вероятностей . Наша цель — найти «хорошую» оценку для оценки параметра , которая минимизирует некоторую заданную функцию риска . Здесь функция риска (технически функциональная или операторная, поскольку является функцией функции, а НЕ композицией функций) — это ожидание некоторой функции потерь относительно . Популярным примером функции потерь [1] является квадратичная ошибка потерь , а функцией риска для этой потери является средняя квадратичная ошибка (MSE).

К сожалению, в общем случае риск не может быть минимизирован, поскольку он зависит от самого неизвестного параметра (если бы мы знали, каково фактическое значение , нам не нужно было бы его оценивать). Поэтому требуются дополнительные критерии для нахождения оптимальной в некотором смысле оценки. Одним из таких критериев является критерий минимакса.

Определение

Определение : Оценка называется минимаксной по отношению к функции риска , если она достигает наименьшего максимального риска среди всех оценок, то есть она удовлетворяет

Наименее благоприятное распределение

Логически, оценка минимаксна, когда она является лучшей в худшем случае. Продолжая эту логику, оценка минимакса должна быть байесовской оценкой относительно наименее благоприятного априорного распределения . Чтобы продемонстрировать это понятие, обозначим средний риск байесовской оценки относительно априорного распределения как

Определение: Априорное распределение называется наименее благоприятным, если для любого другого распределения средний риск удовлетворяет .

Теорема 1: Если тогда:

- является минимаксом.

- Если — уникальная байесовская оценка, то она также является уникальной минимаксной оценкой.

- наименее благоприятен.

Следствие: Если байесовский оценщик имеет постоянный риск, он минимаксный. Обратите внимание, что это не необходимое условие.

Пример 1: Нечестная монета [2] [3] : Рассмотрим задачу оценки "успешности" биномиальной переменной, . Это можно рассматривать как оценку скорости, с которой нечестная монета падает "орлом" или "решкой". В этом случае байесовский оценщик относительно бета -распределенного априорного распределения имеет вид

с постоянным байесовским риском

и, согласно Следствию, является минимаксным.

Определение: Последовательность априорных распределений называется наименее благоприятной , если для любого другого распределения

Теорема 2: Если существует последовательность априорных вероятностей и оценщик такой, что , то:

- является минимаксом.

- Последовательность наименее благоприятна.

Обратите внимание, что здесь не гарантируется уникальность. Например, оценка ML из предыдущего примера может быть достигнута как предел оценок Байеса относительно равномерного априорного распределения с увеличивающейся поддержкой, а также относительно нормального априорного распределения с нулевым средним с увеличивающейся дисперсией. Таким образом, ни полученная оценка ML не является уникальной минимаксной, ни наименее благоприятная априорная вероятность не является уникальной.

Пример 2: Рассмотрим задачу оценки среднего размерного гауссовского случайного вектора, . Оценка максимального правдоподобия (ML) для в этом случае просто , а ее риск равен

Риск постоянен, но оценщик ML на самом деле не является оценщиком Байеса, поэтому следствие теоремы 1 неприменимо. Однако оценщик ML является пределом оценщиков Байеса относительно априорной последовательности , и, следовательно, действительно минимаксным согласно теореме 2. Тем не менее, минимаксность не всегда подразумевает допустимость . Фактически в этом примере известно, что оценщик ML является недопустимым (недопустимым) всякий раз, когда . Знаменитый оценщик Джеймса–Стейна доминирует над ML всякий раз, когда . Хотя оба оценщика имеют одинаковый риск , когда , и оба они являются минимаксными, оценщик Джеймса–Стейна имеет меньший риск для любого конечного . Этот факт проиллюстрирован на следующем рисунке.

Некоторые примеры

В общем случае, сложно, часто даже невозможно определить минимаксную оценку. Тем не менее, во многих случаях минимаксная оценка была определена.

Пример 3: Ограниченное нормальное среднее: При оценке среднего нормального вектора , где известно, что . Известно, что байесовская оценка относительно априорной вероятности, которая равномерно распределена на краю ограничивающей сферы , является минимаксной, когда . Аналитическое выражение для этой оценки имеет вид

где , — модифицированная функция Бесселя первого рода порядка n .

Асимптотическая минимаксная оценка

Трудность определения точной минимаксной оценки побудила к изучению оценок асимптотического минимакса – оценка называется асимптотическим (или приближенным) минимаксом, если

Для многих задач оценки, особенно в непараметрической установке оценки, были установлены различные приближенные минимаксные оценщики. Конструкция приближенного минимаксного оценщика тесно связана с геометрией, такой как метрическое энтропийное число, .

Рандомизированная минимаксная оценка

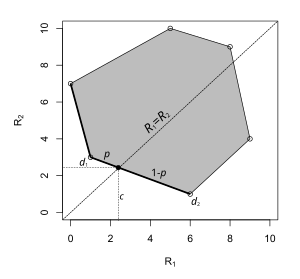

Иногда минимаксная оценка может принимать форму рандомизированного решающего правила . Пример показан слева. Пространство параметров имеет всего два элемента, и каждая точка на графике соответствует риску решающего правила: x-координата является риском, когда параметр равен , а y-координата является риском, когда параметр равен . В этой задаче принятия решения минимаксная оценка лежит на отрезке прямой, соединяющем две детерминированные оценки. Выбор с вероятностью и с вероятностью минимизирует супремум-риск.

Связь с надежной оптимизацией

Надежная оптимизация — это подход к решению задач оптимизации в условиях неопределенности в знании базовых параметров. [4] [5] Например, байесовская оценка параметра MMSE требует знания функции корреляции параметра. Если знание этой функции корреляции не полностью доступно, популярный подход минимаксной надежной оптимизации [6] заключается в определении набора, характеризующего неопределенность относительно функции корреляции, а затем проведении минимаксной оптимизации по набору неопределенности и оценщику соответственно. Аналогичные минимаксные оптимизации могут быть проведены для того, чтобы сделать оценщики надежными к определенным неточно известным параметрам. Например, недавнее исследование, посвященное таким методам в области обработки сигналов, можно найти в. [7]

В работе R. Fandom Noubiap и W. Seidel (2001) был разработан алгоритм вычисления решающего правила Gamma-minimax, когда Gamma задается конечным числом обобщенных моментных условий. Такое решающее правило минимизирует максимум интегралов функции риска относительно всех распределений в Gamma. Решающие правила Gamma-minimax представляют интерес для исследований надежности в байесовской статистике.

Ссылки

- EL Lehmann и G. Casella (1998), Теория точечной оценки, 2-е изд. Нью-Йорк: Springer-Verlag.

- Ф. Перрон и Э. Маршан (2002), «О минимаксной оценке ограниченного нормального среднего», Statistics and Probability Letters 58 : 327–333.

- Р. Фэндом Нубиап и В. Зайдель (2001), «Алгоритм для вычисления правил принятия решений гамма-минимакс при обобщенных моментных условиях», Annals of Statistics , август 2001 г., т. 29, № 4, стр. 1094–1116

- Stein, C. (1981). «Оценка среднего значения многомерного нормального распределения». Annals of Statistics . 9 (6): 1135–1151. doi : 10.1214/aos/1176345632 . MR 0630098. Zbl 0476.62035.

- ^ Бергер, Дж. О. (1985). Статистическая теория принятия решений и байесовский анализ (2-е изд.). Нью-Йорк: Springer-Verlag . С. xv+425. ISBN 0-387-96098-8. МР 0580664.

- ^ Ходжес, младший, Дж. Л.; Леманн, Э. Л. (1950). «Некоторые проблемы минимаксной оценки точек». Ann. Math. Statist . 21 (2): 182–197. doi : 10.1214/aoms/1177729838 . JSTOR 2236900. MR 0035949. Zbl 0038.09802.

- ^ Штайнхаус, Хьюгон (1957). «Проблема оценки». Энн. Математика. Статист . 28 (3): 633–648. дои : 10.1214/aoms/1177706876 . JSTOR 2237224. MR 0092313. Збл 0088.35503.

- ^ SA Kassam и HV Poor (1985), «Надежные методы обработки сигналов: обзор», Труды IEEE , т. 73, стр. 433–481, март 1985 г.

- ^ А. Бен-Тал, Л. Эль Гауи и А. Немировски (2009), «Надежная оптимизация», Princeton University Press, 2009.

- ^ S. Verdu и HV Poor (1984), «О минимаксной надежности: общий подход и приложения», IEEE Transactions on Information Theory , т. 30, стр. 328–340, март 1984 г.

- ^ М. Даниш Нисар. Минимаксная надежность в обработке сигналов для связи, Shaker Verlag, ISBN 978-3-8440-0332-1 , август 2011 г.

![{\displaystyle \pi _{n}\sim U[-n,n]\,\!}](https://wikimedia.org/api/rest_v1/media/math/render/svg/29793e7c3001cca259454e530c2b23a626264fcc)