Многомерное нормальное распределение

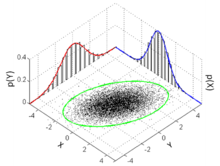

Функция плотности вероятности  Множество точек выборки из многомерного нормального распределения с и , показанные вместе с эллипсом с 3 сигмами, двумя маргинальными распределениями и двумя гистограммами 1-d. | |||

| Обозначение | |||

|---|---|---|---|

| Параметры | µ ∈ R k — местоположение Σ ∈ R k × k — ковариация ( положительная полуопределенная матрица ) | ||

| Поддерживать | x ∈ μ + span( Σ ) ⊆ R k | ||

существует только тогда, когда Σ положительно определена | |||

| Иметь в виду | μ | ||

| Режим | μ | ||

| Дисперсия | Σ | ||

| Энтропия | |||

| МГФ | |||

| CF | |||

| Расхождение Кульбака–Лейблера | См. § Расхождение Кульбака–Лейблера | ||

В теории вероятностей и статистике многомерное нормальное распределение , многомерное гауссовское распределение или совместное нормальное распределение является обобщением одномерного ( одномерного ) нормального распределения на более высокие измерения . Одно из определений состоит в том, что случайный вектор называется k -мерным нормально распределенным, если каждая линейная комбинация его k компонентов имеет одномерное нормальное распределение. Его важность вытекает в основном из многомерной центральной предельной теоремы . Многомерное нормальное распределение часто используется для описания, по крайней мере приблизительно, любого набора (возможно) коррелированных действительных случайных величин , каждая из которых группируется вокруг среднего значения.

Определения

Обозначение и параметризация

Многомерное нормальное распределение k -мерного случайного вектора можно записать в следующей записи:

или явно указать, что X является k -мерным,

с k -мерным средним вектором

такая, что и . Обратная матрица ковариации называется матрицей точности и обозначается .

Стандартный нормальный случайный вектор

Действительный случайный вектор называется стандартным нормальным случайным вектором, если все его компоненты независимы и каждый из них является нормально распределенной случайной величиной с нулевым средним и единичной дисперсией, т.е. если для всех . [1] : стр. 454

Центрированный нормальный случайный вектор

Действительный случайный вектор называется центрированным нормальным случайным вектором, если существует матрица, имеющая такое же распределение, как и , где — стандартный нормальный случайный вектор с компонентами. [1] : стр. 454

Нормальный случайный вектор

Действительный случайный вектор называется нормальным случайным вектором , если существует случайный -вектор , который является стандартным нормальным случайным вектором, -вектор и матрица , такие, что . [2] : стр. 454 [1] : стр. 455

Формально:

Здесь ковариационная матрица равна .

В вырожденном случае, когда ковариационная матрица является сингулярной , соответствующее распределение не имеет плотности; подробности см. в разделе ниже. Этот случай часто возникает в статистике ; например, в распределении вектора остатков в обычной регрессии наименьших квадратов . В общем случае они не являются независимыми; их можно рассматривать как результат применения матрицы к набору независимых гауссовских переменных .

Эквивалентные определения

Следующие определения эквивалентны определению, данному выше. Случайный вектор имеет многомерное нормальное распределение, если он удовлетворяет одному из следующих эквивалентных условий.

- Каждая линейная комбинация ее компонентов распределена нормально . То есть, для любого постоянного вектора случайная величина имеет одномерное нормальное распределение, где одномерное нормальное распределение с нулевой дисперсией представляет собой точечную массу на своем среднем значении.

- Существует k -вектор и симметричная, положительно полуопределенная матрица , такая, что характеристическая функция имеет вид

Сферическое нормальное распределение можно охарактеризовать как уникальное распределение, компоненты которого независимы в любой ортогональной системе координат. [3] [4]

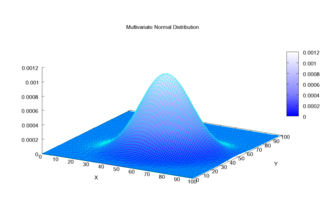

Функция плотности

Невырожденный случай

Многомерное нормальное распределение называется «невырожденным», когда симметричная ковариационная матрица положительно определена . В этом случае распределение имеет плотность [5]

где — действительный k -мерный вектор-столбец, а — определитель , также известный как обобщенная дисперсия . Уравнение выше сводится к уравнению одномерного нормального распределения, если — матрица (т. е. одно действительное число).

Кругово-симметричная версия комплексного нормального распределения имеет несколько иную форму.

Каждое изоплотностное распределение — множество точек в k -мерном пространстве, каждая из которых дает одно и то же значение плотности — представляет собой эллипс или его обобщение в более высокой размерности; следовательно, многомерное нормальное распределение является частным случаем эллиптических распределений .

Величина известна как расстояние Махаланобиса , которое представляет собой расстояние контрольной точки от среднего значения . Квадрат расстояния Махаланобиса разлагается на сумму k членов, каждый из которых является произведением трех значимых компонентов. [6] Обратите внимание, что в случае, когда , распределение сводится к одномерному нормальному распределению, а расстояние Махаланобиса сводится к абсолютному значению стандартной оценки . См. также Интервал ниже.

Двумерный случай

В двумерном несингулярном случае ( ) функция плотности вероятности вектора имеет вид: где — корреляция между и и где и . В этом случае

В двумерном случае первое эквивалентное условие для многомерной реконструкции нормальности можно сделать менее ограничительным, поскольку достаточно проверить, что счетное бесконечное множество различных линейных комбинаций и являются нормальными, чтобы сделать вывод о том, что вектор является двумерным нормальным. [7]

Двумерные изоплотностные локусы, построенные на плоскости , представляют собой эллипсы , главные оси которых определяются собственными векторами ковариационной матрицы (большой и малый полудиаметры эллипса равны квадратному корню из упорядоченных собственных значений).

По мере увеличения абсолютного значения параметра корреляции эти локусы сжимаются к следующей линии:

Это происходит потому, что это выражение, с (где sgn — знаковая функция ), замененное на , является наилучшим линейным несмещенным прогнозом для заданного значения . [8]

Вырожденный случай

Если ковариационная матрица не имеет полного ранга, то многомерное нормальное распределение вырождено и не имеет плотности. Точнее, оно не имеет плотности относительно k -мерной меры Лебега (которая является обычной мерой, предполагаемой в курсах по теории вероятностей на уровне исчисления). Только случайные векторы, распределения которых абсолютно непрерывны относительно меры, считаются имеющими плотность (относительно этой меры). Чтобы говорить о плотностях, но при этом избегать сложностей теории меры, может быть проще ограничить внимание подмножеством координат таким образом, что ковариационная матрица для этого подмножества является положительно определенной; тогда другие координаты можно рассматривать как аффинную функцию этих выбранных координат. [9]

Чтобы осмысленно говорить о плотностях в особых случаях, мы должны выбрать другую базовую меру. Используя теорему о распаде, мы можем определить ограничение меры Лебега на -мерное аффинное подпространство, где поддерживается гауссовское распределение, т.е. . Относительно этой меры распределение имеет плотность следующего мотива:

где — обобщенная обратная матрица , а — псевдодетерминант . [10]

Кумулятивная функция распределения

Понятие кумулятивной функции распределения (cdf) в размерности 1 можно расширить двумя способами на многомерный случай, основываясь на прямоугольных и эллипсоидальных областях.

Первый способ — определить функцию распределения случайного вектора как вероятность того, что все компоненты меньше или равны соответствующим значениям в векторе : [11]

Хотя для не существует замкнутой формы , существует ряд алгоритмов, которые оценивают ее численно. [11] [12]

Другой способ — определить cdf как вероятность того, что образец находится внутри эллипсоида, определяемого его расстоянием Махаланобиса от гауссовой функции, что является прямым обобщением стандартного отклонения. [13] Для вычисления значений этой функции существует замкнутая аналитическая формула [13] следующим образом.

Интервал

Интервал для многомерного нормального распределения дает область, состоящую из тех векторов x , которые удовлетворяют

Здесь — вектор размерности, — известный вектор размерности, — известная ковариационная матрица , — квантильная функция для вероятности распределения хи-квадрат со степенями свободы. [14] Когда выражение определяет внутреннюю часть эллипса, а распределение хи-квадрат упрощается до экспоненциального распределения со средним значением, равным двум (скорость равна половине).

Дополнительная кумулятивная функция распределения (хвостовое распределение)

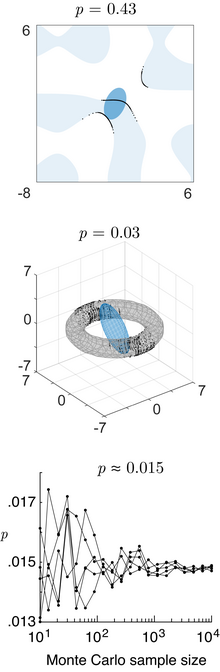

Дополнительная кумулятивная функция распределения (ccdf) или хвостовое распределение определяется как . Когда , то ccdf можно записать как вероятность максимума зависимых гауссовых переменных: [15]

Хотя не существует простой замкнутой формулы для вычисления ccdf, максимум зависимых гауссовых переменных можно точно оценить с помощью метода Монте-Карло . [15] [16]

Характеристики

Вероятность в различных областях

Вероятностное содержание многомерной нормальной функции в квадратичной области, определяемой как (где — матрица, — вектор, а — скаляр), которое имеет отношение к байесовской теории классификации/принятия решений с использованием гауссовского дискриминантного анализа, задается обобщенным распределением хи-квадрат . [17] Вероятностное содержание в любой общей области, определяемой как (где — общая функция), можно вычислить с помощью численного метода трассировки лучей [17] (код Matlab).

Высшие моменты

Моменты k - го порядка x определяются как

где r 1 + r 2 + ⋯ + r N = k .

Центральные моменты k -го порядка следующие:

- Если k нечетно, μ 1, ..., N ( x − μ ) = 0 .

- Если k четное с k = 2 λ , то [ неоднозначно ]

где сумма берется по всем распределениям набора в λ (неупорядоченные) пары. То есть, для k -го (= 2 λ = 6) центрального момента, суммируются произведения λ = 3 ковариаций (ожидаемое значение μ принимается равным 0 в интересах экономии):

Это дает члены в сумме (15 в приведенном выше случае), каждый из которых является произведением λ (в данном случае 3) ковариаций. Для моментов четвертого порядка (четыре переменные) есть три члена. Для моментов шестого порядка есть 3 × 5 = 15 членов, а для моментов восьмого порядка есть 3 × 5 × 7 = 105 членов.

Затем ковариации определяются путем замены членов списка соответствующими членами списка, состоящего из r 1 единиц, затем r 2 двоек и т. д. Чтобы проиллюстрировать это, рассмотрим следующий случай центрального момента 4-го порядка:

где — ковариация X i и X j . С помощью вышеописанного метода сначала находят общий случай для k -го момента с k различными переменными X , , а затем упрощают его соответствующим образом. Например, для , полагают X i = X j и используют тот факт, что .

Функции нормального вектора

Квадратичная форма нормального вектора ( где — матрица, — вектор, а — скаляр), является обобщенной переменной хи-квадрат . [17] Направление нормального вектора следует за спроецированным нормальным распределением . [18]

Если — общая скалярная функция нормального вектора, то ее функция плотности вероятности , кумулятивная функция распределения и обратная кумулятивная функция распределения могут быть вычислены с помощью численного метода трассировки лучей (код Matlab). [17]

Функция правдоподобия

Если известны среднее значение и ковариационная матрица, то логарифм правдоподобия наблюдаемого вектора — это просто логарифм функции плотности вероятности :

- ,

Круговая симметричная версия нецентрального комплексного случая, где — вектор комплексных чисел, будет иметь вид

т.е. с сопряженной транспозицией (обозначенной ) заменяющей обычную транспозицию (обозначенную ). Это немного отличается от реального случая, поскольку круговая симметричная версия комплексного нормального распределения имеет немного иную форму для константы нормализации .

Аналогичное обозначение используется для множественной линейной регрессии . [19]

Поскольку логарифм правдоподобия нормального вектора является квадратичной формой нормального вектора, он распределяется как обобщенная переменная хи-квадрат . [17]

Дифференциальная энтропия

Дифференциальная энтропия многомерного нормального распределения равна [20]

,

где черточки обозначают определитель матрицы , k — размерность векторного пространства, а результат имеет единицы измерения nats .

Расхождение Кульбака–Лейблера

Расхождение Кульбака –Лейблера от до для невырожденных матриц Σ 1 и Σ 0 равно: [21]

где обозначает определитель матрицы , — след , — натуральный логарифм , — размерность векторного пространства.

Логарифм должен быть взят по основанию e, поскольку два члена, следующие за логарифмом, сами являются логарифмами по основанию e выражений, которые являются либо факторами функции плотности, либо иным образом возникают естественным образом. Таким образом, уравнение дает результат, измеряемый в nats . Деление всего выражения выше на log e 2 дает расхождение в bits .

Когда ,

Взаимная информация

Взаимная информация двух многомерных нормальных распределений является частным случаем расхождения Кульбака–Лейблера , в котором есть полное размерное многомерное распределение и есть произведение и размерных маргинальных распределений и , таких что . Взаимная информация между и определяется как: [22]

где

Если — произведение одномерных нормальных распределений, то в обозначениях раздела «Расхождение Кульбака–Лейблера» этой статьи — диагональная матрица с диагональными элементами , и . Результирующая формула для взаимной информации:

где — корреляционная матрица, построенная из . [23]

В двумерном случае выражение для взаимной информации имеет вид:

Норма суставов

Нормально распределенные и независимые

Если и нормально распределены и независимы , это означает, что они «совместно нормально распределены», т. е. пара должна иметь многомерное нормальное распределение. Однако пара совместно нормально распределенных переменных не обязательно должна быть независимой (будет таковой только в случае некоррелированности, ).

Две нормально распределенные случайные величины не обязательно должны быть совместно двумерными нормальными

Тот факт, что две случайные величины и обе имеют нормальное распределение, не означает, что пара имеет совместное нормальное распределение. Простым примером является случай, когда X имеет нормальное распределение с ожидаемым значением 0 и дисперсией 1, и если и если , где . Существуют аналогичные контрпримеры для более чем двух случайных величин. В общем случае они суммируются в модель смеси . [ необходима цитата ]

Корреляции и независимость

В общем, случайные величины могут быть некоррелированными, но статистически зависимыми. Но если случайный вектор имеет многомерное нормальное распределение, то любые два или более его компонентов, которые некоррелированы, являются независимыми . Это подразумевает, что любые два или более его компонентов, которые попарно независимы, являются независимыми. Но, как было указано выше, неверно, что две случайные величины, которые ( отдельно , маргинально) нормально распределены и некоррелированы, являются независимыми.

Условные распределения

Если N -мерный x разбить следующим образом

и соответственно μ и Σ разбиваются следующим образом

тогда распределение x 1 условное на x 2 = a является многомерным нормальным [24] ( x 1 | x 2 = a ) ~ N ( μ , Σ ) где

и ковариационная матрица

- [25]

Вот обобщенная обратная матрица . Матрица является дополнением Шура Σ 22 в Σ . То есть, уравнение выше эквивалентно инвертированию общей ковариационной матрицы, отбрасыванию строк и столбцов, соответствующих переменным, на которые накладываются условия, и обратному инвертированию для получения условной ковариационной матрицы .

Обратите внимание, что знание того, что x 2 = a, изменяет дисперсию, хотя новая дисперсия не зависит от конкретного значения a ; возможно, что еще более удивительно, среднее значение смещается на ; сравните это с ситуацией, когда значение a неизвестно , в этом случае x 1 имело бы распределение .

Интересный факт, полученный для доказательства этого результата, заключается в том, что случайные векторы и независимы.

Матрица Σ 12 Σ 22 −1 известна как матрица коэффициентов регрессии .

Двумерный случай

В двумерном случае, когда x разбивается на и , условное распределение заданного имеет вид [26]

где — коэффициент корреляции между и .

Двумерное условное ожидание

В общем случае

Условное ожидание X 1 при условии X 2 равно:

Доказательство: результат получается путем взятия математического ожидания условного распределения, указанного выше.

В центрированном случае с единичными дисперсиями

Условное ожидание X 1 при условии X 2 равно

и условная дисперсия равна

таким образом, условная дисперсия не зависит от x 2 .

Условное ожидание X 1 при условии, что X 2 меньше/больше z , равно: [27] : 367

где конечное отношение здесь называется обратным отношением Миллса .

Доказательство: последние два результата получены с использованием результата , так что

- а затем используя свойства ожидания усеченного нормального распределения .

Предельные распределения

Чтобы получить маргинальное распределение по подмножеству многомерных нормальных случайных величин, нужно только отбросить нерелевантные переменные (переменные, которые нужно маргинализировать) из среднего вектора и ковариационной матрицы. Доказательство этого следует из определений многомерных нормальных распределений и линейной алгебры. [28]

Пример

Пусть X = [ X 1 , X 2 , X 3 ] — многомерные нормальные случайные величины со средним вектором μ = [ μ 1 , μ 2 , μ 3 ] и ковариационной матрицей Σ (стандартная параметризация для многомерных нормальных распределений). Тогда совместное распределение X ′ = [ X 1 , X 3 ] является многомерным нормальным со средним вектором μ ′ = [ μ 1 , μ 3 ] и ковариационной матрицей .

Аффинное преобразование

Если Y = c + BX — аффинное преобразование , где c — вектор констант, а B — константная матрица, то Y имеет многомерное нормальное распределение с ожидаемым значением c + Bμ и дисперсией BΣB T т. е . . В частности, любое подмножество X i имеет маргинальное распределение, которое также является многомерным нормальным. Чтобы увидеть это, рассмотрим следующий пример: чтобы извлечь подмножество ( X 1 , X 2 , X 4 ) T , используйте

который извлекает нужные элементы напрямую.

Другим следствием является то, что распределение Z = b · X , где b — постоянный вектор с тем же числом элементов, что и X , а точка обозначает скалярное произведение , является одномерным гауссовым с . Этот результат следует из использования

Обратите внимание, что положительная определенность Σ подразумевает, что дисперсия скалярного произведения должна быть положительной.

Аффинное преобразование X , такое как 2 X, не является суммой двух независимых реализаций X.

Геометрическая интерпретация

Контуры равной плотности невырожденного многомерного нормального распределения представляют собой эллипсоиды (т.е. аффинные преобразования гиперсфер ), центрированные в среднем. [29] Следовательно, многомерное нормальное распределение является примером класса эллиптических распределений . Направления главных осей эллипсоидов задаются собственными векторами ковариационной матрицы . Квадраты относительных длин главных осей задаются соответствующими собственными значениями.

Если Σ = UΛU T = UΛ 1/2 ( UΛ 1/2 ) T — собственное разложение , где столбцы U — единичные собственные векторы, а Λ — диагональная матрица собственных значений, то мы имеем

Более того, U можно выбрать в качестве матрицы поворота , поскольку инвертирование оси не оказывает никакого влияния на N (0, Λ ), но инвертирование столбца изменяет знак определителя U. Распределение N ( μ , Σ ) по сути является N (0, I ), масштабированным на Λ 1/2 , повернутым на U и смещенным на μ .

Наоборот, любой выбор μ , матрицы полного ранга U и положительных диагональных элементов Λ i дает невырожденное многомерное нормальное распределение. Если любое Λ i равно нулю, а U является квадратным, результирующая ковариационная матрица UΛU T является вырожденной . Геометрически это означает, что каждый контурный эллипсоид бесконечно тонок и имеет нулевой объем в n -мерном пространстве, так как по крайней мере одна из главных осей имеет длину, равную нулю; это вырожденный случай .

«Радиус вокруг истинного среднего значения в двумерной нормальной случайной величине, записанный в полярных координатах (радиус и угол), следует распределению Хойта ». [30]

В одном измерении вероятность нахождения образца нормального распределения в интервале составляет приблизительно 68,27%, но в более высоких измерениях вероятность нахождения образца в области эллипса стандартного отклонения ниже. [31]

| Размерность | Вероятность |

|---|---|

| 1 | 0,6827 |

| 2 | 0,3935 |

| 3 | 0.1987 |

| 4 | 0,0902 |

| 5 | 0,0374 |

| 6 | 0,0144 |

| 7 | 0,0052 |

| 8 | 0,0018 |

| 9 | 0,0006 |

| 10 | 0,0002 |

Статистический вывод

Оценка параметров

Вывод оценки максимального правдоподобия ковариационной матрицы многомерного нормального распределения прост.

Короче говоря, функция плотности вероятности (pdf) многомерного нормального распределения равна

и оценка ML матрицы ковариации из выборки из n наблюдений равна [32]

которая является просто выборочной ковариационной матрицей . Это смещенная оценка, чье ожидание равно

Несмещенная выборочная ковариация — это

- (матричная форма; — единичная матрица, J — матрица из единиц; член в скобках, таким образом, является центрирующей матрицей)

Матрица информации Фишера для оценки параметров многомерного нормального распределения имеет выражение замкнутой формы. Это может быть использовано, например, для вычисления границы Крамера–Рао для оценки параметров в этой настройке. См. информацию Фишера для получения более подробной информации.

Байесовский вывод

В байесовской статистике сопряженное априорное распределение среднего вектора является другим многомерным нормальным распределением, а сопряженное априорное распределение ковариационной матрицы является обратным распределением Уишарта . Предположим, что было сделано n наблюдений

и что была назначена сопряженная априорная величина, где

где

и

Тогда [32]

где

Многомерные тесты нормальности

Многомерные тесты нормальности проверяют заданный набор данных на сходство с многомерным нормальным распределением . Нулевая гипотеза заключается в том, что набор данных похож на нормальное распределение, поэтому достаточно малое значение p указывает на ненормальные данные. Многомерные тесты нормальности включают тест Кокса–Смолла [33] и адаптацию Смита и Джейна [34] теста Фридмана–Рафски, созданную Ларри Рафски и Джеромом Фридманом . [35]

Тест Мардиа [36] основан на многомерных расширениях мер асимметрии и эксцесса . Для выборки { x 1 , ..., x n } k -мерных векторов мы вычисляем

При нулевой гипотезе многомерной нормальности статистика A будет иметь приблизительно распределение хи-квадрат с 1/6 ⋅ k ( k + 1)( k + 2) степеней свободы, а B будет приблизительно стандартным нормальным N (0,1).

Статистика эксцесса Мардиа искажена и очень медленно сходится к предельному нормальному распределению. Для выборок среднего размера параметры асимптотического распределения статистики эксцесса изменяются [37] . Для тестов на малых выборках ( ) используются эмпирические критические значения. Таблицы критических значений для обеих статистик приведены Ренчером [38] для k = 2, 3, 4.

Тесты Мардиа являются аффинно-инвариантными, но не последовательными. Например, тест многомерной асимметрии не последовательны против симметричных ненормальных альтернатив. [39]

Тест BHEP [40] вычисляет норму разности между эмпирической характеристической функцией и теоретической характеристической функцией нормального распределения. Расчет нормы выполняется в пространстве L 2 ( μ ) квадратично-интегрируемых функций относительно гауссовой весовой функции . Тестовая статистика:

Предельное распределение этой тестовой статистики представляет собой взвешенную сумму случайных величин хи-квадрат. [40]

Подробный обзор этих и других процедур испытаний доступен. [41]

Классификация по многомерным нормальным классам

Гауссовский дискриминантный анализ

Предположим, что наблюдения (которые являются векторами) предположительно происходят из одного из нескольких многомерных нормальных распределений с известными средними и ковариациями. Тогда любое данное наблюдение может быть отнесено к распределению, из которого оно имеет наибольшую вероятность возникновения. Эта процедура классификации называется гауссовым дискриминантным анализом. Эффективность классификации, т. е. вероятности различных результатов классификации и общая ошибка классификации, могут быть вычислены с помощью численного метода трассировки лучей [17] (код Matlab).

Методы расчета

Извлечение значений из распределения

Широко используемый метод получения (выборки) случайного вектора x из N -мерного многомерного нормального распределения со средним вектором μ и ковариационной матрицей Σ работает следующим образом: [42]

- Найдите любую вещественную матрицу A такую, что AA T = Σ . Когда Σ положительно определена, обычно используется разложение Холецкого , и расширенная форма этого разложения всегда может быть использована (так как ковариационная матрица может быть только положительно полуопределенной) в обоих случаях получается подходящая матрица A. Альтернативой является использование матрицы A = UΛ 1/2 , полученной из спектрального разложения Σ = UΛU −1 матрицы Σ . Первый подход более прост в вычислительном отношении, но матрицы A изменяются для различных порядков элементов случайного вектора, в то время как последний подход дает матрицы, которые связаны простыми переупорядочениями. Теоретически оба подхода дают одинаково хорошие способы определения подходящей матрицы A , но есть различия во времени вычислений.

- Пусть z = ( z 1 , ..., z N ) T — вектор, компонентами которого являются N независимых стандартных нормальных величин (которые можно сгенерировать, например, с помощью преобразования Бокса–Мюллера ).

- Пусть x будет μ + Az . Это имеет желаемое распределение благодаря свойству аффинного преобразования.

Смотрите также

- Хи-распределение , плотность вероятности 2-нормы ( евклидовой нормы или длины вектора ) многомерного нормально распределенного вектора (некоррелированного и с нулевым центром).

- Распределение Рэлея , плотность вероятности длины вектора двумерного нормально распределенного вектора (некоррелированного и с нулевым центром)

- Распределение Райса , функция плотности вероятности длины вектора двумерного нормально распределенного вектора (некоррелированного и нецентрированного)

- Распределение Хойта , функция плотности вероятности длины вектора двумерного нормально распределенного вектора (коррелированного и центрированного)

- Сложное нормальное распределение , применение двумерного нормального распределения

- Копула , для определения гауссовой или нормальной модели копулы.

- Многомерное t-распределение , которое является еще одним широко используемым сферически симметричным многомерным распределением.

- Расширение многомерного устойчивого распределения многомерного нормального распределения, когда индекс (показатель степени в характеристической функции) находится в диапазоне от нуля до двух.

- Расстояние Махаланобиса

- Распределение Уишарта

- Нормальное распределение матрицы

Ссылки

- ^ abc Lapidoth, Amos (2009). Основы цифровой коммуникации . Cambridge University Press. ISBN 978-0-521-19395-5.

- ^ Гут, Аллан (2009). Промежуточный курс теории вероятностей . Springer. ISBN 978-1-441-90161-3.

- ^ Кац, М. (1939). «О характеристике нормального распределения». American Journal of Mathematics . 61 (3): 726– 728. doi :10.2307/2371328. JSTOR 2371328.

- ^ Синц, Фабиан; Гервинн, Себастьян; Бетге, Маттиас (2009). «Характеристика p-обобщенного нормального распределения». Журнал многомерного анализа . 100 (5): 817– 820. doi : 10.1016/j.jmva.2008.07.006 .

- ^ Саймон Дж. Д. Принс (июнь 2012 г.). Компьютерное зрение: модели, обучение и вывод. Архивировано 28 октября 2020 г. в Wayback Machine . Cambridge University Press. 3.7: «Многомерное нормальное распределение».

- ^ Ким, М. Г. (2000). «Многомерные выбросы и разложения расстояния Махаланобиса». Communications in Statistics – Theory and Methods . 29 (7): 1511– 1526. doi :10.1080/03610920008832559.

- ^ Хамедани, ГГ; Тата, МН (1975). «Определение двумерного нормального распределения из распределений линейных комбинаций переменных». The American Mathematical Monthly . 82 (9): 913– 915. doi :10.2307/2318494. JSTOR 2318494.

- ^ Wyatt, John (26 ноября 2008 г.). "Linear least-squared error estimate" (PDF) . Конспект лекций по прикладной вероятности . Архивировано из оригинала (PDF) 10 октября 2015 г. . Получено 23 января 2012 г. .

- ^ "линейная алгебра - Отображение между аффинными координатными функциями". Mathematics Stack Exchange . Получено 2022-06-24 .

- ^ Рао, CR (1973). Линейный статистический вывод и его применение . Нью-Йорк: Wiley. С. 527–528 . ISBN 0-471-70823-2.

- ^ ab Botev, ZI (2016). «Нормальный закон при линейных ограничениях: моделирование и оценка с помощью минимаксного наклона». Журнал Королевского статистического общества, серия B. 79 : 125–148 . arXiv : 1603.04166 . Bibcode : 2016arXiv160304166B. doi : 10.1111/rssb.12162. S2CID 88515228.

- ^ Генц, Алан (2009). Вычисление многомерных нормальных и t-вероятностей. Springer. ISBN 978-3-642-01689-9.

- ^ ab Bensimhoun Michael, N-мерная кумулятивная функция и другие полезные факты о гауссианах и нормальных плотностях (2006)

- ^ Сиотани, Минору (1964). "Области толерантности для многомерной нормальной популяции" (PDF) . Анналы Института статистической математики . 16 (1): 135– 153. doi :10.1007/BF02868568. S2CID 123269490.

- ^ ab Botev, ZI; Mandjes, M.; Ridder, A. (6–9 декабря 2015 г.). «Распределение хвоста максимума коррелированных гауссовских случайных величин». Зимняя конференция по моделированию 2015 г. (WSC) . Хантингтон-Бич, Калифорния, США: IEEE. стр. 633–642 . doi :10.1109/WSC.2015.7408202. hdl : 10419/130486 . ISBN 978-1-4673-9743-8.

- ^ Adler, RJ; Blanchet, J.; Liu, J. (7–10 декабря 2008 г.). «Эффективное моделирование для хвостовых вероятностей гауссовских случайных полей». Зимняя конференция по моделированию 2008 г. (WSC) . Майами, Флорида, США: IEEE. стр. 328–336 . doi :10.1109/WSC.2008.4736085. ISBN 978-1-4244-2707-9.

{{cite conference}}: CS1 maint: date and year (link) - ^ abcdefghi Das, Abhranil; Wilson S Geisler (2020). «Методы интеграции мультинормалей и вычисления мер классификации». arXiv : 2012.14331 [stat.ML].

- ^ Эрнандес-Штумпфхаузер, Дэниел; Брейдт, Ф. Джей; ван дер Вурд, Марк Дж. (2017). «Общее проектируемое нормальное распределение произвольной размерности: моделирование и байесовский вывод». Байесовский анализ . 12 (1): 113– 133. doi : 10.1214/15-BA989 .

- ^ Тонг, Т. (2010) Множественная линейная регрессия: MLE и ее результаты распределения Архивировано 16.06.2013 в WebCite , Lecture Notes

- ^ Gokhale, DV; Ahmed, NA; Res, BC; Piscataway, NJ (май 1989). «Выражения энтропии и их оценки для многомерных распределений». IEEE Transactions on Information Theory . 35 (3): 688– 692. doi :10.1109/18.30996.

- ^ Дучи, Дж. «Выводы для линейной алгебры и оптимизации» (PDF) : 13.

{{cite journal}}: Цитировать журнал требует|journal=( помощь ) - ^ Доказательство: Взаимная информация многомерного нормального распределения

- ^ MacKay, David JC (2003-10-06). Теория информации, вывод и алгоритмы обучения (Иллюстрированное издание). Кембридж: Cambridge University Press. ISBN 978-0-521-64298-9.

- ^ Холт, В.; Нгуен, Д. (2023). «Основные аспекты байесовского импутирования данных». SSRN 4494314.

{{cite journal}}: Цитировать журнал требует|journal=( помощь ) - ^ Итон, Моррис Л. (1983). Многомерная статистика: подход векторного пространства . John Wiley and Sons. стр. 116–117 . ISBN 978-0-471-02776-8.

- ^ Йенсен, Дж. (2000). Статистика для инженеров-нефтяников и геологов . Амстердам: Elsevier. С. 207. ISBN 0-444-50552-0.

- ^ Маддала, Г. С. (1983). Ограниченные зависимые и качественные переменные в эконометрике . Cambridge University Press. ISBN 0-521-33825-5.

- ^ Алгебраическое вычисление маргинального распределения показано здесь http://fourier.eng.hmc.edu/e161/lectures/gaussianprocess/node7.html Архивировано 2010-01-17 на Wayback Machine . Гораздо более короткое доказательство изложено здесь https://math.stackexchange.com/a/3832137

- ^ Николаус Хансен (2016). "Стратегия эволюции CMA: Учебное пособие" (PDF) . arXiv : 1604.00772 . Bibcode :2016arXiv160400772H. Архивировано из оригинала (PDF) 2010-03-31 . Получено 2012-01-07 .

- ^ Дэниел Воллшлегер. «Распределение Хойта (документация для пакета R 'shotGroups' версии 0.6.2)».[ постоянная мертвая ссылка ]

- ^ Ван, Бин; Ши, Вэньчжун; Мяо, Зеланг (13.03.2015). Роккини, Дуччио (ред.). «Анализ достоверности эллипса стандартного отклонения и его расширения в многомерное евклидово пространство». PLOS ONE . 10 (3): e0118537. Bibcode : 2015PLoSO..1018537W. doi : 10.1371/journal.pone.0118537 . ISSN 1932-6203. PMC 4358977. PMID 25769048 .

- ^ ab Holt, W.; Nguyen, D. (2023). «Введение в байесовскую импутацию данных». SSRN 4494314.

{{cite journal}}: Цитировать журнал требует|journal=( помощь ) - ^ Кокс, DR; Смолл, NJH (1978). «Проверка многомерной нормальности». Biometrika . 65 (2): 263. doi :10.1093/biomet/65.2.263.

- ^ Смит, С. П.; Джейн, А. К. (1988). «Тест для определения многомерной нормальности набора данных». Труды IEEE по анализу шаблонов и машинному интеллекту . 10 (5): 757. doi :10.1109/34.6789.

- ^ Фридман, Дж. Х.; Рафски, Л. К. (1979). «Многомерные обобщения двухвыборочных тестов Вальда–Вольфовица и Смирнова». Анналы статистики . 7 (4): 697. doi : 10.1214/aos/1176344722 .

- ^ Мардиа, К. В. (1970). «Меры многомерной асимметрии и эксцесса с приложениями». Biometrika . 57 (3): 519– 530. doi :10.1093/biomet/57.3.519.

- ↑ Ренчер (1995), страницы 112–113.

- ↑ Ренчер (1995), страницы 493–495.

- ^ Baringhaus, L.; Henze, N. (1991). «Предельные распределения для мер многомерной асимметрии и эксцесса на основе проекций». Журнал многомерного анализа . 38 : 51– 69. doi : 10.1016/0047-259X(91)90031-V .

- ^ ab Baringhaus, L.; Henze, N. (1988). "Последовательный тест на многомерную нормальность на основе эмпирической характеристической функции". Metrika . 35 (1): 339– 348. doi :10.1007/BF02613322. S2CID 122362448.

- ^ Хенце, Норберт (2002). «Инвариантные тесты для многомерной нормальности: критический обзор». Статистические статьи . 43 (4): 467– 506. doi :10.1007/s00362-002-0119-6. S2CID 122934510.

- ^ Gentle, JE (2009). Вычислительная статистика. Статистика и вычисления. Нью-Йорк: Springer. С. 315–316 . doi :10.1007/978-0-387-98144-4. ISBN 978-0-387-98143-7.

Литература

- Ренчер, А.С. (1995). Методы многомерного анализа . Нью-Йорк: Wiley.

- Тонг, Й. Л. (1990). Многомерное нормальное распределение . Springer Series in Statistics. Нью-Йорк: Springer-Verlag. doi :10.1007/978-1-4613-9655-0. ISBN 978-1-4613-9657-4. S2CID 120348131.

![{\displaystyle {\boldsymbol {\mu }}=\left[{\begin{smallmatrix}0\\0\end{smallmatrix}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/288f20c89fee827ad086cec03369439ba3615d7f)

![{\displaystyle {\boldsymbol {\Sigma }}=\left[{\begin{smallmatrix}1&3/5\\3/5&2\end{smallmatrix}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ee3a76f734b37fcce91f30617152fe104b2782bc)

![{\displaystyle {\boldsymbol {\mu }}=\operatorname {E} [\mathbf {X} ]=(\operatorname {E} [X_{1}],\operatorname {E} [X_{2}],\ldots ,\operatorname {E} [X_{k}])^{\mathrm {T} },}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a0ff77227bef5ec255a816fbb1a31d5c1e0fba21)

![{\displaystyle \Sigma _{i,j}=\operatorname {E} [(X_{i}-\mu _{i})(X_{j}-\mu _{j})]=\operatorname {Cov } [X_{i},X_{j}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c970083f8469366521881996464f23d376b7c40b)

![{\displaystyle {\text{[XY]}}\prime }](https://wikimedia.org/api/rest_v1/media/math/render/svg/faffc663dc20d1db9845a496c725e6b07029f263)

![{\displaystyle f(x,y)={\frac {1}{2\pi \sigma _{X}\sigma _{Y}{\sqrt {1-\rho ^{2}}}}}\exp \left(-{\frac {1}{2\left[1-\rho ^{2}\right]}}\left[\left({\frac {x-\mu _{X}}{\sigma _{X}}}\right)^{2}-2\rho \left({\frac {x-\mu _{X}}{\sigma _{X}}}\right)\left({\frac {y-\mu _{Y}}{\sigma _{Y}}}\right)+\left({\frac {y-\mu _{Y}}{\sigma _{Y}}}\right)^{2}\right]\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bf91aebe806d84bb97ab95715e8e10e619387356)

![{\displaystyle \mu _{1,\ldots,N}(\mathbf {x})\mathrel {\stackrel {\mathrm {def} {=}} \mu _{r_{1},\ldots,r_ {N}}(\mathbf {x} )\mathrel {\stackrel {\mathrm {def} }{=}} \operatorname {E} \left[\prod _{j=1}^{N}X_{j}^{r_{j}}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e19f7eec8adb98477e74dd88285ec1a07ce29aef)

![{\displaystyle {\begin{aligned}&\имя_оператора {E} [X_{1}X_{2}X_{3}X_{4}X_{5}X_{6}]\\[8pt]={}&\имя_оператора {E} [X_{1}X_{2}]\имя_оператора {E} [X_{3}X_{4}]\имя_оператора {E} [X_{5}X_{6}]+\имя_оператора {E} [X_{1}X_{2}]\имя_оператора {E} [X_{3}X_{5}]\имя_оператора {E} [X_{4}X_{6}]+\имя_оператора {E} [X_{1}X_{2}]\имя_оператора {E} [X_{3}X_{6}]\имя_оператора {E} [X_{4}X_{5}]\\[4pt]&{}+\имя_оператора {E} [X_{1}X_{3}]\имя_оператора {E} [X_{2}X_{4}]\имя_оператора {E} [X_{5}X_{6}]+\имя_оператора {E} [X_{1}X_{3}]\имя_оператора {E} [X_{2}X_{5}]\имя_оператора {E} [X_{4}X_{6}]+\имя_оператора {E} [X_{1}X_{3}]\имя_оператора {E} [X_{2}X_{6}]\имя_оператора {E} [X_{4}X_{5}]\\[4pt]&{}+\имя_оператора {E} [X_{1}X_{4}]\имя_оператора {E} [X_{2}X_{3}]\имя_оператора {E} [X_{5}X_{6}]+\имя_оператора {E} [X_{1}X_{4}]\имя_оператора {E} [X_{2}X_{5}]\имя_оператора {E} [X_{3}X_{6}]+\имя_оператора {E} [X_{1}X_{4}]\имя_оператора {E} [X_{2}X_{6}]\имя_оператора {E} [X_{3}X_{5}]\\[4pt]&{}+\имя_оператора {E} [X_{1}X_{5}]\имя_оператора {E} [X_{2}X_{3}]\имя_оператора {E} [X_{4}X_{6}]+\имя_оператора {E} [X_{1}X_{5}]\имя_оператора {E} [X_{2}X_{4}]\имя_оператора {E} [X_{3}X_{6}]+\имя_оператора {E} [X_{1}X_{5}]\имя_оператора {E} [X_{2}X_{6}]\имя_оператора {E} [X_{3}X_{4}]\\[4pt]&{}+\имя_оператора {E} [X_{1}X_{6}]\имя_оператора {E} [X_{2}X_{3}]\имя_оператора {E} [X_{4}X_{5}]+\имя_оператора {E} [X_{1}X_{6}]\имя_оператора {E} [X_{2}X_{4}]\имя_оператора {E} [X_{3}X_{5}]+\имя_оператора {E} [X_{1}X_{6}]\имя_оператора {E} [X_{2}X_{5}]\имя_оператора {E} [X_{3}X_{4}].\end{выровнено}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0517839a9528128fa6d69cedfe4f5003a34716f4)

![{\displaystyle [1,\ldots,2\лямбда]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a605bf32a38577fe9df1bc5715a4a3cac5869832)

![{\displaystyle {\begin{aligned}\operatorname {E} \left[X_{i}^{4}\right]&=3\sigma _{ii}^{2}\\[4pt]\operatorname {E} \left[X_{i}^{3}X_{j}\right]&=3\sigma _{ii}\sigma _{ij}\\[4pt]\operatorname {E} \left[X_{i}^{2}X_{j}^{2}\right]&=\sigma _{ii}\sigma _{jj}+2\sigma _{ij}^{2}\\[4pt]\operatorname {E} \left[X_{i}^{2}X_{j}X_{k}\right]&=\sigma _{ii}\sigma _{jk}+2\sigma _{ij}\sigma _{ik}\\[4pt]\имя_оператора {E} \left[X_{i}X_{j}X_{k}X_{n}\right]&=\sigma _{ij}\sigma _{kn}+\sigma _{ik}\sigma _{jn}+\sigma _{in}\sigma _{jk}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4e08f5bc180e3f1f4379c1026100e833ea85de97)

![{\displaystyle E\left[X_{i}X_{j}X_{k}X_{n}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/0b4bbbf2becaf15b246898e928a37e7d0ab6f93a)

![{\displaystyle \operatorname {E} [X_{i}^{2}X_{k}X_{n}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f7bc1920d0e524aa567ca471bdb54dcf7ef7e673)

![{\displaystyle \ln L({\boldsymbol {x}})=-{\frac {1}{2}}\left[\ln(|{\boldsymbol {\Sigma }}|\,)+({\boldsymbol {x}}-{\boldsymbol {\mu }})'{\boldsymbol {\Sigma }}^{-1}({\boldsymbol {x}}-{\boldsymbol {\mu }})+k\ln(2\pi )\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4ad05643016bbf6ac76a826320bea00704b50982)

![{\displaystyle E\left[{\widehat {\boldsymbol {\Sigma }}}\right]={\frac {n-1}{n}}{\boldsymbol {\Sigma }}.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/12908e94489d8fcdd7c2aa360d3ce85c26bc611a)

![{\displaystyle {\widehat {\boldsymbol {\Sigma }}}={\frac {1}{n-1}}\sum _{i=1}^{n}(\mathbf {x} _{i}-{\overline {\mathbf {x} }})(\mathbf {x} _{i}-{\overline {\mathbf {x} }})^{\rm {T}}={\frac {1}{n-1}}\left[X'\left(I-{\frac {1}{n}}\cdot J\right)X\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b483843b0f64ecbfea751011ef0ab8e61c7f0dcc)

![{\displaystyle {\begin{aligned}&{\widehat {\boldsymbol {\Sigma }}}={1 \over n}\sum _{j=1}^{n}\left(\mathbf {x} _ {j}-{\bar {\mathbf {x} }}\right)\left(\mathbf {x} _{j}-{\bar {\mathbf {x} }}\right)^{\mathrm {T} }\\&A={1 \over 6n}\sum _{i=1}^{n}\sum _{j=1}^ {n}\left[(\mathbf {x} _{i}-{\bar {\mathbf {x} }})^{\mathrm {T} }\;{\widehat {\boldsymbol {\Sigma }}}^{-1}(\mathbf {x} _{j}-{\bar {\mathbf {x} }})\right]^{3}\\&B={\sqrt {\frac {n }{8k(k+2)}}}\left\{{1 \over n}\sum _{i=1}^{n}\left[(\mathbf {x} _{i}-{\bar {\mathbf {x} }})^{\mathrm {T} }\;{\widehat {\boldsymbol {\Sigma }}}^{-1}(\mathbf {x} _{i}-{\bar {\mathbf {x} }})\right]^{2}-k(k+2)\right\}\end{align}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2d6fcd342cc6e6df3c6fcd10852c7908e248829d)