Трюк с репараметризацией

Трюк репараметризации (он же «оценщик градиента репараметризации») — это метод, используемый в статистическом машинном обучении , в частности в вариационном выводе , вариационных автоэнкодерах и стохастической оптимизации . Он позволяет эффективно вычислять градиенты через случайные величины , что позволяет оптимизировать параметрические вероятностные модели с использованием стохастического градиентного спуска и уменьшать дисперсию оценщиков .

Он был разработан в 1980-х годах в исследовании операций под названием «путевые градиенты» или «стохастические градиенты». [1] [2] Его использование в вариационном выводе было предложено в 2013 году. [3]

Математика

Пусть — случайная величина с распределением , где — вектор, содержащий параметры распределения.

Оценщик REINFORCE

Рассмотрим целевую функцию вида: Без трюка с репараметризацией оценка градиента может быть сложной, поскольку параметр появляется в самой случайной величине. Более подробно, мы должны статистически оценить: Оценщик REINFORCE, широко используемый в обучении с подкреплением и особенно в градиенте политики , [4] использует следующее равенство: Это позволяет оценить градиент: Оценщик REINFORCE имеет высокую дисперсию, и было разработано много методов для уменьшения его дисперсии . [5]

Оценщик репараметризации

Трюк с репараметризацией выражается как: Здесь, — детерминированная функция, параметризованная , а — шумовая переменная, взятая из фиксированного распределения . Это дает: Теперь градиент можно оценить как:

Примеры

Для некоторых распространенных распределений прием репараметризации принимает особые формы:

Нормальное распределение : Для мы можем использовать:

Экспоненциальное распределение : Для мы можем использовать: Дискретное распределение может быть перепараметризовано с помощью распределения Гумбеля (прием Гумбеля-softmax или «конкретное распределение»). [6]

В общем случае любое распределение, дифференцируемое по своим параметрам, может быть репараметризовано путем инвертирования функции CDF с несколькими переменными, а затем применения неявного метода. См. [1] для описания и применения к распределениям Гамма- Бета , Дирихле и фон Мизеса .

Приложения

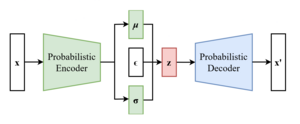

Вариационный автоэнкодер

В вариационных автоэнкодерах (VAE) целевая функция VAE, известная как нижняя граница доказательств (ELBO), определяется следующим образом:

где — кодер (модель распознавания), — декодер (генеративная модель), а — априорное распределение по скрытым переменным. Градиент ELBO относительно — это просто, но градиент относительно требует трюка. Выразим операцию выборки как: где и — это выходы сети кодера, а обозначает поэлементное умножение . Тогда имеем где . Это позволяет нам оценить градиент с помощью выборки Монте-Карло: где и для .

Эта формулировка позволяет осуществлять обратное распространение ошибки через процесс выборки, что позволяет проводить сквозное обучение модели VAE с использованием стохастического градиентного спуска или его вариантов.

Вариационный вывод

В более общем смысле, этот прием позволяет использовать стохастический градиентный спуск для вариационного вывода . Пусть вариационная цель (ELBO) имеет вид: Используя прием репараметризации, мы можем оценить градиент этой цели относительно :

Выбывать

Трюк репараметризации был применен для уменьшения дисперсии в dropout , метод регуляризации в нейронных сетях. Исходный dropout может быть репараметризован с помощью распределений Бернулли : где — весовая матрица, — вход, а — (фиксированные) показатели dropout.

В более общем смысле, могут использоваться и другие распределения, отличные от распределения Бернулли, например, гауссовский шум: где и , причем и являются средним значением и дисперсией -го выходного нейрона. Прием репараметризации может быть применен ко всем таким случаям, что приводит к вариационному методу выпадения . [7]

Смотрите также

Ссылки

- ^ ab Фигурнов, Михаил; Мохамед, Шакир; Мних, Андрей (2018). «Неявные градиенты репараметризации». Достижения в области нейронных систем обработки информации . 31. Curran Associates, Inc.

- ^ Фу, Майкл С. «Оценка градиента». Справочники по исследованию операций и науке управления 13 (2006): 575-616.

- ^ Кингма, Дидерик П.; Веллинг, Макс (10 декабря 2022 г.). «Автокодирование вариационного Байеса». arXiv : 1312.6114 [stat.ML].

- ^ Уильямс, Рональд Дж. (1992-05-01). «Простые статистические алгоритмы следования градиенту для коннекционистского обучения с подкреплением». Машинное обучение . 8 (3): 229–256. doi :10.1007/BF00992696. ISSN 1573-0565.

- ^ Гринсмит, Эван; Бартлетт, Питер Л.; Бакстер, Джонатан (2004). «Методы снижения дисперсии для оценок градиента в обучении с подкреплением». Журнал исследований машинного обучения . 5 (ноябрь): 1471–1530. ISSN 1533-7928.

- ^ Мэддисон, Крис Дж.; Мних, Андрей; Тех, Йи Уай (2017-03-05). «Конкретное распределение: непрерывная релаксация дискретных случайных величин». arXiv : 1611.00712 [cs.LG].

- ^ Кингма, Дюрк П.; Салиманс, Тим; Уэллинг, Макс (2015). «Вариационное выпадение и трюк с локальной репараметризацией». Достижения в области нейронных систем обработки информации . 28. arXiv : 1506.02557 .

Дальнейшее чтение

- Ruiz, Francisco R.; AUEB, Titsias RC; Blei, David (2016). «Градиент обобщенной репараметризации». Достижения в области нейронных систем обработки информации . 29. arXiv : 1610.02287 . Получено 23 сентября 2024 г.

- Чжан, Ченг; Бутепаж, Джудит; Кьельстром, Хедвиг; Мандт, Стефан (01.08.2019). «Достижения в вариационном выводе». Труды IEEE по анализу шаблонов и машинному интеллекту . 41 (8): 2008–2026. doi :10.1109/TPAMI.2018.2889774. ISSN 0162-8828. PMID 30596568.

- Мохамед, Шакир (29 октября 2015 г.). «Машинное обучение: трюк дня (4): трюки репараметризации». The Spectator . Получено 23 сентября 2024 г. .

![{\displaystyle L(\phi)=\mathbb {E} _{z\sim q_ {\phi }(z)}[f(z)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/12b7e63c6c929b96bb82294ad114b9b75af2021e)

![{\displaystyle \nabla _{\phi }L(\phi )=\int dz\;q_ {\phi }(z)\nabla _{\phi }(\ln q_{\phi }(z))f( z)=\mathbb {E} _{z\sim q_{\phi }(z)}[\nabla _{\phi }(\ln q_{\phi }(z))f(z)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/255582bef774f93594be2bfaf648443f1bb2b75c)

![{\displaystyle L(\phi )=\mathbb {E} _{\epsilon \sim p(\epsilon )}[f(g_{\phi }(\epsilon ))]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/11280ed94cf02182e0ffc220b1e7c0f03d8095eb)

![{\displaystyle \nabla _{\phi }L(\phi )=\mathbb {E} _{\epsilon \sim p(\epsilon )}[\nabla _{\phi }f(g_{\phi }(\epsilon ))]\approx {\frac {1}{N}}\sum _{i=1}^{N}\nabla _{\phi }f(g_{\phi }(\epsilon _{i}))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aada21df5f011629e59940bbf7e0f0e00a4defcf)

![{\displaystyle {\text{ELBO}}(\phi,\theta)=\mathbb {E} _{z\sim q_{\phi }(z|x)}[\log p_{\theta }(x| z)]-D_{\text{KL}}(q_{\phi }(z|x)||p(z))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a406896a45c3d0d810e5ca4068a9a1668f5ec80c)

![{\displaystyle \mathbb {E} _{z\sim q_{\phi }(z|x)}[\nabla _{\theta }\log p_{\theta }(x|z)]\approx {\frac {1}{L}}\sum _{l=1}^{L}\nabla _{\theta }\log p_{\theta }(x|z_{l})}](https://wikimedia.org/api/rest_v1/media/math/render/svg/59392139d20fea41dc73ee321bcf8fbfc98d8cfa)

![{\displaystyle \nabla _ {\phi }{\text{ELBO}}(\phi ,\theta )=\mathbb {E} _ {\epsilon \sim {\mathcal {N}}(0,I)}[ \nabla _{\phi }\log p_{\theta }(x|z)+\nabla _{\phi }\log q_{\phi }(z|x)-\nabla _{\phi }\log p (з)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/960d4e548c3061f813d40720ba871dcdb3d7f0b7)

![{\displaystyle \nabla _{\phi }{\text{ELBO}}(\phi ,\theta )\approx {\frac {1}{L}}\sum _{l=1}^{L}[\nabla _{\phi }\log p_{\theta }(x|z_{l})+\nabla _{\phi }\log q_{\phi }(z_{l}|x)-\nabla _{\phi }\log p(z_{l})]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/4a361f876e9a9835f98dff9c96ed1cdc474b165b)

![{\displaystyle {\text{ELBO}}(\phi)=\mathbb {E} _{z\sim q_ {\phi }(z)}[\log p(x,z)-\log q_{\phi }(г)]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/9604d2305aceec2e141cc9899d26ae598a159281)

![{\displaystyle \nabla _{\phi }{\text{ELBO}}(\phi )\approx {\frac {1}{L}}\sum _{l=1}^{L}\nabla _{\phi }[\log p(x,g_{\phi }(\epsilon _{l}))-\log q_{\phi }(g_{\phi }(\epsilon _{l}))],\quad \epsilon _{l}\sim p(\epsilon )}](https://wikimedia.org/api/rest_v1/media/math/render/svg/ae3a3caaa0bb820b725444c280e21fcbca5a6193)